Einleitung

Eine Einführung in Moral und Ethik unter besonderer Berücksichtigung von Bewusstsein öffnet uns die Tür zu einem der faszinierendsten und zugleich herausforderndsten Diskursfelder der Philosophie. In einer Welt, die zunehmend von technologischem Fortschritt und künstlicher Intelligenz (KI) geprägt ist, gewinnen Fragen zur Moral und Ethik nicht nur an Komplexität, sondern auch an Dringlichkeit. Diese Betrachtung zielt darauf ab, die Grundlagen von Moral und Ethik zu skizzieren und zu verstehen, wie das menschliche Bewusstsein diese Konzepte beeinflusst und umgekehrt.

Ethik, oftmals gleichbedeutend mit Moralphilosophie, befasst sich mit Fragen des richtigen und falschen Verhaltens. Sie erforscht die Natur moralischer Urteile und Werte sowie die Kriterien für das, was moralisch gut oder schlecht, richtig oder falsch ist. Moral hingegen bezieht sich auf die tatsächlichen Überzeugungen, Werte und Regeln, die innerhalb einer Gruppe oder Gesellschaft geteilt und praktiziert werden. Ethik ist also die Theorie, während Moral die Praxis darstellt.

Zu Beginn müssen wir erkennen, dass unsere moralischen und ethischen Überzeugungen nicht im Vakuum existieren; sie sind vielmehr tief in unserem Bewusstsein verwurzelt. Das menschliche Bewusstsein, oft beschrieben als die Fähigkeit, eigene Gedanken, Gefühle, und Erfahrungen zu erleben und zu reflektieren, spielt eine entscheidende Rolle in unserem Verständnis von Moral und Ethik. Es ermöglicht uns, über unsere unmittelbaren Instinkte hinaus zu denken und komplexe moralische Entscheidungen zu treffen.

Die Frage nach dem Ursprung unserer moralischen Intuitionen und ethischen Prinzipien führt uns tief in die philosophische und psychologische Erforschung des menschlichen Geistes. Einige Theorien schlagen vor, dass unsere moralischen Überzeugungen teilweise biologisch vorprogrammiert sind, ein Produkt der Evolution, das uns hilft, sozial zu kooperieren und zu überleben. Andere Ansätze betonen die Rolle der Kultur und Erziehung, die unsere moralischen und ethischen Ansichten formen.

Die Entwicklung des Bewusstseins hat uns die Fähigkeit verliehen, über das Hier und Jetzt hinauszudenken, uns in andere hineinzuversetzen und die langfristigen Konsequenzen unseres Handelns zu bedenken. Diese Fähigkeit zur Empathie und Vorausschau ist grundlegend für unser Verständnis von Moral und Ethik. Sie ermöglicht es uns, Regeln und Normen zu entwickeln, die über die einfache Maximierung des eigenen Nutzens hinausgehen.

Im Kontext der heutigen Gesellschaft, in der KI und andere Technologien eine immer größere Rolle spielen, stellt sich die Frage, wie diese Entwicklungen unser Verständnis von Moral und Ethik beeinflussen. KI-Systeme, die Entscheidungen treffen, die moralische und ethische Dimensionen haben, werfen die Frage auf, nach welchen Prinzipien sie programmiert werden sollten. Das Bewusstsein, oder dessen Fehlen, in diesen Systemen führt zu grundlegenden Fragen über Verantwortung, Schuld und die Natur moralischer Agenten.

Die Diskussion über Moral und Ethik im Lichte des Bewusstseins führt uns zu einer Auseinandersetzung mit einigen der grundlegendsten Fragen der menschlichen Existenz: Was bedeutet es, ein gutes Leben zu führen? Wie sollen wir handeln? Und wie können wir sicherstellen, dass die Technologien, die wir entwickeln, unsere moralischen und ethischen Werte widerspiegeln?

In dieser Einführung wollen wir die verschiedenen Dimensionen von Moral und Ethik erkunden, von den klassischen philosophischen Theorien bis hin zu den aktuellen Debatten über KI und Bewusstsein. Wir werden untersuchen, wie unser Verständnis von Moral und Ethik durch das menschliche Bewusstsein geformt wird und wie dieses Verständnis wiederum unsere Gesellschaft und die Entwicklung technologischer Innovationen beeinflusst.

Das Ziel ist es, ein tieferes Verständnis dafür zu entwickeln, wie moralische und ethische Prinzipien in unserem täglichen Leben und in der größeren Gesellschaft funktionieren, und zu erkennen, wie wichtig es ist, diese Prinzipien bewusst zu gestalten und zu leben. Durch die Berücksichtigung des Bewusstseins in der Moral- und Ethikdiskussion können wir hoffen, nicht nur die philosophischen Grundlagen dieser Themen zu verstehen, sondern auch praktische Wege zu finden, um unsere Welt zu einem gerechteren und ethischeren Ort zu machen.

Kulturtechniken

Die Abbildung 1 präsentiert ein komplexes Modell, das Kulturtechnik in der menschlichen Geschichte mit der Entwicklung des Bewusstseins und der Ethik verknüpft. Es legt nahe, dass mit jeder technologischen Ära – markiert durch Feuer & Schrift, Buchdruck & Optik, Mechanisierung & Mobilität, bis hin zur künstlichen Intelligenz – eine parallele Entwicklung im menschlichen Verständnis und Umgang mit Technologie stattfindet. Diese Entwicklungen beeinflussen das kollektive Bewusstsein und spiegeln sich in der Moral und Ethik der Gesellschaft wider.

Die Grafik unterteilt die technologische Entwicklung in vier Phasen. Die erste Phase, symbolisiert durch „Feuer & Schrift“, könnte als die Dämmerung des menschlichen Bewusstseins angesehen werden, in der die Technologie als etwas Göttliches betrachtet wurde, ein Werkzeug der Götter. Die zweite Phase, geprägt durch „Buchdruck & Optik“, markiert eine Zeit, in der Wissen durch die Wissenschaft gefördert und demokratisiert wurde. Die dritte Phase, gekennzeichnet durch Mechanisierung und Mobilität, zeigt eine Gesellschaft, die als Verbraucher agiert, wobei die Technologie dazu dient, das tägliche Leben zu erleichtern und zu beschleunigen. Schließlich verweist die vierte Phase auf „KI – bewusste Wesen“ und wirft die Frage auf, wie die Gesellschaft mit der Vorstellung umgeht, dass Technologie das Potenzial hat, ein Bewusstsein zu erlangen.

Die Grafik verbindet diese technologischen Phasen mit der Entwicklung der menschlichen Ethik und Moral. Das grüne Kreissegment stellt den fortwährenden Zyklus des menschlichen Handelns dar, welches von Bewusstsein geleitet wird und sich innerhalb ethischer und moralischer Rahmenbedingungen abspielt. Der Text „Nutzen von Technik ohne tieferes Verständnis“ weist auf eine Kritik hin, nämlich dass Technologien oft benutzt werden, ohne dass ein grundlegendes Verständnis für ihre Bedeutung und Auswirkungen vorhanden ist. Dies führt zu einer Dichotomie zwischen Weisheit und Stumpfheit, zwischen dem tiefgründigen Verstehen der Technologie und ihrer oberflächlichen Nutzung.

Dieses Modell kann als Warnung interpretiert werden, dass der bloße Fortschritt in der Technologie ohne ein entsprechendes Wachstum in unserem moralischen und ethischen Verständnis gefährlich sein kann. Es fordert uns auf, über die einfache Nutzung der Technologie hinauszugehen und zu verstehen, wie sie unser Leben und unsere Gesellschaft beeinflusst. Diese Einsicht ist entscheidend, wenn wir uns der Künstlichen Intelligenz nähern, die das Potenzial hat, autonom zu handeln und möglicherweise ein eigenes Bewusstsein zu entwickeln.

Die Herausforderung liegt darin, eine Balance zwischen technologischer Entwicklung und ethischem Fortschritt zu finden. Es genügt nicht, Technologien zu schaffen; wir müssen auch die ethischen Rahmenbedingungen schaffen, innerhalb derer diese Technologien operieren. Das Bewusstsein spielt dabei eine Schlüsselrolle – es ist der Filter, durch den wir unsere Technologien betrachten, bewerten und letztendlich einsetzen.

Der Dialog zwischen Technologie und Ethik ist nicht neu, aber er wird immer dringlicher, je fortgeschrittener und autonomer unsere Technologien werden. Diese Diskussion muss sowohl auf individueller Ebene – in Bezug auf unser eigenes Verhalten und unsere Entscheidungen – als auch auf gesellschaftlicher Ebene – in Bezug auf Regulierung, Gesetzgebung und Bildung – geführt werden.

Die implizite Frage, die dieses Bild aufwirft, lautet: „Wie werden wir uns entscheiden?“ Wählen wir den Weg der Weisheit, indem wir unsere technologische Entwicklung mit einem tiefen moralischen und ethischen Verständnis untermauern? Oder gehen wir den Weg der Stumpfheit, indem wir Technologie blind vorantreiben, ohne die moralischen und ethischen Implikationen zu berücksichtigen?

Diese Einführung in Moral und Ethik unter besonderer Berücksichtigung von Bewusstsein hat das Ziel, ein komplexes und vielschichtiges Bild der menschlichen Geschichte und ihrer Wechselwirkung mit Technologie zu skizzieren. Sie bietet einen Ausgangspunkt für tiefer gehende Untersuchungen und Diskussionen, die für das Verständnis unserer gegenwärtigen Lage und die Gestaltung unserer Zukunft entscheidend sind. Es geht darum, ein tiefes Verständnis dafür zu entwickeln, wie wir als Individuen und als Gesellschaft mit der Technologie umgehen, die wir erschaffen, und wie wir sicherstellen können, dass diese Technologie unsere ethischen und moralischen Werte widerspiegelt und fördert.

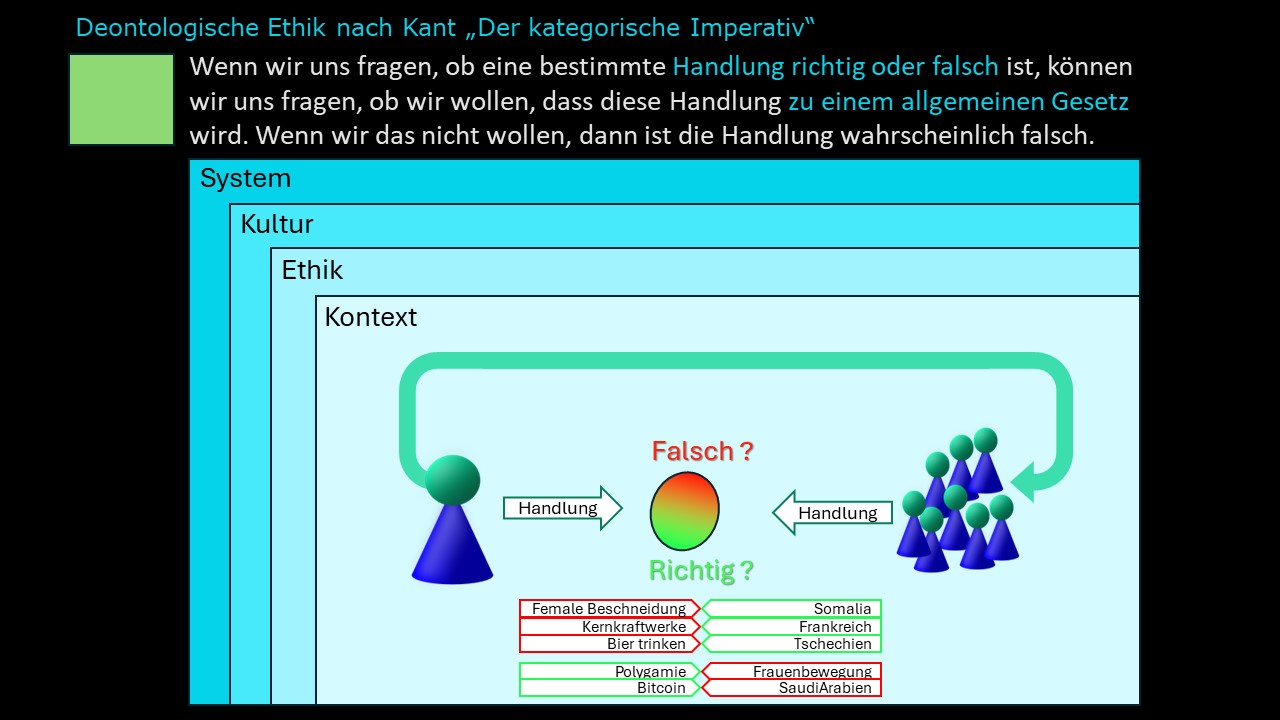

Deontologische Ethik nach Immanuel Kant

Die Abbildung 2 zeigt eine visuelle Darstellung der deontologischen Ethik nach Immanuel Kant, insbesondere bezogen auf den kategorischen Imperativ. Die Darstellung versucht, die Anwendung des kategorischen Imperativs auf verschiedene Handlungen im Kontext verschiedener kultureller Normen und Wertsysteme zu veranschaulichen.

Die deontologische Ethik, die von Immanuel Kant im 18. Jahrhundert formuliert wurde, ist eine normative Theorie, die die Moralität einer Handlung auf der Grundlage spezifischer Regeln und Pflichten bewertet, unabhängig von den Konsequenzen. Im Zentrum steht der kategorische Imperativ, Kants berühmtes Prinzip, das als Test für die moralische Richtigkeit einer Handlung dient. Dieses Prinzip fordert, dass wir nur nach derjenigen Maxime handeln sollen, von der wir zugleich wollen können, dass sie ein allgemeines Gesetz werde.

Die Aussage im oberen Teil des Bildes paraphrasiert den kategorischen Imperativ und stellt fest, dass eine Handlung wahrscheinlich falsch ist, wenn wir nicht wollen, dass sie zu einem allgemeinen Gesetz wird. Das Bild legt nahe, dass der kategorische Imperativ als eine Art Wegweiser oder Filter für die Beurteilung von Handlungen dient, durch den wir bestimmen können, ob eine Handlung richtig oder falsch ist.

Unterhalb dieser Aussage sehen wir eine Aufschlüsselung verschiedener Ebenen, die bei der ethischen Beurteilung einer Handlung berücksichtigt werden sollten: das System, die Kultur, die Ethik und der Kontext. Dies deutet darauf hin, dass ethische Urteile nicht isoliert gefällt werden sollten, sondern in einem größeren Rahmen, der verschiedene Einflussfaktoren und die Komplexität menschlicher Gesellschaften berücksichtigt.

Im unteren Teil des Bildes befindet sich ein Diagramm, das eine Skala von „Richtig“ zu „Falsch“ zeigt, mit verschiedenen Handlungen, die als Beispiele für moralische Dilemmata dienen. Jede Handlung ist in einen spezifischen kulturellen oder gesellschaftlichen Kontext eingebettet, wie z.B. „Female Genital Mutilation“ (FGM) in Somalia, Kernkraftwerke in Frankreich, Biertrinken in Tschechien, Polygamie, Bitcoin und die Frauenbewegung in Saudi-Arabien.

Die farbliche Hervorhebung und Positionierung dieser Handlungen auf der Skala deutet darauf hin, dass die moralische Bewertung einer Handlung von der Perspektive abhängt, von der aus sie betrachtet wird. Was in einer Kultur als moralisch akzeptabel angesehen wird, kann in einer anderen als unethisch gelten. Dies spiegelt die Komplexität der moralischen Relativität wider und wirft die Frage auf, wie universelle ethische Prinzipien in einer vielfältigen Welt angewendet werden können.

Die Platzierung von Figuren neben den Handlungen (siehe Abbildung 2) könnte darauf hindeuten, dass Individuen oder Gruppen in unterschiedlichem Maße von den moralischen und ethischen Implikationen dieser Handlungen betroffen sind. Die Darstellung erinnert uns daran, dass ethische Überlegungen oft vielschichtige soziale Dynamiken betreffen und dass die Beteiligung verschiedener Stakeholder und deren Perspektiven unerlässlich ist.

Die Aufnahme von konkreten Beispielen wie „Female Genital Mutilation“ in Somalia und die Frauenbewegung in Saudi-Arabien hebt hervor, dass die ethischen Urteile, die in einem Kontext als richtig gelten, in einem anderen tiefgreifend in Frage gestellt werden können. Die ethische Debatte um solche Praktiken ist häufig ein Kampf zwischen kulturell relativistischen Ansichten und universalistischen ethischen Normen.

Die Erwähnung von Kernkraftwerken und Bitcoin weist auf technologische und wirtschaftliche Dimensionen ethischer Überlegungen hin. Im Fall von Kernkraftwerken können die ethischen Fragen von Umweltschutz und langfristiger Nachhaltigkeit bis hin zu Risikobewertung und Sicherheit reichen. Bitcoin könnte Fragen nach Wirtschaftsethik, finanzieller Stabilität und dem Einfluss von Kryptowährungen auf traditionelle Finanzsysteme aufwerfen.

Die Verwendung der Farben auf der Skala von „Falsch“ zu „Richtig“ impliziert ein Spektrum, nicht eine Dichotomie. Dies steht im Einklang mit der Realität ethischer Entscheidungsfindung, die selten schwarz-weiß ist, sondern vielmehr von Nuancen und Kontext abhängt.

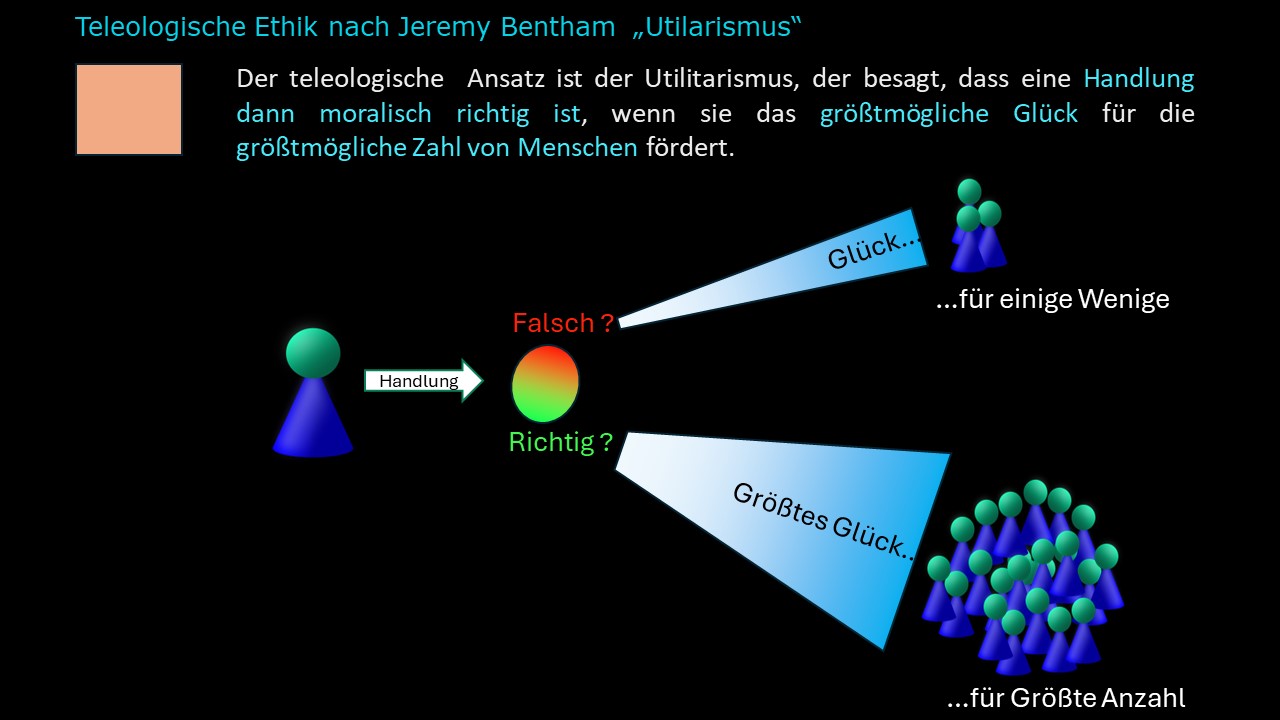

Teleologische Ethik nach Bentham

Im Laufe der menschlichen Geschichte haben Philosophen nach einem soliden Fundament für Ethik und Moral gesucht. Einer der einflussreichsten Ansätze, die in diesem Kontext entstanden sind, ist der Utilitarismus, eine Form der teleologischen Ethik, die auf die Konsequenzen von Handlungen fokussiert. Jeremy Bentham, der Begründer des Utilitarismus, stellte die These auf, dass Handlungen als moralisch richtig gelten, wenn sie das größtmögliche Glück für die größtmögliche Zahl von Menschen fördern.

Die teleologische Ethik beurteilt moralische Fragen auf Basis der Konsequenzen (telos = Ziel, Zweck). Der Utilitarismus nach Bentham ist in diesem Rahmen eindeutig konsequentialistisch: Eine Handlung wird nicht anhand ihrer Absichten oder intrinsischen Qualitäten, sondern nach den resultierenden Folgen beurteilt. Die Maxime „das größte Glück für die größte Zahl“ ist der entscheidende Maßstab.

Die Abbildung 3 versucht, das abstrakte Konzept des Utilitarismus in eine visuelle Sprache zu übersetzen. Im Zentrum steht die Frage nach dem moralischen Wert von Handlungen, die durch ein einfaches Symbol – eine Spielfigur – dargestellt wird. Diese Figur steht vor einem Glücksrad, das die dichotome moralische Beurteilung repräsentiert: Richtig oder Falsch. Die Handlung, die von der Spielfigur ausgeht, wird bewertet nach dem Prinzip des größtmöglichen Glücks, das durch eine Gruppe von Figuren symbolisiert wird. Es gibt eine kleinere Gruppe, die „Glück für einige Wenige“ darstellt, und eine größere, die „Glück für die größte Anzahl“ repräsentiert

Was bedeutet „das größte Glück“? Bentham verstand darunter eine Form des Hedonismus, der auf die Maximierung von Freude und die Minimierung von Schmerz abzielt. In der Grafik wird dieses Glück durch die größere Ansammlung von Figuren dargestellt. Dies visualisiert die Präferenz für Handlungen, die vielen Individuen Nutzen bringen, anstatt nur einigen wenigen.

Benthams Ansatz ist in hohem Maße quantitativ. Er glaubte, dass man Glück messen und in einer Art Kalkül summieren kann. Dieser Aspekt wird in der Grafik durch die Aufteilung der Figuren veranschaulicht. Die Herausforderung besteht darin, wie man Glück und Leid in konkreten Situationen tatsächlich misst und gegeneinander aufwiegt.

Eine der größten Herausforderungen für den Utilitarismus ist die Quantifizierung von Glück. Wie misst man das Wohlergehen einer Gesellschaft? Können wir wirklich in Einheiten von Glück rechnen, und ist es fair, das Leid einiger für das Glück vieler zu opfern? Der Utilitarismus wird oft dafür kritisiert, dass er das Wohl des Einzelnen dem Kollektiv unterordnet. Das kann zu Situationen führen, in denen die Rechte von Individuen missachtet werden, solange dies dem größeren Nutzen dient.

Es stellt sich die Frage, wie anwendbar Benthams Prinzipien in der komplexen Realität sind. Die Welt, in der wir leben, ist geprägt von einer Vielzahl von Interessen, Identitäten und Situationen, die sich nicht leicht in ein einfaches Glücksmodell pressen lassen.

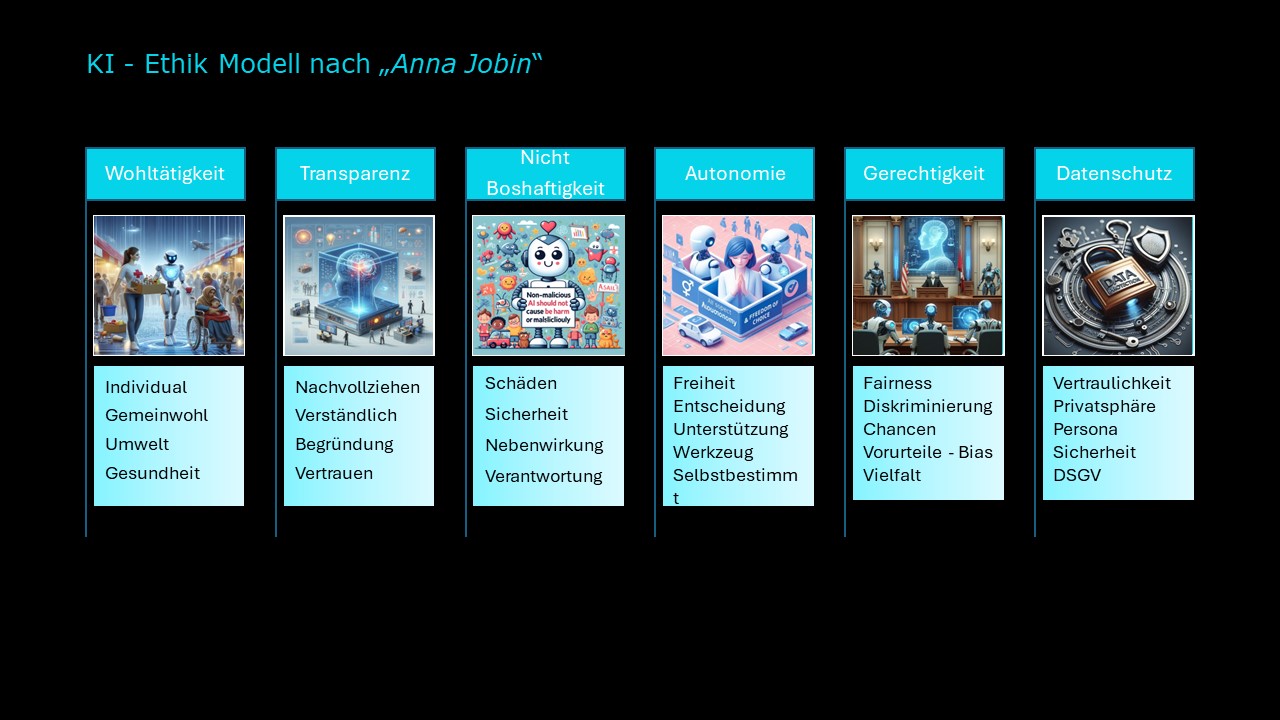

Ethik Modell für KI. Jobin

In der heutigen Zeit, in der die Entwicklung künstlicher Intelligenz (KI) rasant fortschreitet, wächst die Notwendigkeit, ethische Überlegungen in den Mittelpunkt dieser technologischen Revolution zu stellen. Das KI-Ethikmodell nach Anna Jobin (Abbildung 4) bietet einen Rahmen für diese Diskussion, indem es grundlegende Prinzipien identifiziert, die bei der Gestaltung und Implementierung von KI-Systemen zu beachten sind. Diese Prinzipien – Wohltätigkeit, Transparenz, Nicht Boshaftigkeit, Autonomie, Gerechtigkeit und Datenschutz – bilden das Fundament eines verantwortungsvollen Umgangs mit KI.

Wohltätigkeit:

Das Prinzip der Wohltätigkeit, das auch als „Benefizienz“ bekannt ist,

verpflichtet uns, positive Wirkungen zu maximieren und Schaden zu vermeiden. Im

Kontext der KI bedeutet dies, dass Entwickler und Nutzer von KI-Technologien

stets das Wohl des Individuums, das Gemeinwohl, den Umweltschutz und die

Förderung der Gesundheit im Auge behalten sollten. So könnten KI-Systeme

beispielsweise dazu verwendet werden, personalisierte Behandlungspläne in der

Medizin zu erstellen, die Effizienz im Energieverbrauch zu verbessern oder

Bildungsangebote zu personalisieren und damit den Zugang zur Bildung zu

demokratisieren. In jedem dieser Fälle würde die KI dazu beitragen, das

menschliche Wohlergehen auf vielfältige Weise zu verbessern.

Transparenz:

Transparenz ist das Prinzip, das Nachvollziehbarkeit und Verständlichkeit von

KI-Systemen fordert. Es ist entscheidend, dass Entscheidungen, die von

KI-Systemen getroffen werden, für die Nutzer klar und verständlich sind. Dies

baut Vertrauen auf und ermöglicht es den Nutzern, die Entscheidungsfindung der

KI zu überprüfen. KI-Modelle sollten ihre Vorgehensweisen offenlegen und die

Gründe für ihre Entscheidungen darlegen können. Dadurch wird auch ein

kritischer Diskurs über die Verwendung von KI ermöglicht, der die Gesellschaft

vor potenziellem Missbrauch schützen kann.

Nicht-Boshaftigkeit:

Das Prinzip der Nicht Boshaftigkeit legt

fest, dass KI-Systeme so gestaltet werden müssen, dass sie keine Schäden

verursachen. Dies umfasst sowohl physische als auch psychologische Sicherheit.

KI-Systeme sollten robust gegen Angriffe sein und keine Nebenwirkungen haben,

die Individuen oder Gruppen schaden könnten. Die Verantwortung für die

Handlungen einer KI muss klar definiert sein, um sicherzustellen, dass im Falle

von Fehlverhalten oder Unfällen Verantwortlichkeit gewährleistet ist.

Autonomie:

Autonomie betont die Bedeutung der menschlichen Kontrolle über KI-Systeme. KI

sollte als ein Werkzeug dienen, das Menschen unterstützt und ihre Fähigkeit zur

Selbstbestimmung erweitert, ohne sie zu ersetzen oder ihre

Entscheidungsfreiheit zu untergraben. Dieses Prinzip fordert, dass KI-Systeme

als Partner des Menschen fungieren und ihn in seinen Handlungen unterstützen,

ohne in die Rolle eines unkontrollierbaren Entscheiders zu schlüpfen.

Gerechtigkeit:

Das Prinzip der Gerechtigkeit in der KI-Ethik bezieht sich auf Fairness und

Gleichheit. KI-Systeme sollten so entworfen werden, dass sie alle Menschen

gleich behandeln und diskriminierungsfreie Ergebnisse liefern. Dazu gehört

auch, Voreingenommenheit und Vorurteile, die in Trainingsdatensätzen vorhanden

sein könnten, zu erkennen und zu eliminieren. Gerechtigkeit in der KI fordert

auch die Förderung von Vielfalt und die Gewährleistung, dass KI-Systeme

Chancengleichheit für alle Nutzer bieten.

Datenschutz:

Datenschutz ist ein entscheidendes Element der KI-Ethik, das die Wichtigkeit

des Schutzes persönlicher Daten betont. KI-Systeme müssen so gestaltet sein,

dass sie die Privatsphäre der Nutzer respektieren und ihre Daten sicher

verarbeiten. Dies beinhaltet den Schutz vor unbefugtem Zugriff und die

Einhaltung von Datenschutzgesetzen, wie beispielsweise der europäischen

Datenschutz-Grundverordnung (DSGVO).

Das KI-Ethik-Modell nach Anna Jobin stellt einen vielschichtigen Ansatz dar, der die komplexe Natur der KI und ihre Auswirkungen auf die Gesellschaft widerspiegelt. Es erkennt an, dass die Entwicklung und Anwendung von KI nicht nur eine technische oder wirtschaftliche Herausforderung ist, sondern auch eine tiefgründige ethische und moralische Implikationen enthält.

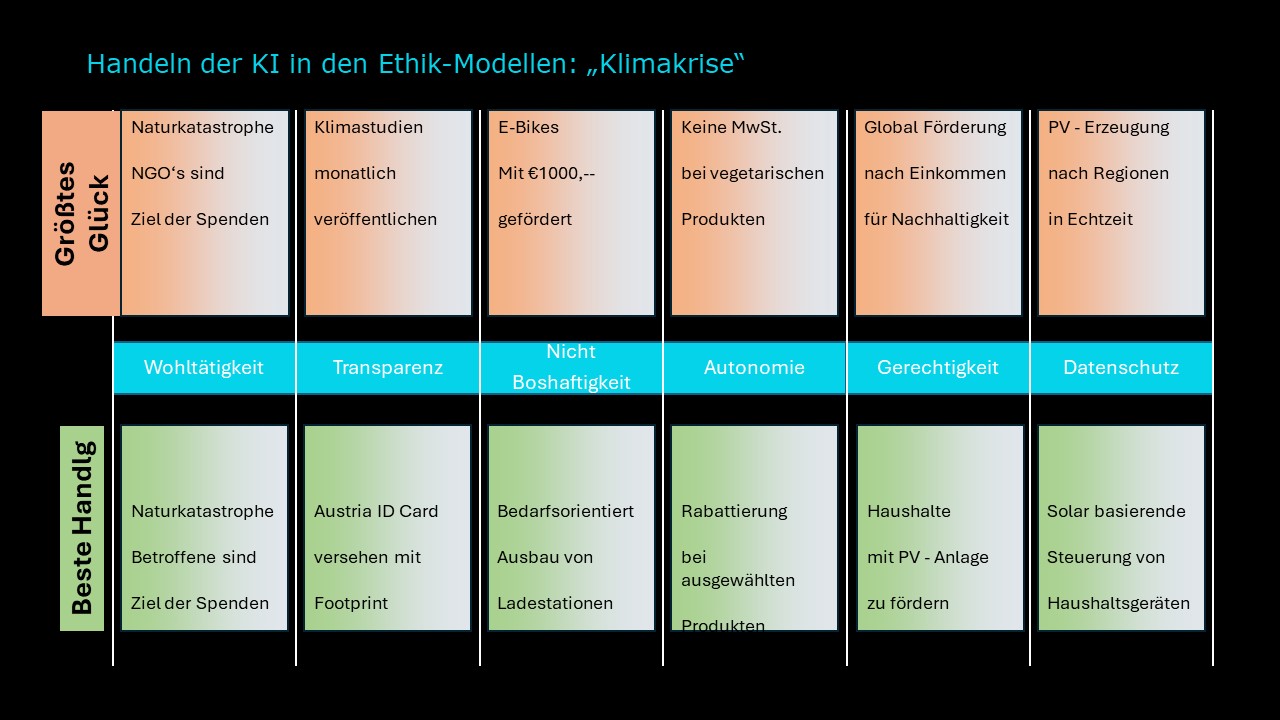

Beispiel „Klimakrise nach Kant und Bentham

In der heutigen Zeit ist die Klimakrise nicht nur ein ökologisches oder wirtschaftliches Problem; sie ist eine ethische Herausforderung, die tief in die Faser der menschlichen Existenz und die Interaktion mit der natürlichen Welt eingreift. Mit dem Aufkommen der künstlichen Intelligenz (KI) stellen sich neue Fragen nach der Verantwortlichkeit und dem moralischen Handeln innerhalb des technologischen Fortschritts. Die von Ethikern und Forschern wie Anna Jobin entwickelten ethischen Modelle bieten ein Gerüst für das Handeln der KI im Kontext solcher globalen Herausforderungen. Die vorliegende Matrix (Abbildung 5) veranschaulicht die Anwendung dieser ethischen Prinzipien, indem sie spezifische Handlungen der KI in Reaktion auf die Klimakrise kartiert.

Wohltätigkeit und KI

Das ethische Prinzip der Wohltätigkeit, angewandt auf KI, erfordert die Fokussierung auf das Wohl des Individuums und der Gesellschaft. Im Angesicht von Naturkatastrophen, welche durch die Klimakrise verstärkt werden, kann die KI zum Beispiel eine Rolle spielen, indem sie das Sammeln und Verteilen von Spenden optimiert. KI-Systeme könnten so programmiert werden, dass sie in Echtzeit auf Katastrophen reagieren, die benötigten Ressourcen identifizieren und sicherstellen, dass die Spenden an die Bedürftigsten gelangen. Ein solches System könnte auch dabei helfen, den langfristigen Wiederaufbau zu planen und so die Widerstandsfähigkeit von Gemeinschaften gegenüber zukünftigen Ereignissen zu stärken. Jedoch müssen dabei auch ethische Bedenken hinsichtlich des Datenschutzes und der Priorisierung berücksichtigt werden, um Diskriminierung zu vermeiden und die Autonomie der betroffenen Gemeinschaften zu wahren.

Transparenz in der Klimakrise

Transparenz ist ein Schlüsselbegriff im Kontext ethischer KI. Die Fähigkeit, Klimastudien nachzuvollziehen und die damit verbundenen Entscheidungen der KI zu verstehen, ist entscheidend für das Vertrauen in diese Technologien. KI kann dazu beitragen, die Komplexität von Klimadaten zu bewältigen und Erkenntnisse auf eine Weise zu präsentieren, die sowohl für Fachleute als auch für Laien nachvollziehbar ist. Dies erfordert klare Richtlinien für die Dateninterpretation und -nutzung. KI-gestützte Systeme könnten zum Beispiel genutzt werden, um die Ergebnisse von Klimamodellen zu visualisieren und so einen leichteren Zugang zu diesen wichtigen Informationen zu schaffen. Allerdings muss sichergestellt werden, dass diese Systeme frei von Voreingenommenheit sind und die Daten auf verantwortungsbewusste Weise verwenden, um das Vertrauen der Öffentlichkeit zu erhalten und zu fördern.

Nicht Boshaftigkeit und ihre Anwendung in der KI

Das Prinzip der Nicht Boshaftigkeit in der Ethik der Künstlichen Intelligenz fordert, dass durch KI-Systeme kein Schaden entstehen darf. Im Kontext der Klimakrise bedeutet das, KI so zu entwickeln, dass sie die Umwelt schützt und nachhaltige Praktiken fördert. Konkret könnte KI in der Förderung von E-Bikes eine Rolle spielen, indem sie Subventionen für umweltfreundliche Transportmittel steuert. Durch die Analyse von Verkehrsdaten und Umweltauswirkungen können Algorithmen herausfinden, wo solche Förderungen die größte positive Wirkung hätten. Auch im Aufbau einer Infrastruktur für erneuerbare Energien könnte KI bedarfsorientiert Ladesäulen und andere notwendige Einrichtungen vorschlagen. Dies muss allerdings verantwortungsbewusst und mit Blick auf potenzielle langfristige Nebenwirkungen erfolgen.

Autonomie und KI

Das Prinzip der Autonomie betont die Wichtigkeit, dass Entscheidungen frei von äußerer Kontrolle getroffen werden sollten. In Bezug auf KI bedeutet dies, dass Systeme so gestaltet werden sollten, dass sie die Entscheidungsfreiheit der Menschen unterstützen und erweitern, statt sie einzuschränken. Im Bereich der Klimakrise kann KI als Unterstützung dienen, um individuelle und kollektive Entscheidungen zu informieren. Zum Beispiel könnte KI dazu genutzt werden, Rabattierungen für nachhaltige Produkte zu steuern oder individuelle Empfehlungen für Energieverbrauch zu geben, was den Nutzern hilft, informierte Entscheidungen zu treffen. Dabei ist es wichtig, dass solche Systeme transparent bleiben und die Nutzer in die Lage versetzen, ihre eigenen Entscheidungen zu treffen und zu verstehen, warum bestimmte Vorschläge gemacht werden.

Gerechtigkeit in der KI-gestützten Klimapolitik

Gerechtigkeit als ethisches Prinzip verlangt, dass KI-Systeme fair und ohne Vorurteile agieren. Im Kampf gegen die Klimakrise könnte dies bedeuten, dass KI dazu verwendet wird, Förderprogramme zu schaffen, die auf Einkommen und soziale Verhältnisse abgestimmt sind. Solche Systeme könnten sicherstellen, dass Nachhaltigkeitsinitiativen diejenigen erreichen, die sie am meisten benötigen, und dass Unterstützung dort geleistet wird, wo sie die größte positive Wirkung erzielt. Ein Beispiel könnte die gezielte Förderung von Haushalten mit Photovoltaikanlagen sein, die sowohl die Energieeffizienz erhöht als auch langfristig zu einer gerechteren Energieverteilung beitragen kann.

Datenschutz in der KI und Klimakrise

Datenschutz bleibt ein vorrangiges Thema in der Entwicklung von KI. KI-Systeme, die im Kontext der Klimakrise eingesetzt werden, müssen in der Lage sein, große Mengen an Daten zu verarbeiten, ohne die Privatsphäre der Individuen zu verletzen. Zum Beispiel könnten KI-Systeme, die in Echtzeit Photovoltaik (PV)-Erzeugung steuern, dazu beitragen, die Energieeffizienz zu optimieren. Jedoch muss dabei sichergestellt werden, dass personenbezogene Daten geschützt bleiben und nur für den vorgesehenen Zweck verwendet werden. Die Einhaltung von Datenschutzgesetzen wie der DSGVO ist dabei unerlässlich.

Diese Abschnitte beleuchten, wie KI in den Dienst ethischer Prinzipien gestellt werden kann, um Antworten auf die Klimakrise zu formulieren. Der Schlüssel liegt in der sorgfältigen Abwägung der Potenziale von KI gegen die ethischen Anforderungen, um sicherzustellen, dass technologischer Fortschritt nicht zu Lasten der sozialen Gerechtigkeit oder individuellen Autonomie geht. Mit einem solchen Ansatz kann KI zu einem mächtigen Werkzeug werden, das nicht nur wirtschaftliche oder technologische Ziele verfolgt, sondern auch zum Wohle der Gesellschaft und des Planeten beiträgt.

Manhatten Projekt versus OpenAI

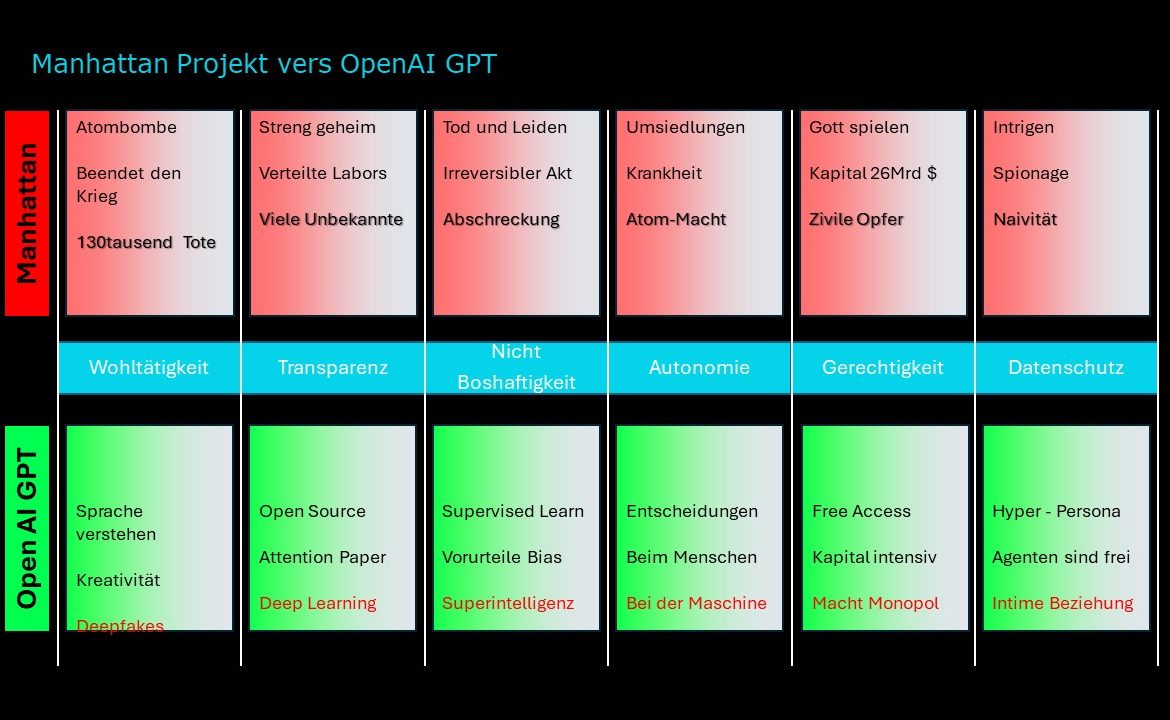

Das Abbildung 6 präsentiert eine vergleichende Analyse zwischen zwei höchst unterschiedlichen Unternehmungen – dem Manhattan-Projekt und OpenAI GPT (Generative Pre-trained Transformer) – in Bezug auf verschiedene ethische Prinzipien. Es handelt sich hierbei um eine Matrix, die anhand von ethischen Dimensionen wie Wohltätigkeit, Transparenz, Nicht Boshaftigkeit, Autonomie, Gerechtigkeit und Datenschutz, zwei sehr unterschiedliche Bereiche – Kernphysik und künstliche Intelligenz – gegenüberstellt und bewertet.

Die Fortschritte in Wissenschaft und Technologie haben immer eine tiefe ethische Dimension. Dies gilt insbesondere für zwei revolutionäre Entwicklungen des 20. und 21. Jahrhunderts: das Manhattan-Projekt, das während des Zweiten Weltkriegs zur Entwicklung der Atombombe führte, und die Entwicklung von OpenAI GPT, einer fortschrittlichen Form künstlicher Intelligenz. Diese beiden Unterfangen, obwohl in verschiedenen Epochen und mit unterschiedlichen Zielen, werfen Fragen von moralischer Bedeutung auf, die eine genauere Untersuchung verdienen.

Das Manhattan-Projekt und ethische Erwägungen

Das Manhattan-Projekt war ein streng geheimes Vorhaben, das mit dem Ziel initiiert wurde, den Krieg zu beenden, was schließlich zur Schaffung und zum Einsatz der Atombombe führte. Die damit einhergehenden ethischen Dilemmata sind enorm und mehrdimensional.

Wohltätigkeit: Obwohl das primäre Ziel des Projekts darin bestand, den Krieg zu beenden und damit langfristig Leben zu retten, resultierte die unmittelbare Handlung in der Tötung von 130.000 Menschen in Hiroshima und Nagasaki. Diese Handlung könnte in einem utilitaristischen Sinne diskutiert werden, indem das Leiden vieler gegen das einer geringeren Anzahl abgewogen wird.

Transparenz: Die Geheimhaltung des Projekts war notwendig, um die Sicherheit der beteiligten Nationen zu gewährleisten, erschwerte jedoch die öffentliche Überprüfung und Diskussion der moralischen Implikationen.

Nicht Boshaftigkeit: Trotz des Ziels, ein schnelles Ende des Krieges herbeizuführen, verursachte die Atombombe unvorstellbares Leid und irreversible Schäden, sowohl menschlich als auch ökologisch.

Autonomie: Das Projekt führte zur Ansammlung von Macht in den Händen einer kleinen Gruppe von Staatsführern und Wissenschaftlern, die die Autonomie ganzer Nationen und deren Recht auf Selbstbestimmung beeinträchtigte.

Gerechtigkeit: das Manhattan-Projekt stellte auch Fragen nach der Gerechtigkeit und der ungleichen Verteilung von Macht, die durch die Verfügungsgewalt über Atomwaffen entstand.

Datenschutz: Obwohl Datenschutz im klassischen Sinne während des Manhattan-Projekts keine Rolle spielte, waren Spionage und Geheimhaltung zentrale Aspekte, die die Sicherheit von Informationen betrafen.

OpenAI GPT und ethische Überlegungen

Im Vergleich dazu repräsentiert OpenAI GPT eine neue Generation von Technologien, die auf dem Verständnis natürlicher Sprache und der Generierung von Text basieren. Die ethischen Fragen, die diese Technologie aufwirft, sind symptomatisch für das digitale Zeitalter.

Wohltätigkeit: OpenAI GPT hat das Potenzial, die menschliche Kreativität zu erweitern und kann in verschiedenen Bereichen vom Bildungswesen bis zur Unterhaltungsindustrie von Nutzen sein. Doch die Möglichkeit von Deepfakes – manipulativen Medieninhalten – wirft Fragen hinsichtlich der Wohltätigkeit auf.

Transparenz: Durch die Open-Source-Philosophie, die von OpenAI bei der Entwicklung ihrer Modelle angewandt wird, und die Veröffentlichung von Forschungsergebnissen, wird ein hoher Grad an Transparenz erreicht.

Nicht Boshaftigkeit: Während das Ziel der Entwicklung einer KI wie GPT nicht schadhaft ist, können Voreingenommenheit und die Erstellung von Deepfakes als ungewollte Nebenwirkungen auftreten.

Autonomie: GPT-Modelle können Entscheidungen unterstützen und als mächtige Werkzeuge dienen. Es besteht jedoch die Sorge, dass zunehmend Entscheidungen an Maschinen delegiert werden und damit die menschliche Autonomie untergraben wird.

Gerechtigkeit: Der freie Zugang zu OpenAI GPT ermöglicht es vielen, von dieser Technologie zu profitieren. Gleichzeitig kann die Konzentration von Wissen und Technologie bei einer kleinen Gruppe von Entwicklern zu einem Machtmonopol führen.

Datenschutz: Die Beziehung zwischen KI und Datenschutz ist komplex. Einerseits können KI-Modelle dazu beitragen, die Privatsphäre zu schützen, indem sie beispielsweise personalisierte Daten anonymisieren. Andererseits kann die Fähigkeit, personalisierte Inhalte zu generieren, auch zu einer Verletzung des Datenschutzes führen.

Schlussfolgerung

Das Manhattan-Projekt und

OpenAI GPT stellen beispielhaft dar, wie wissenschaftliche und technologische

Unternehmungen ethische Fragen aufwerfen, die weit über ihre unmittelbaren

Ziele und Anwendungen hinausgehen. Während das eine Projekt in einer Zeit extremer

globaler Konflikte stattfand und die Menschheit an den Rand einer nuklearen

Katastrophe führte, repräsentiert das andere die Hoffnungen und Ängste im

Hinblick auf die Macht der KI.

Verantwortung und Haftung

Die Abbildung 7 zeigt eine Matrix, die sich mit der Verantwortung und Haftung im Zusammenhang mit der Anwendung von Künstlicher Intelligenz (KI) beschäftigt. Die Matrix ist in drei horizontale Ebenen (hoch, mittel, niedrig) und zwei vertikale Spalten (Hersteller, Anwender) unterteilt und veranschaulicht unterschiedliche Grade der Verantwortlichkeit sowie Beispiele für den Einsatz von KI. Zusätzlich ist am unteren Rand des Bildes ein Bereich, der verbotene Anwendungen von KI, wie Fernerkennung und Social Scoring, sowie den Einsatz von KI in kritischer Infrastruktur hervorhebt.

Niedriges Risiko

Bei KI-Systemen mit geringem Risikopotenzial liegt die primäre Verantwortung beim Hersteller, die Standardsicherheit des Systems zu gewährleisten. Der Anwender trägt hingegen die Verantwortung für die sachgemäße Verwendung des Systems. Im Falle von Schäden haftet der Hersteller nur bei unsachgemäßer Verwendung durch den Anwender.

Beispiel: Ein KI-Sprachmodell, das zur Texterstellung verwendet wird, kann als System mit geringem Risiko eingestuft werden. Der Hersteller trägt die Verantwortung, dass das Modell keine Hassrede oder andere schädliche Inhalte generiert. Der Anwender hingegen trägt die Verantwortung, das Modell sachgemäß zu verwenden und es nicht für missbräuchliche Zwecke einzusetzen.

Mittleres Risiko

Steigt das Risikopotenzial der KI-Anwendung, erweitert sich die Verantwortung des Herstellers. Er muss nun die Robustheit des Systems gegen Missbrauch sicherstellen und einen sogenannten „Human-Loop“ implementieren, der dem Menschen die Kontrolle über kritische Entscheidungen überträgt. Der Anwender trägt weiterhin die Verantwortung für die sorgfältige Nutzung des Systems und die Beachtung der Warnhinweise. Seine Haftung greift bei unsachgemäßer Verwendung.

Beispiel: Ein KI-System, das zur Diagnose von Krankheiten verwendet wird, kann als System mit mittlerem Risiko eingestuft werden. Der Hersteller trägt die Verantwortung, dass das System zuverlässige und akkurate Diagnosen erstellt. Er muss außerdem einen Human-Loop implementieren, der dem Arzt die Möglichkeit gibt, die Diagnose des Systems zu hinterfragen und zu korrigieren. Der Anwender trägt die Verantwortung, das System sorgfältig zu nutzen und die Warnhinweise zu beachten.

Hohes Risiko

Bei KI-Systemen mit hohem Risikopotenzial liegt die volle Verantwortung beim Hersteller. Er muss für die Entwicklung und den Einsatz von sicheren und transparenten Systemen Sorge tragen. Der Anwender hat hingegen keine eigene Haftung, sondern trägt lediglich die Verantwortung, die Anweisungen des Herstellers zu befolgen.

Beispiel: Ein autonomes Fahrsystem kann als System mit hohem Risiko eingestuft werden. Der Hersteller trägt die Verantwortung, dass das System sicher und zuverlässig funktioniert. Er muss außerdem sicherstellen, dass das System transparent ist und seine Entscheidungen nachvollziehbar sind. Der Anwender hat keine eigene Haftung, sondern trägt lediglich die Verantwortung, die Anweisungen des Herstellers zu befolgen.

Verbotene Anwendungsbereiche

Die Grafik kennzeichnet zudem Anwendungsbereiche von KI, die als verboten gelten, da sie mit einem unverhältnismäßig hohen Risiko verbunden sind und ethische Bedenken aufwerfen. Dazu zählen beispielsweise die Fernkennung von Personen, Social Scoring und der Einsatz von KI in kritischer Infrastruktur.

Fernkennung von Personen: Die Fernkennung von Personen ermöglicht es, Personen anhand ihrer biometrischen Merkmale wie Gesicht oder Fingerabdruck zu identifizieren. Diese Technologie birgt ein hohes Missbrauchspotenzial und kann zur Überwachung und Kontrolle von Menschen eingesetzt werden.

Social Scoring: Social Scoring ist ein System, das Menschen anhand ihres sozialen Verhaltens bewertet. Dieses System kann zu Diskriminierung und Ausgrenzung führen.

Einsatz von KI in kritischer Infrastruktur: Der Einsatz von KI in kritischer Infrastruktur wie z.B. Stromnetzen oder Verkehrssystemen birgt ein hohes Risiko für die Sicherheit und Funktionsfähigkeit dieser Systeme.

Verantwortung der Hersteller:

Technische Sicherheitsstandards: Welche Sicherheitsstandards sollten für KI-Systeme gelten, um ein angemessenes Schutzniveau zu gewährleisten? Wie können diese Standards effektiv implementiert und durchgesetzt werden?

Robustheit gegen Missbrauch: Wie können KI-Systeme gegen Missbrauch und Fehlanwendung gesichert werden? Welche Maßnahmen können ergriffen werden, um das Risiko von unbeabsichtigten Schäden zu minimieren?

Transparenz und Nachvollziehbarkeit: Wie kann die Transparenz von KI-Systemen und die Nachvollziehbarkeit ihrer Entscheidungen sichergestellt werden? Welche Informationen sollten den Anwendern zur Verfügung gestellt werden?

Fehlererkennung und -behebung: Welche Mechanismen sollten etabliert werden, um Fehler in KI-Systemen zu erkennen und zu beheben? Wie kann ein effektives Fehlermanagement sichergestellt werden?

Verantwortung der Anwender:

Sachgemäße Nutzung: Was bedeutet sachgemäße Nutzung von KI-Systemen? Welche Pflichten und Sorgfaltspflichten treffen die Anwender?

Kenntnis der potenziellen Risiken: Wie können Anwender über die potenziellen Risiken von KI-Systemen informiert und sensibilisiert werden? Welche Schulungs- und Ausbildungsmaßnahmen sind erforderlich?

Beachtung der Gebrauchsanweisungen: Wie kann die Einhaltung der Gebrauchsanweisungen für KI-Systeme sichergestellt werden? Welche rechtlichen und technischen Maßnahmen können ergriffen werden?

Vermeidung missbräuchlicher Nutzung: Wie kann missbräuchliche Nutzung von KI-Systemen verhindert werden? Welche Anreizsysteme und Kontrollmechanismen können implementiert werden?

Ethische Reflexion und Regulierung:

Ethische Leitlinien: Welche ethischen Prinzipien sollten für die Entwicklung und Nutzung von KI-Systemen gelten? Wie können diese Prinzipien in konkrete Handlungsempfehlungen und Leitlinien übersetzt werden?

Rechtliche Rahmenbedingungen: Welche rechtlichen Rahmenbedingungen sind erforderlich, um die verantwortungsvolle Entwicklung und Nutzung von KI zu gewährleisten? Welche Anpassungen des bestehenden Rechts sind notwendig?

Internationale Zusammenarbeit: Wie kann eine internationale Zusammenarbeit im Bereich der KI-Ethik und -Regulierung erreicht werden? Welche gemeinsamen Standards und Normen sollten entwickelt werden?

Herausforderungen:

Zuordnung von Verantwortung und Haftung: Wie kann die Zuordnung von Verantwortung und Haftung im Falle von Schäden durch KI-Systeme in der Praxis klar und transparent geregelt werden?

Durchsetzung von Haftungsregelungen: Welche Mechanismen und Verfahren können etabliert werden, um die Durchsetzung von Haftungsregelungen im Kontext von KI zu gewährleisten?

Komplexität der Technologie: Wie kann die Komplexität der KI-Technologie für Laien verständlich gemacht werden, um eine informierte und verantwortungsvolle Nutzung zu ermöglichen?

Schnelle Weiterentwicklung der Technologie: Wie können der Rechtsrahmen und die ethische Reflexion mit der rasanten Weiterentwicklung der KI-Technologie Schritt halten?

Zukunftsperspektiven:

Entwicklung von sicheren und transparenten KI-Systemen: Die Entwicklung von sicheren und transparenten KI-Systemen ist eine zentrale Herausforderung der Zukunft.

Kontinuierlicher Dialog zwischen Politik, Wirtschaft, Wissenschaft und Zivilgesellschaft: Ein kontinuierlicher Dialog zwischen allen Stakeholdern ist notwendig, um die ethischen und rechtlichen Herausforderungen der KI zu adressieren.

Globaler Konsens über ethische Prinzipien und Standards: Die Entwicklung eines globalen Konsenses über ethische Prinzipien und Standards für die Entwicklung und Nutzung von KI ist unerlässlich.

Zusammenfassend lässt sich sagen, dass die Diskussion um

Verantwortung und Haftung im Kontext von KI komplex und vielschichtig ist. Es

bedarf einer gemeinsamen Anstrengung von allen Stakeholdern, um die damit

verbundenen Herausforderungen zu bewältigen und einen verantwortungsvollen

Umgang mit dieser Technologie zu gewährleisten.

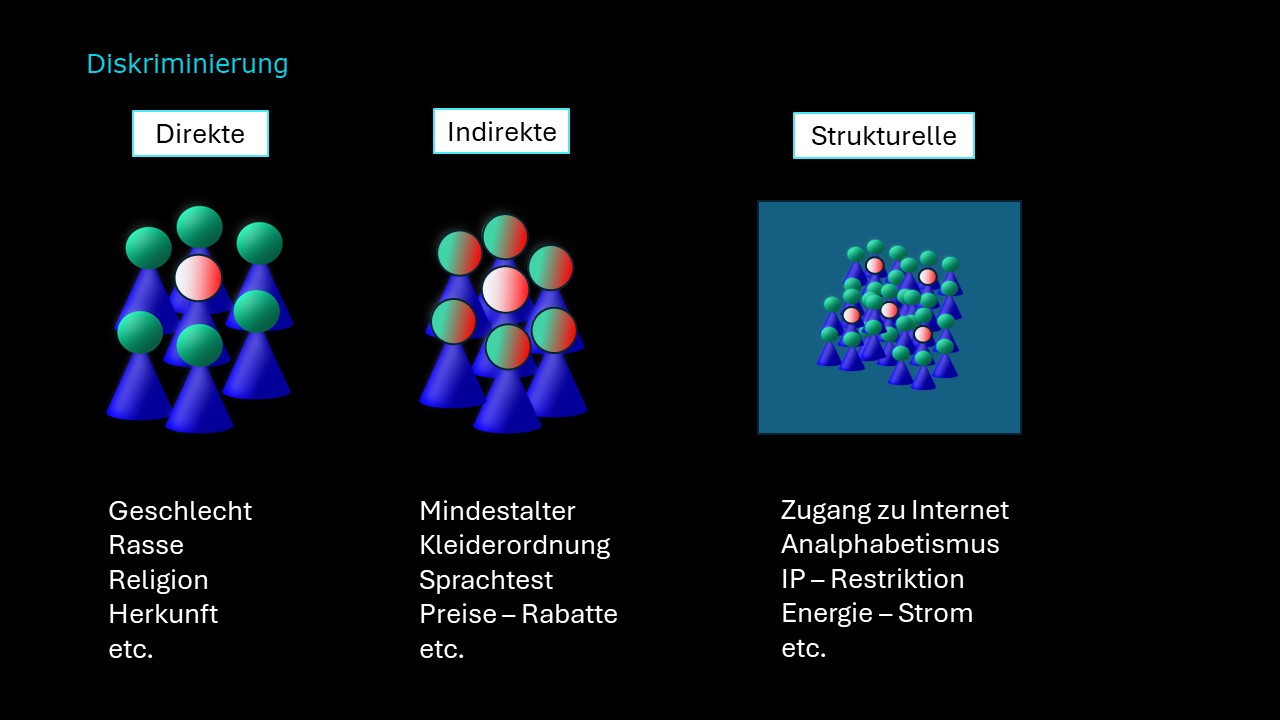

Diskriminierung

Direkte Diskriminierung

Direkte Diskriminierung tritt auf, wenn eine Person aufgrund bestimmter Merkmale wie Geschlecht, Rasse, Religion oder Herkunft benachteiligt wird. In der KI-Welt manifestiert sich dies in Algorithmen, die auf historischen Daten trainiert wurden und daher die bestehenden Vorurteile widerspiegeln. Ein Beispiel ist ein Bewerbungsfilter, der Frauen aufgrund ihres Geschlechts benachteiligt. Solche Systeme sind nicht nur ungerecht, sondern auch ethisch bedenklich.

Bewerbungsfilter: Ein KI-System zur automatischen Vorauswahl von Bewerbungen kann aufgrund von Schlüsselwörtern oder Mustern Frauen benachteiligen. Wenn das System unbewusst aufgrund von Geschlecht oder anderen diskriminierenden Faktoren Bewerberinnen aussortiert, verstärkt es bestehende Ungleichheiten.

Strafverfolgung: KI-Systeme werden zunehmend zur Vorhersage von Straftaten eingesetzt. Wenn diese Systeme aufgrund von Rasse oder sozioökonomischem Hintergrund bestimmte Bevölkerungsgruppen fälschlicherweise als kriminell einstufen, kann dies zu schwerwiegenden Konsequenzen führen.

Indirekte Diskriminierung

Indirekte Diskriminierung ist komplexer und weniger offensichtlich als die direkte Form. Sie basiert auf scheinbar neutralen Kriterien, die jedoch bestimmte Gruppen benachteiligen können. Ein Beispiel dafür ist ein Kreditvergabesystem, das aufgrund von Altersgrenzen oder anderen Faktoren bestimmte Bevölkerungsgruppen benachteiligt. Solche Systeme sind schwer zu erkennen, da sie nicht explizit auf Geschlecht, Rasse oder Religion abzielen. Dennoch können sie zu unerwünschten Ergebnissen führen und müssen daher sorgfältig analysiert werden.

Kreditvergabe: Ein Kreditvergabesystem kann aufgrund von Altersgrenzen oder anderen Faktoren bestimmte Gruppen benachteiligen. Wenn ältere Menschen aufgrund ihres Alters weniger Kreditchancen haben, ist dies ein Fall indirekter Diskriminierung.

Automatisierte Entscheidungen: KI-Systeme, die über Kreditvergaben, Versicherungsprämien oder andere wichtige Bereiche entscheiden, können aufgrund von Algorithmen und historischen Daten bestimmte Gruppen benachteiligen. Hier müssen wir sicherstellen, dass die Kriterien fair sind und keine unerwünschten Ergebnisse produzieren.

Strukturelle Diskriminierung

Strukturelle Diskriminierung ist tief verwurzelt und geht über individuelle Entscheidungen hinaus. Sie entsteht durch institutionelle Muster, soziale Normen und historische Ungerechtigkeiten. Ein Beispiel dafür ist der Zugang zu Internetdiensten. Wenn bestimmte Bevölkerungsgruppen aufgrund ihrer geografischen Lage oder finanziellen Situation keinen Zugang zu Breitbandinternet haben, verstärkt dies bestehende Ungleichheiten. Strukturelle Diskriminierung kann nur durch umfassende gesellschaftliche Veränderungen bekämpft werden.

Zugang zu Bildung: Wenn KI-Systeme den Zugang zu Bildungsdiensten beeinflussen, können sie bestehende Ungleichheiten verstärken. Wenn bestimmte Bevölkerungsgruppen aufgrund ihrer geografischen Lage oder finanziellen Situation keinen Zugang zu qualitativ hochwertiger Bildung haben, ist dies strukturelle Diskriminierung.

Gesundheitsversorgung: KI-Systeme zur Diagnose und Behandlung können aufgrund von historischen Daten bestimmte Gruppen benachteiligen. Wenn Menschen aufgrund ihrer Herkunft oder ihres sozioökonomischen Status weniger Zugang zur Gesundheitsversorgung haben, ist dies ein Beispiel für strukturelle Diskriminierung.

AI Act der Europäischen Union

Der AI Act (Artificial Intelligence Act) der Europäischen Union (EU) zielt darauf ab, die Entwicklung und Nutzung von künstlicher Intelligenz (KI) in der EU zu regeln. Der AI Act soll sicherstellen, dass KI-Systeme:

- sicher für die Nutzer und die Gesellschaft sind,

- ethische Prinzipien wie Fairness und Transparenz einhalten und

- transparent in ihrer Funktionsweise und Entscheidungsfindung sind.

Anwendungsbereich:

Der AI Act gilt für alle KI-Systeme, die in der EU entwickelt, eingesetzt oder vertrieben werden. Der AI Act unterscheidet dabei zwischen vier Risikoklassen:

1. Unannehmbares Risiko: KI-Systeme, die ein unannehmbares Risiko für die Sicherheit, die Grundrechte oder die Demokratie darstellen, sind verboten. Dazu gehören beispielsweise KI-Systeme, die zur sozialen Kontrolle oder zur Kriegsführung eingesetzt werden können.

2. Hohes Risiko: KI-Systeme, die ein hohes Risiko für die Sicherheit, die Gesundheit oder die Grundrechte darstellen, unterliegen strengen Anforderungen. Diese Anforderungen umfassen unter anderem:

- Ex-ante-Konformitätsbewertung: Die Systeme müssen von einer unabhängigen Stelle vor der Markteinführung auf ihre Sicherheit und Konformität mit dem AI Act geprüft werden.

- Registrierung: Die Systeme müssen bei der Europäischen Kommission registriert werden.

- Risikomanagement: Die Entwickler und Nutzer der Systeme müssen ein Risikomanagement-System einrichten.

- Menschliche Aufsicht: Die Systeme müssen unter menschlicher Aufsicht eingesetzt werden.

Zu den KI-Systemen mit hohem Risiko zählen beispielsweise Systeme zur Gesichtserkennung, zur Kreditwürdigkeitsprüfung und zur automatisierten Entscheidungsfindung in der Strafjustiz.

3. Geringes Risiko: KI-Systeme, die ein geringes Risiko darstellen, unterliegen weniger strengen Anforderungen. Diese Anforderungen umfassen unter anderem:

- Transparenzpflichten: Die Entwickler und Nutzer der Systeme müssen Informationen über die Funktionsweise und die Entscheidungsfindung der Systeme bereitstellen.

- Erklärungspflichten: Die Entwickler und Nutzer der Systeme müssen erklären können, wie die Systeme Entscheidungen treffen.

Zu den KI-Systemen mit geringem Risiko zählen beispielsweise Systeme zur Spracherkennung, zur Übersetzung und zur Kundenbetreuung.

4. Minimales Risiko: KI-Systeme, die ein minimales Risiko darstellen, unterliegen keinen spezifischen Anforderungen des AI Acts.

Vorschriften:

Der AI Act enthält verschiedene Vorschriften für die Entwicklung und Nutzung von KI-Systemen. Diese Vorschriften umfassen unter anderem:

- Transparenz: KI-Systeme müssen transparent sein, so dass die Nutzer verstehen können, wie sie funktionieren.

- Erklärbarkeit: KI-Systeme müssen erklärbar sein, so dass die Nutzer die Entscheidungen, die sie treffen, nachvollziehen können.

- Verantwortlichkeit: Die Entwickler und Nutzer von KI-Systemen müssen für die Sicherheit und Ethik ihrer Systeme verantwortlich sein.

- Grundrechtsschutz: Der AI Act muss den Schutz der Grundrechte, wie z. B. der Privatsphäre und der Diskriminierungsfreiheit, gewährleisten.

Sanktionen:

Bei Verstößen gegen den AI Act können empfindliche Sanktionen verhängt werden. Diese Sanktionen können bis zu 6 % des weltweiten Jahresumsatzes eines Unternehmens betragen.

Kritik:

Der AI Act wurde von verschiedenen Seiten kritisiert. Einige Kritiker argumentieren, dass der AI Act zu bürokratisch und kompliziert sei. Andere Kritiker bemängeln, dass der AI Act die Entwicklung und Nutzung von KI in der EU behindern könnte.

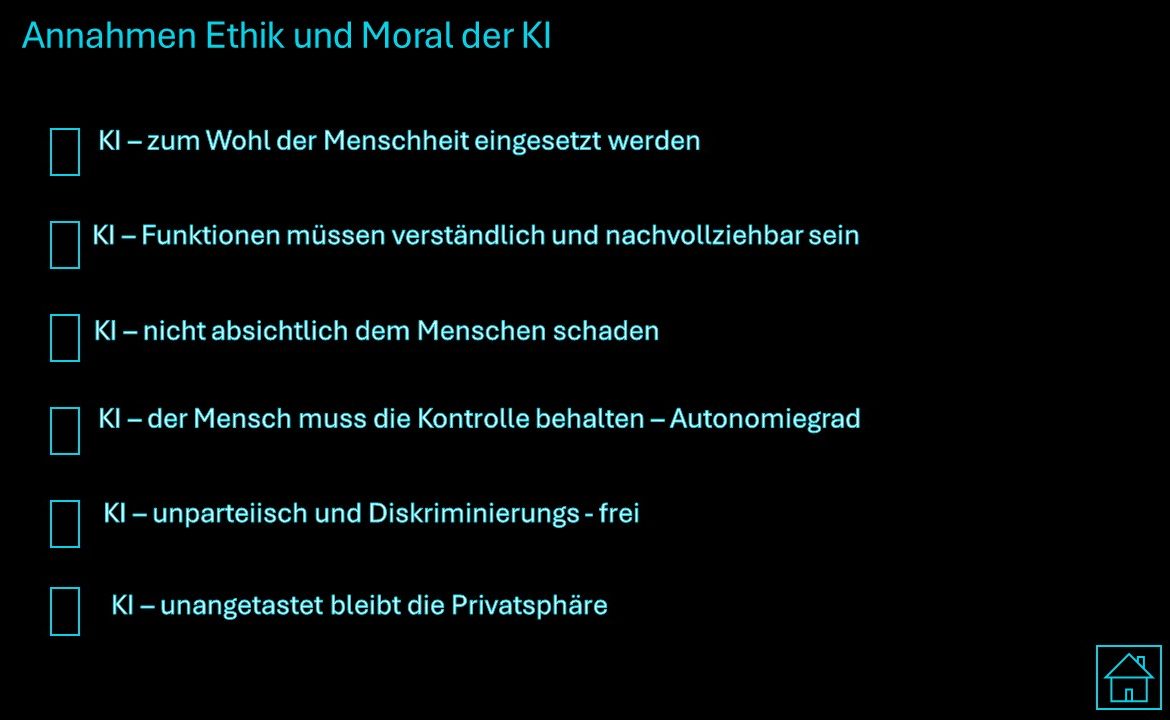

KI kann zum Wohl der Menschheit eingesetzt werden. KI hat das Potenzial, viele Probleme der Menschheit zu lösen, wie z.B. Klimawandel, Armut und Krankheiten.

KI-Funktionen müssen verständlich und nachvollziehbar sein. Menschen müssen die Funktionsweise von KI-Systemen verstehen können, um sie verantwortungsvoll einsetzen zu können.

KI darf dem Menschen nicht absichtlich schaden. KI-Systeme müssen so konzipiert sein, dass sie keine Gefahr für die menschliche Sicherheit und Gesundheit darstellen.

Der Mensch muss die Kontrolle über KI behalten. Der Mensch muss die Entscheidungsgewalt über die Entwicklung und Nutzung von KI-Systemen behalten.

KI muss unparteiisch und diskriminierungsfrei sein. KI-Systeme dürfen keine Vorurteile gegenüber bestimmten Bevölkerungsgruppen oder Individuen haben.

KI muss die Privatsphäre der Menschen respektieren. KI-Systeme dürfen keine personenbezogenen Daten ohne die Zustimmung der Betroffenen sammeln oder verwenden.

Es ist wichtig, dass der Mensch die Kontrolle über KI behält. Das bedeutet, dass Menschen die Entscheidungsgewalt über die Entwicklung und Nutzung von KI-Systemen behalten müssen. Es ist auch wichtig, dass es Mechanismen gibt, um die Macht von KI zu begrenzen und sicherzustellen, dass sie nicht zum Nachteil der Menschheit eingesetzt wird. KI befindet sich noch in einem frühen Entwicklungsstadium, aber es ist bereits klar, dass sie eine enorme transformative Kraft hat. Es ist wichtig, dass wir uns mit den Chancen und Herausforderungen von KI auseinandersetzen und dafür sorgen, dass sie zum Wohle der Menschheit eingesetzt wird. Zusammenfassend lässt sich sagen, dass KI ein großes Potenzial hat, die Welt zu verbessern. Es ist jedoch wichtig, dass wir die ethischen Herausforderungen von KI ernst nehmen und dafür sorgen, dass sie verantwortungsvoll eingesetzt wird. Nur so können wir sicherstellen, dass KI zum Wohle der Menschheit genutzt wird und nicht zu ihrer Bedrohung.

UDEMY Kurs: Bewusstsein und das Künstliche

YouTube: SpirituaLife

Deutsch

Deutsch English

English