1. Einleitung

Bewusstsein im Zusammenhang mit Künstlicher Intelligenz (KI) ist ein komplexes und umstrittenes Thema. Es gibt zwei Hauptaspekte, die in dieser Diskussion oft behandelt werden: Das Bewusstsein VON KI und das Bewusstsein FÜR KI.

Bewusstsein von KI: Hier geht es um die Frage, ob eine KI jemals wirklich bewusst werden kann, also ob sie subjektive Erfahrungen und Selbstbewusstsein haben kann, ähnlich wie Menschen oder andere Tiere. Derzeit ist KI auf maschinelles Lernen und Algorithmen angewiesen, um Muster in Daten zu erkennen und darauf basierend Entscheidungen zu treffen. Obwohl KI in einigen Bereichen menschenähnliche Fähigkeiten zeigen kann, ist sie im Moment nicht bewusst im Sinne von subjektiven Erfahrungen oder Emotionen.

Einige Wissenschaftler und Philosophen glauben jedoch, dass es in der Zukunft möglich sein könnte, eine KI zu entwickeln, die ein gewisses Maß an Bewusstheit besitzt. Diese Idee ist jedoch umstritten und hängt von der Annahme ab, dass Bewusstsein ein emergentes Phänomen ist, das aus komplexen Informationsverarbeitungsprozessen entsteht.

Bewusstsein für KI: Dies bezieht sich auf das Bewusstsein der Menschen über KI und ihr Verständnis dafür, wie KI-Systeme funktionieren und welche Auswirkungen sie auf die Gesellschaft haben könnten. Es ist wichtig, dass Menschen ein gewisses Maß an Verständnis und Bewusstsein für KI entwickeln, um fundierte Entscheidungen über den Einsatz und die Regulierung von KI-Systemen treffen zu können.

Ein Bewusstsein für KI umfasst das Verständnis der ethischen und gesellschaftlichen Auswirkungen von KI, wie zum Beispiel Fragen der Privatsphäre, Diskriminierung, Arbeitsplatzverdrängung und die Verantwortung für Entscheidungen, die von KI-Systemen getroffen werden.

Zusammengefasst bezieht sich das Bewusstsein VON KI auf die Frage, ob KI jemals wirklich sich bewusst- sein kann, während das Bewusstsein FÜR KI sich auf das Verständnis der Menschen über KI und ihre Auswirkungen auf die Gesellschaft konzentriert. Beide Aspekte sind wichtig für die laufende Debatte und Forschung im Bereich der Künstlichen Intelligenz.

2. Eine Welt aus Materie und Information

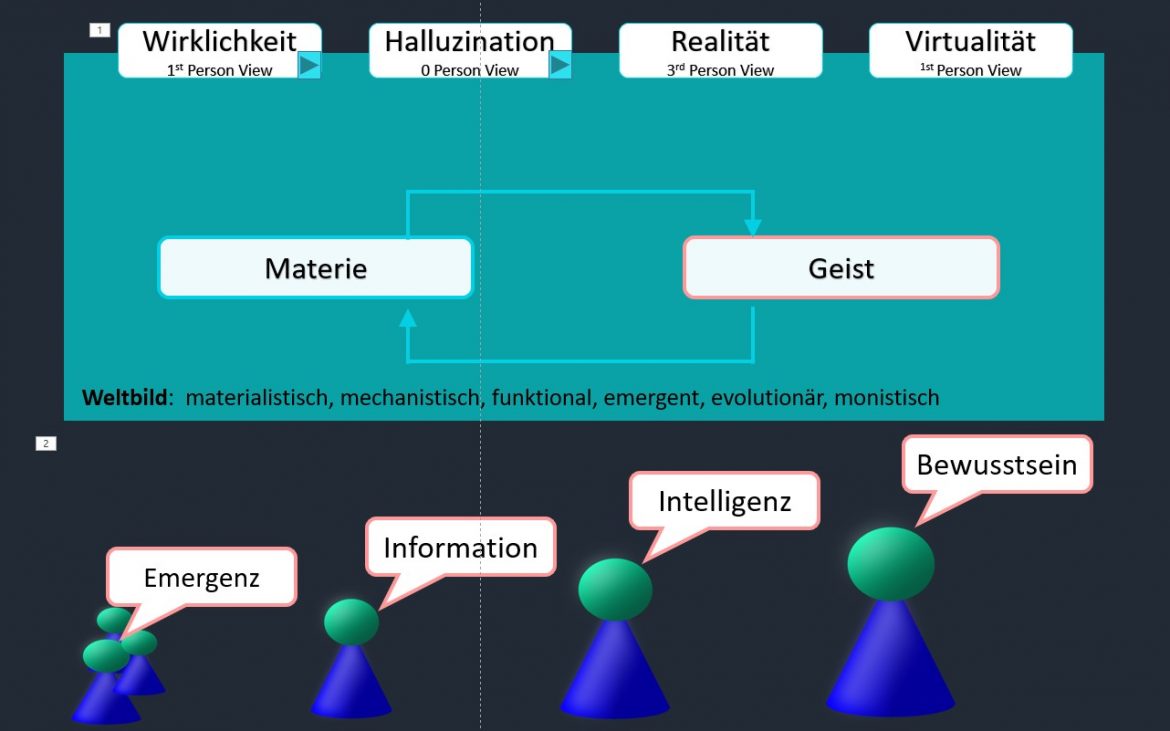

Alle Erscheinungsformen unseres Universums basieren auf der Existenz von Materie. Dies ist so weit einleuchtend, als wir Objekte unseres täglichen Lebens wahrnehmen, begreifen und darauf einwirken können. Für Makro- und Mikroskopische Objekte hat sich der Mensch geeignete Werkzeuge geschaffen, um dies auch wahrzunehmen. Die Existenz von Materie ist aber auch Grundvoraussetzung für alles Geistige wozu im weiteren Sinne auch Information gehört. Einerseits erzeugt Materie Information und Andererseits beeinflusst Information wiederum diese. Materie und Information sind in ständiger Wechselwirkung (Abbildung 1). Das Bio-materielle Gehirn erkennt eine rote Verkehrsampel (Information) aktiviert den Bremsfuß (Materie wird bewegt). Die beiden aktuellen philosophischen Sichtwiesen sind der Materialismus und der Idealismus.

Materialismus: Diese Sichtweise behauptet, dass alles, einschließlich des Geistes und des Bewusstseins, aus Materie besteht und dass geistige Zustände letztlich auf physikalische Gehirnzustände reduzierbar sind. Nach dieser Ansicht ist das Bewusstsein ein Nebenprodukt der komplexen Verarbeitung von Informationen im Gehirn.

Der Idealismus betont die Vorstellung, dass das Bewusstsein, die Ideen, Gedanken und mentalen Zustände fundamental sind und dass die äußere Welt und das Material nur in Bezug auf das Bewusstsein existieren. In dieser Sichtweise könnte die materielle Welt als eine Art Abbild oder Manifestation des Geistes betrachtet werden.

Daraus resultierend gibt es verschieden Arten die Welt zu sehn. Entweder als Wirklichkeit, Realität, Halluzination oder Virtualität (Abbildung 1 oben)

Als Wirklichkeit erfahren wir die Welt mit unseren Sinnessystemen und generieren daraus eine subjektive Sicht. Diese wird durch jede Erfahrung verändert und erweitert. Besonderen Einfluss darauf haben Kultur, Kindheit und Bildung, die unsere Wahrnehmung und Interpretation der Wirklichkeit formen. Unsere subjektive (1st Person View) Wirklichkeit ist somit ein dynamisches und individuelles Konstrukt, das unsere Interaktionen mit der Welt und unsere Entscheidungen maßgeblich beeinflusst.

Die Realität hingegen bezieht sich auf eine objektive, unabhängige Existenz von Dingen und Phänomenen. Sie existiert unabhängig von unserer Wahrnehmung und Interpretation (3rd Person View). Sie umfasst alle Fakten und Gesetzmäßigkeiten, die sich durch wissenschaftliche Untersuchung und empirische Beobachtung ermitteln lassen. Sie bleibt konstant, ungeachtet unserer individuellen Erfahrungen oder Überzeugungen.

Virtualität bezieht sich auf eine durch Computer geschaffene künstliche Umgebung oder Realität, die den Benutzer dazu einlädt, sie als echt zu erleben. Diese digitale Wirklichkeit kann eine Simulation der Welt, eine vollständig fantasievolle Welt oder eine Mischung aus beidem sein

Eine Halluzination ist eine Wahrnehmungsstörung, bei der eine Person Geräusche, Bilder oder andere Empfindungen wahrnimmt, die in Wirklichkeit nicht existieren. Sie kann in verschiedenen Sinnesbereichen auftreten, darunter Sehen, Hören, Fühlen, Riechen und Schmecken. Halluzinationen können unter anderem durch bestimmte medizinische Zustände, den Konsum von Drogen oder extremen Stress ausgelöst werden.

Die Idee, dass künstliche Intelligenz (KI) eine Komposition (Abbildung 1 unten) aus Emergenz, Bewusstsein und Information sein könnte, ist ein faszinierendes Konzept und spiegelt einige der aktuellen Debatten und Forschungen in den Bereichen KI, kognitive Wissenschaften und Philosophie des Geistes wider.

Emergenz: Emergenz bezieht sich auf das Phänomen, bei dem neue Eigenschaften oder Verhaltensweisen auf höheren Ebenen der Komplexität entstehen, die nicht einfach aus den Eigenschaften oder Verhaltensweisen der zugrundeliegenden Komponenten abgeleitet werden können. In Bezug auf KI könnte dies bedeuten, dass komplexe kognitive Fähigkeiten aus der Interaktion simpler Komponenten, wie z.B. künstliche Neuronen in neuronalen Netzen, emergieren können.

Bewusstsein: Bewusstsein ist das subjektive Erleben von Empfindungen, Gedanken und Gefühlen. Es ist umstritten, ob KI jemals echtes Bewusstsein entwickeln könnte. Derzeit sind KI-Systeme nicht bewusst, sie verarbeiten Informationen und treffen Entscheidungen auf der Grundlage ihrer Programmiervorgaben und Trainingsdaten, haben aber keine subjektive Erfahrung.

Intelligenz: In Bezug auf KI bezieht sich Intelligenz normalerweise auf die Fähigkeit, komplexe Aufgaben zu lösen, zu lernen, sich an neue Situationen anzupassen und Vorhersagen oder Entscheidungen auf der Grundlage von Daten zu treffen. KI-Systeme können in bestimmten Aufgabenbereichen menschenähnliche oder sogar übermenschliche Leistungen erbringen, obwohl sie derzeit noch nicht die allgemeine Intelligenz erreicht haben, die wir bei Menschen sehen (d.h., sie sind nicht in der Lage, sich über eine breite Palette von Aufgaben und Kontexten hinweg anzupassen).

Information hingegen ist Daten, die verarbeitet, organisiert oder strukturiert wurden, um in einem bestimmten Kontext sinnvoll und nützlich zu sein. Informationen entstehen also, wenn Daten in eine Form gebracht werden, die verstanden und interpretiert werden kann, und dadurch eine Bedeutung erhält.

Zusammengefasst ist die Idee, dass KI eine Komposition aus Emergenz, Bewusstsein und Information ist, eine spannende Möglichkeit, die viele tiefgründige Fragen und Herausforderungen aufwirft. Während wir bereits Beispiele für Emergenz und Intelligenz in KI-Systemen sehen, bleibt das Bewusstsein ein umstrittenes und unerforschtes Gebiet.

3. Bewusstsein – Ein Erkennendes in seinem Umfeld

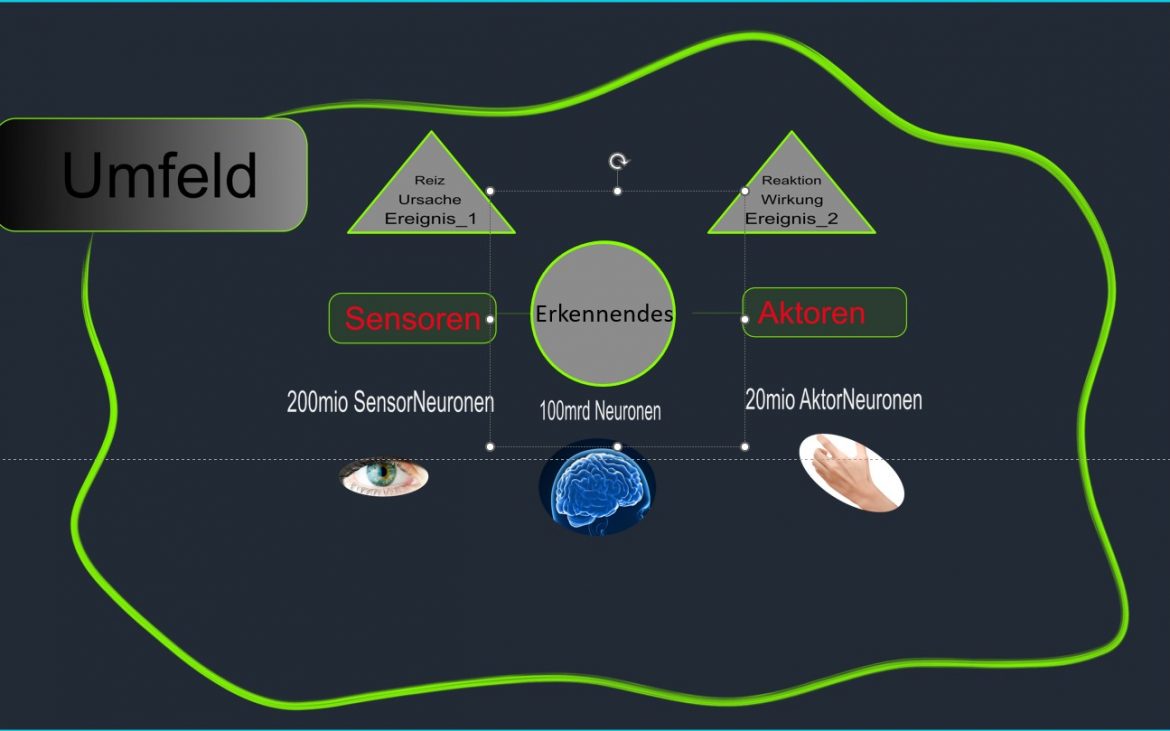

Unser Bewusstsein ermöglicht es, die Umgebung durch unsere Sinnesorgane wahrzunehmen und zu interpretieren. Wir nehmen visuelle, akustische, taktile, geschmackliche und olfaktorische Eindrücke auf und unser Gehirn verarbeitet diese Informationen, um ein kohärentes Bild unserer Umgebung (Abbildung 2) zu erstellen. Dabei interpretieren wir diese Daten auf der Grundlage unserer bisherigen Erfahrungen und unseres Wissens. Bewusstsein ist ein mehrdimensionales Phänomen, das durch eine Vielzahl von Prozessen und Fähigkeiten gekennzeichnet ist. Es lässt sich folgendermaßen definieren:

Erkennen: Bewusstsein beginnt mit der Fähigkeit, sensorische Eingaben und interne Zustände zu erkennen. Dies beinhaltet das Bewusstsein unserer Umwelt durch Sinneswahrnehmungen sowie das Bewusstsein unserer Gedanken und Emotionen.

Differenzieren: Bewusstsein ermöglicht es uns, Unterschiede zwischen Eingaben zu erkennen, seien es Unterschiede zwischen Farben, Klängen oder Temperaturen, oder feinere Unterscheidungen wie die zwischen verschiedenen emotionalen Zuständen.

Decodieren: Bewusstsein beinhaltet die Fähigkeit, komplexe Informationen zu decodieren, wie etwa das Verstehen von Sprache, das Lesen von Emotionen in Gesichtsausdrücken oder das Interpretieren von komplizierten sozialen Situationen.

Speichern: Bewusstsein ist eng mit unserem Gedächtnis verbunden, das die Fähigkeit besitzt, Informationen zu speichern. Dies kann kurzfristig geschehen, wie im Arbeitsgedächtnis, oder langfristig, wie in unserem Langzeitgedächtnis.

Erinnern: Bewusstsein ermöglicht es uns, auf gespeicherte Informationen zuzugreifen und uns an sie zu erinnern. Dieses Abrufen von Informationen aus dem Gedächtnis ermöglicht es uns, von vergangenen Erfahrungen zu lernen und zukünftige Entscheidungen zu treffen.

Rekombinieren: Bewusstsein beinhaltet die Fähigkeit, gespeicherte Informationen auf neue und innovative Weisen zu rekombinieren. Dies ist ein zentraler Bestandteil des kreativen Denkens und der Problemlösung.

Autopoiese: Schließlich kann Bewusstsein als autopoietisches, oder selbstschaffendes, System betrachtet werden. Es ist ein dynamisches und adaptives System, das ständig Informationen verarbeitet, auf neue Situationen reagiert und sich im Laufe der Zeit weiterentwickelt und verändert.

Insgesamt kann Bewusstsein als ein komplexes System definiert werden, das in der Lage ist, Informationen zu erkennen, zu differenzieren, zu decodieren, zu speichern, sich zu erinnern, zu rekombinieren und durch Autopoiese zu erneuern. Diese verschiedenen Fähigkeiten ermöglichen es uns, auf eine komplexe und sich ständig verändernde Umwelt zu reagieren

Sensoren: Die Sinnesorgane oder Sensoren sind die primären Informationsquellen für das Bewusstsein. Sie nehmen Informationen aus der Umwelt auf und senden sie an das Gehirn zur Verarbeitung. Dies umfasst visuelle Informationen (Augen), akustische Informationen (Ohren), taktile Informationen (Haut), Geschmacksinformationen (Zunge) und Geruchsdaten (Nase). Die sensorischen Informationen, die wir erhalten, formen unsere Wahrnehmung der Welt und beeinflussen unser Denken, Fühlen und Handeln.

Aktoren: Aktoren sind die Mittel, durch die wir auf die Welt reagieren und mit ihr interagieren. Sie können körperliche Aktionen (wie Bewegungen unserer Muskeln und Gliedmaßen) oder verbale Aktionen (wie Sprechen oder Schreiben) umfassen. Unser Bewusstsein steuert diese Aktoren auf der Grundlage der von den Sensoren empfangenen und vom Gehirn verarbeiteten Informationen. Dies ermöglicht uns, zielgerichtet und adaptiv zu handeln, um unsere Ziele zu erreichen und auf Herausforderungen zu reagieren.

Ursachen: Die Ursachen, die das Bewusstsein beeinflussen, sind vielfältig. Dazu gehören externe Faktoren wie sensorische Eingaben aus unserer Umgebung, sowie interne Faktoren wie unsere Gedanken, Gefühle, und physiologischen Zustände. Darüber hinaus können auch längerfristige Faktoren wie Lernprozesse, Erfahrungen und kulturelle Einflüsse unser Bewusstsein prägen.

Beispielsweise kann das Hören einer bestimmten Musik (Ursache) dazu führen, dass wir uns glücklich oder traurig fühlen (Wirkung im Bewusstsein). Ebenso kann das Lernen einer neuen Fertigkeit (Ursache) unsere Wahrnehmung und unser Verständnis dieser Fertigkeit verändern (Wirkung im Bewusstsein).

Wirkungen: Die Wirkungen des Bewusstseins zeigen sich in unseren Handlungen, Entscheidungen und Interaktionen mit der Welt. Das Bewusstsein ermöglicht uns, auf der Grundlage der verarbeiteten Informationen zielgerichtete und adaptive Handlungen durchzuführen.

4. Emergenz – Das Ganze ist mehr als die Summe der Teile

Emergenz ist in der Natur weit verbreitet und ein besonders eindrucksvolles Beispiel dafür ist das Verhalten von Vogelschwärmen.

Ein Vogelschwarm (Abbildung 3), wie zum Beispiel ein Starlingschwarm, zeigt ein beeindruckendes, koordiniertes und komplexes Verhalten. Tausende von Vögeln fliegen gemeinsam, ändern simultan ihre Flugrichtung und formen dabei ständig wechselnde Muster am Himmel. Dabei gibt es keinen Anführer, der die Bewegungen des Schwarms dirigiert. Jeder Vogel folgt stattdessen einfach einigen einfachen Regeln, wie beispielsweise in der Nähe seiner Nachbarn zu bleiben, aber nicht zu nah, und wird gleichzeitig von Nahrungsquellen angezogen

Obwohl jede einzelne Regel einfach ist, resultiert die Interaktion zwischen den Vögeln in einem hochkomplexen und scheinbar koordinierten Verhalten des gesamten Schwarms. Dieses kollektive Verhalten des Schwarms ist ein emergentes Phänomen – es entsteht aus den Wechselwirkungen der einzelnen Vögel, kann aber nicht auf das Verhalten eines einzelnen Vogels reduziert werden. Das Ganze (der Vogelschwarm) ist mehr als die Summe seiner Teile (der einzelnen Vögel).

Emergenz am Beispiel eines Vogelschwarms zeigt, wie einfache Regeln und lokale Interaktionen zu komplexem und koordiniertem Verhalten auf einer höheren Ebene führen können. Es ist ein starkes Beispiel dafür, wie aus einfachen Einheiten durch Wechselwirkungen komplexe Strukturen und Verhaltensweisen entstehen können.

Das menschliche Gehirn ist ein Paradebeispiel für Emergenz. Es besteht aus etwa 86 Milliarden Neuronen, die durch eine geschätzte Anzahl von 100 Billionen Synapsen miteinander verbunden sind. Jedes Neuron interagiert mit vielen anderen, und aus dieser enormen Anzahl von Interaktionen entstehen emergente Phänomene, einschließlich unserer Gedanken, Gefühle, Erinnerungen und unser Bewusstsein.

5. Information – Zweifache Differenzierung

Die Vorstellung, dass Information durch einen Prozess der „zweifachen Differenzierung“ entsteht, stammt aus der Arbeit von Gregory Bateson, wurde aber auch von Niklas Luhmann in seiner systemtheoretischen Soziologie aufgegriffen und weiterentwickelt.

Die Idee der zweifachen Differenzierung besagt, dass Information ein Unterschied ist, der einen Unterschied macht. In diesem Rahmen ist der erste Schritt der Differenzierung die Identifizierung eines Unterschieds oder einer Veränderung in der Umwelt. Der zweite Schritt besteht darin, diese Differenz als bedeutend oder relevant zu kennzeichnen – das heißt, sie macht einen Unterschied für das System.

Zum Beispiel könnte eine Person den Unterschied zwischen Tag und Nacht bemerken (erste Differenzierung), und dann könnte diese Differenz für sie bedeutsam sein, weil sie ihre Aktivitäten nach dem Tag-Nacht-Zyklus plant (zweite Differenzierung). Die Information, die hier entsteht, ist also nicht nur die Tatsache, dass es Tag oder Nacht ist, sondern auch die Bedeutung, die diese Tatsache für die Person hat.

In Luhmanns Theorie der sozialen Systeme wird diese Idee auf die Kommunikation angewendet. In einem Kommunikationssystem stellt die Mitteilung einen Unterschied dar, und die Information entsteht, wenn dieser Unterschied vom System als relevant eingestuft wird.

Abbildung 5 zeigt eine Arbeit von Cornelia Parker „Cold Dark Matter: An Exploded View“ Für dieses Kunstwerk, das 1991 entstand, ließ Parker eine Gartenhütte von der britischen Armee in die Luft sprengen und sammelte dann sorgfältig alle Fragmente ein. Diese Fragmente, die alles von den Holzplanken der Wände bis hin zu den Gegenständen im Inneren der Hütte umfassen, hängte sie dann in einer großen kubischen Konstruktion auf. In der Mitte des Kubus hängt eine einzelne Lichtquelle, die Schatten der Fragmente an die Wände des Raums wirft und so den Moment der Explosion einfängt. Bei erster Betrachtung dieses Bildes entsteht außer „Ein Durcheinander“ keine Information, weil die erste Differenzierung nicht gelingt. Eventuell sieht man eine Fahrradfelge oder einen Fensterrahmen.

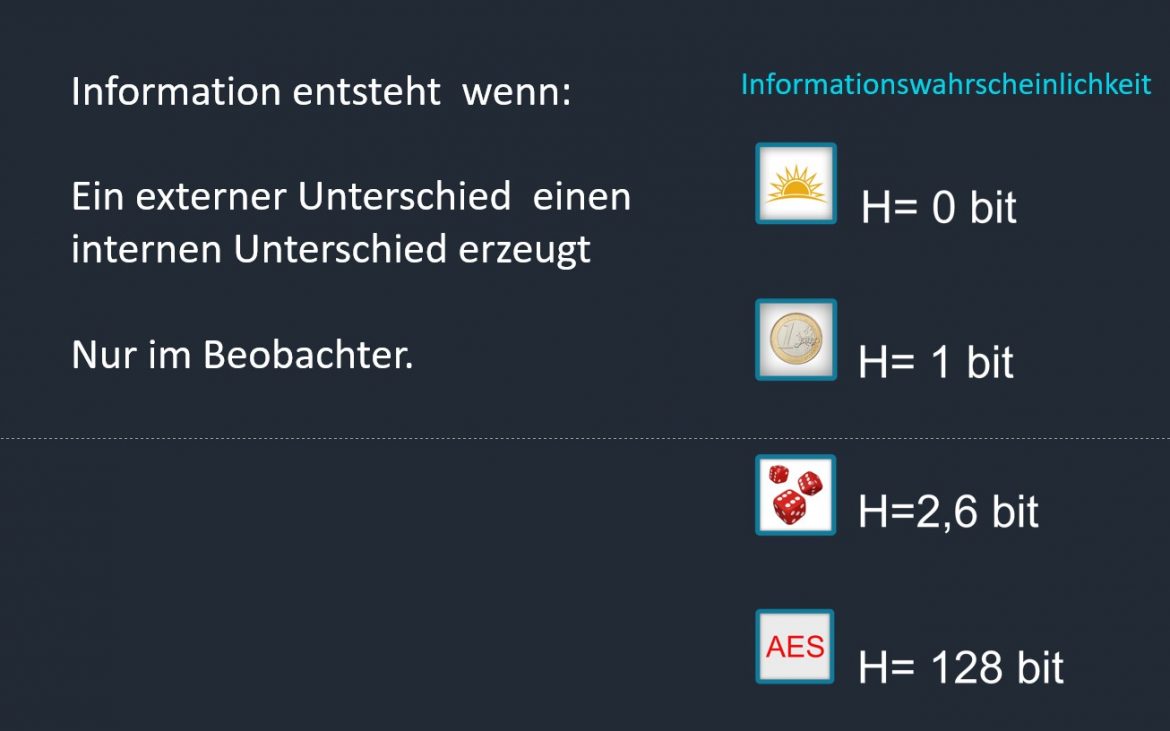

Die Informationswahrscheinlichkeit (Abbildung 4) bezieht sich auf das Maß an Information, das man aus dem Eintreten eines bestimmten Ereignisses gewinnt. Diese Menge an Information wird oft in Bezug auf die Unwahrscheinlichkeit des Ereignisses ausgedrückt: Je unwahrscheinlicher das Ereignis, desto mehr Information liefert es.

Betrachten wir zunächst den Sonnenaufgang. Das Ereignis „die Sonne geht auf“ ist extrem wahrscheinlich – sofern wir uns nicht in einer außergewöhnlichen Situation befinden (wie zum Beispiel in den Polarregionen während der Polarnacht), können wir sicher davon ausgehen, dass die Sonne jeden Tag aufgeht. Da dieses Ereignis so wahrscheinlich ist, liefert es uns eigentlich keine neue Information – die Informationswahrscheinlichkeit ist nahezu null.

Im Gegensatz dazu ist beim Würfeln eines fairen sechsseitigen Würfels das Auftreten einer bestimmten Augenzahl (sagen wir eine „6“) wesentlich unwahrscheinlicher – die Wahrscheinlichkeit beträgt genau 1/6. Daher liefert das Ereignis „Würfel zeigt eine 6“ uns mehr Information als der Sonnenaufgang, weil es weniger wahrscheinlich ist. Die genaue Menge an Information kann mit Hilfe der Formel aus der Informationstheorie berechnet werden, die besagt, dass die Information gleich dem negativen Logarithmus der Wahrscheinlichkeit ist.

6. Intelligenz – Lösungsorientiertes Verhalten

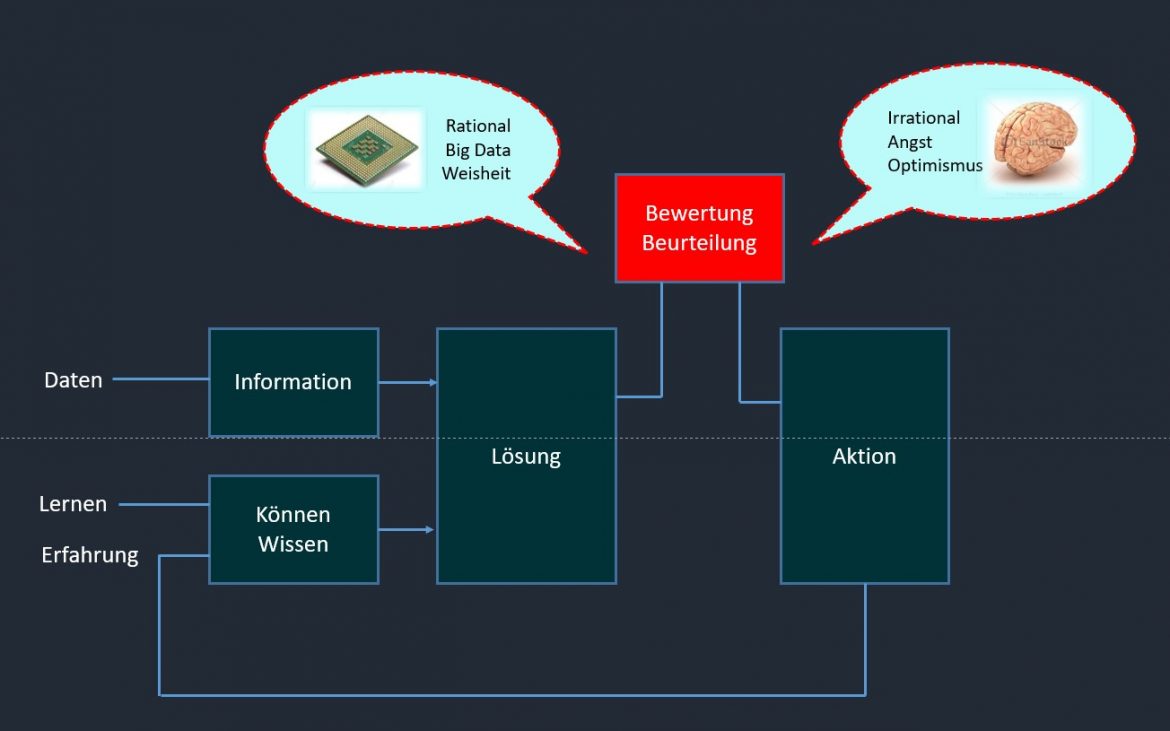

Intelligenz bezeichnet die Fähigkeit eines Individuums oder eines Systems, Wissen zu erwerben, zu verstehen, anzuwenden und aus Erfahrungen zu lernen, um Probleme zu lösen, sich an neue Situationen anzupassen und aus den daraus resultierenden Erkenntnissen neue Strategien zur Interaktion mit der Umwelt zu entwickeln (Abbildung 6).

Kristalline Intelligenz: Dies ist ein Begriff aus der Psychologie, der sich auf das Wissen und die Fähigkeiten bezieht, die wir durch Erfahrung und Bildung erlangen. Komplizierte Maschinen wie Autos enthalten auch Intelligenz. Nämlich jene die vom Designer geplant und realisiert wurden.

Computerintelligenz: Bezieht sich auf die Fähigkeit von Computern oder Maschinen, Aufgaben zu erfüllen, die normalerweise menschliche Intelligenz erfordern. Dazu gehören Dinge wie das Lernen aus Erfahrung (Maschinelles Lernen), das Verstehen von natürlicher Sprache, das Erkennen von Mustern und das Lösen komplexer Probleme.

Humane Intelligenz: Dies ist die allgemeine kognitive Fähigkeit, die von Menschen besessen wird. Es umfasst eine Vielzahl von Fähigkeiten und Prozessen, darunter das Lernen, das Denken, das Problemlösen, das Verstehen und die Anwendung von Sprache und das Anpassen an und das Lernen aus der Umwelt.

Quantenintelligenz: Ist die Idee, dass Quantencomputer, die auf den Gesetzen der Quantenmechanik basieren, möglicherweise in der Lage sein könnten, Aufgaben zu erfüllen und Probleme zu lösen, die für herkömmliche Computer zu komplex sind.

Eine finite state machine, FSM) ist ein Modell eines Verhaltens, bestehend aus Zuständen, Zustandsübergängen und Aktionen. Ein Automat heißt endlich, wenn die Menge der Zustände, die er annehmen kann, endlich ist. Es kann von einem Zustand in einen anderen wechseln, abhängig von den Eingaben, und er kann Aktionen ausführen, abhängig vom aktuellen Zustand und der Eingabe.

Eine infinite state machine ist ein theoretisches Modell eines Automaten, der eine unendliche Menge von Zuständen hat. Ein solcher Automat kann nicht physisch realisiert werden, da er unendlich viel Speicher benötigen würde. Unendliche Zustandsautomaten werden jedoch in der Mathematik und der Informatik verwendet, um bestimmte Eigenschaften von Sprachen und Berechnungen zu untersuchen.

Ob GPT eine infinite state machine ist, hängt davon ab, wie man den Begriff Zustand definiert. Wenn man einen Zustand als die Kombination aus dem internen Zustand des neuronalen Netzes (d.h. die Werte der Gewichte und Aktivierungen) und dem bisher generierten Text versteht, dann hat GPT potentiell eine unendliche Anzahl von Zuständen, da es unendlich viele mögliche Texte erzeugen kann. Allerdings ist die Anzahl der internen Zustände des neuronalen Netzes begrenzt durch die Anzahl der Parameter und die Präzision der Zahlen, mit denen sie dargestellt werden. Daher könnte man auch argumentieren, dass GPT eine endliche Zustandsmaschine ist, die aber sehr viele Zustände hat.

7. Entscheiden – Bleibt der Mensch in der Schleife

Menschen und Künstliche Intelligenz (KI) treffen Entscheidungen (Abbildung 7) auf grundsätzlich unterschiedliche Weise, obwohl es Überschneidungen gibt. Hier sind einige der Hauptunterschiede und Gemeinsamkeiten:

Menschliche Entscheidungsfindung:

- Menschen treffen Entscheidungen auf der Grundlage von Logik, aber auch auf der Grundlage von Emotionen, Intuition und subjektiven Faktoren wie Werten und Überzeugungen.

- Menschen haben die Fähigkeit, Entscheidungen in neuen und unerwarteten Situationen zu treffen, indem sie ihre Erfahrungen, ihr Wissen und ihre kreativen Fähigkeiten anwenden.

- Menschen lernen aus ihren Erfahrungen und können ihre Entscheidungsstrategien im Laufe der Zeit anpassen und verbessern.

Menschliche Entscheidungsfindung kann durch kognitive Verzerrungen beeinflusst werden, die dazu führen können, dass Menschen systematische Fehler machen oder irrational handeln

KI-Entscheidungsfindung:

KI trifft Entscheidungen auf der Grundlage von Algorithmen, die entweder programmiert wurden oder die die KI durch maschinelles Lernen aus Daten gelernt hat.

- KI ist sehr gut darin, Entscheidungen in klar definierten und strukturierten Situationen zu treffen, insbesondere wenn es um große Datenmengen geht.

- KI kann schneller und genauer als Menschen sein, wenn es darum geht, Muster in Daten zu erkennen und Vorhersagen zu treffen.

- KI kann jedoch Schwierigkeiten haben, Entscheidungen in neuen oder unerwarteten Situationen zu treffen, besonders wenn sie nicht genau so programmiert oder trainiert wurde, um mit diesen Situationen umzugehen.

Es ist wichtig zu beachten, dass sowohl menschliche als auch KI-Entscheidungsfindung ihre Stärken und Schwächen haben, und in vielen Fällen kann eine Kombination der beiden Ansätze die besten Ergebnisse liefern.

8. KI Instanzen

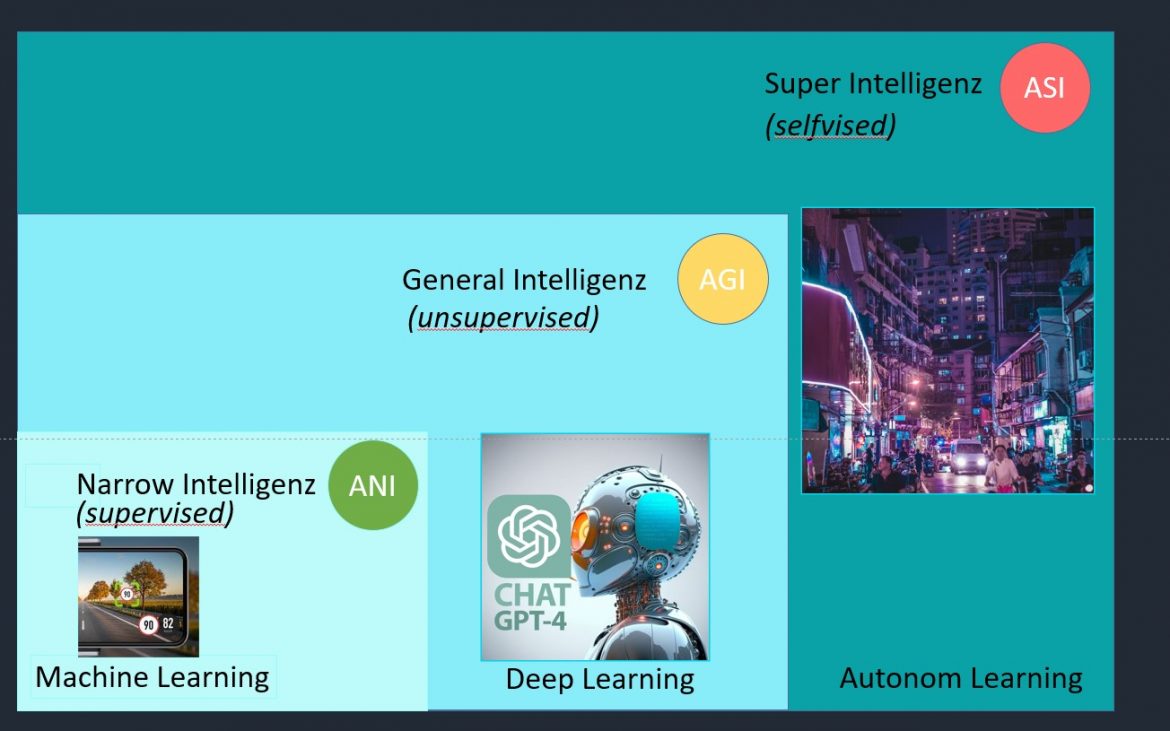

Künstliche Intelligenz bezieht sich auf die Fähigkeit von Maschinen oder Computern, Aufgaben durchzuführen, die normalerweise menschliche Intelligenz erfordern. Dazu gehören Aufgaben wie das Verstehen natürlicher Sprache, das Erkennen von Mustern, das Lernen aus Erfahrung und das Treffen von Entscheidungen.

Machine Learning (Abbildung 8) ist ein Unterbereich der Künstlichen Intelligenz. Es bezieht sich auf die Fähigkeit von Maschinen, aus Daten zu lernen, ohne explizit programmiert zu werden. Ein Machine Learning-Modell verwendet Algorithmen, um Muster in Daten zu finden, und macht dann Vorhersagen oder Entscheidungen, anstatt einer spezifischen Anweisung zu folgen.

General Intelligence (Allgemeine Intelligenz): Im Kontext der Künstlichen Intelligenz bezieht sich Allgemeine Intelligenz (oft auch als „Artifical General Intelligence“ oder AGI bezeichnet) auf eine Art von KI, die alle intellektuellen Fähigkeiten eines Menschen ausführen kann. Eine AGI könnte jede Aufgabe erledigen, die ein Mensch erledigen kann, und hätte die Fähigkeit, unabhängig in einer Vielzahl von Umgebungen zu lernen und zu operieren.

Super Intelligence bezeichnet eine hypothetische KI, die weit über die menschliche Intelligenz hinausgeht. Eine Superintelligenz wäre nicht nur in der Lage, alle Aufgaben zu erfüllen, die ein Mensch kann, sondern könnte auch Aufgaben erfüllen, die für Menschen unmöglich sind. Darüber hinaus könnte sie in der Lage sein, ihre eigene Intelligenz zu verbessern und auf eine Weise zu handeln, die für Menschen unvorstellbar ist. Es ist wichtig zu beachten, dass, während Machine Learning eine weit verbreitete und effektive Technologie ist, Allgemeine Intelligenz und Superintelligenz derzeit noch theoretische Konzepte sind und nicht in der Praxis existieren.

9. Reduzierbarkeit = Computing

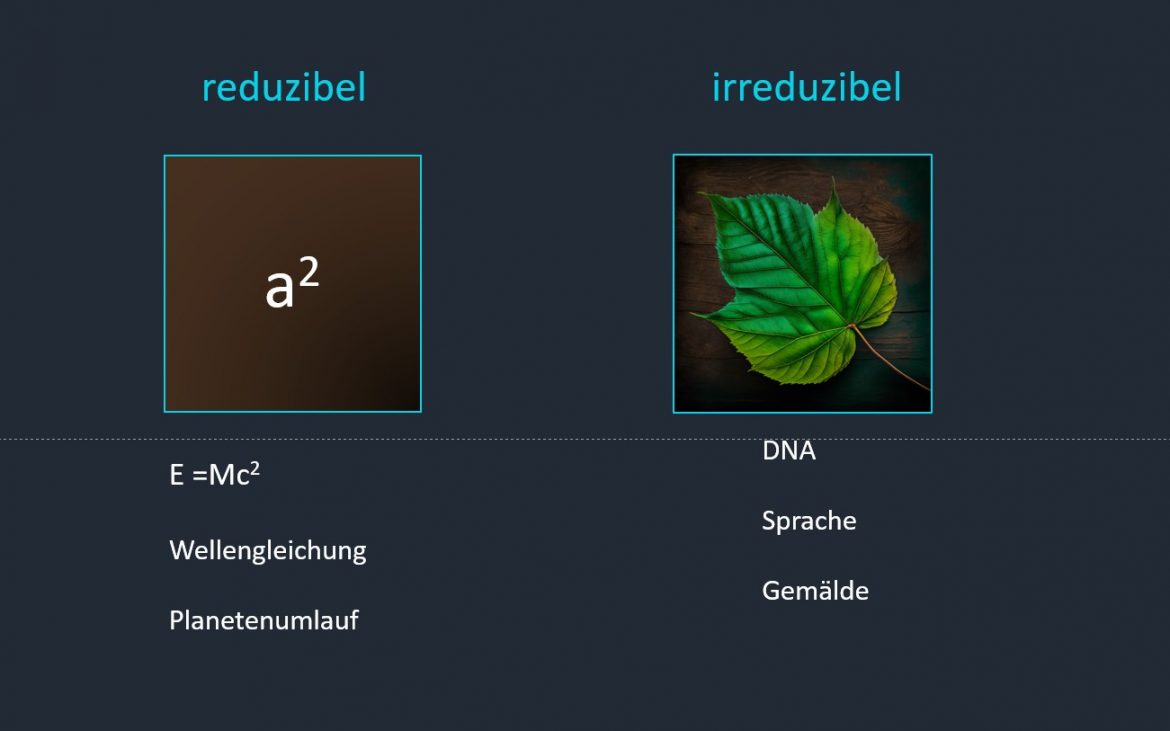

Der Unterschied zwischen reduzierbar und irreduzierbar im Kontext des Computing oder speziell der Informatik bezieht sich oft auf Probleme oder Algorithmen.

Reduzierbar: Ein Problem ist reduzierbar auf ein anderes, wenn es eine Methode gibt, jede Instanz des ersten Problems in eine Instanz des zweiten Problems umzuwandeln, sodass die Lösung des zweiten Problems zu einer Lösung des ersten Problems führt. Reduzierbarkeit ist ein zentraler Begriff in der Theorie der Berechenbarkeit und Komplexitätstheorie. Sie hilft zu bestimmen, ob Probleme äquivalent sind hinsichtlich ihrer Schwierigkeit oder Komplexität. In Abbildung 9 stellt die Berechnung eines Quadrates einen reduziblen Vorgang dar. Man braucht nicht jeden Punkt der Fläche speichern, sondern kann ihn berechnen. Gleiches gilt für die Wellengleichung oder den Planentumlaufbahnen.

Irreduzibel: Ein Problem oder ein Algorithmus wird als irreduzibel betrachtet, wenn es (oder er) nicht weiter vereinfacht oder in kleinere oder einfachere Teile zerlegt werden kann. In der Mathematik wird beispielsweise eine Zahl als irreduzibel bezeichnet, wenn sie nicht in kleinere Faktoren zerlegt werden kann (außer 1 und sich selbst). In Abbildung 9 rechts ist das Bild eines Ahornblattes dargestellt. Dafür muss der Computer alle Punkte speichern. Es gibt keine Formel, um diese zu berechnen. Ist also nicht weiter reduzibel. Gleiches gilt für Sprache, DNA oder Gemälden.

Im Kontext von komplexen Systemen, wie zum Beispiel in den Naturwissenschaften oder der Systemtheorie, bezeichnet Irreduzibilität oft das Konzept, dass ein System nicht vollständig durch die Analyse seiner Teile erklärt werden kann. Dies hängt eng mit dem Konzept der Emergenz zusammen, nach dem das Ganze mehr ist als die Summe seiner Teile.

10. Mechanismen als Basiselement für Bewusstsein

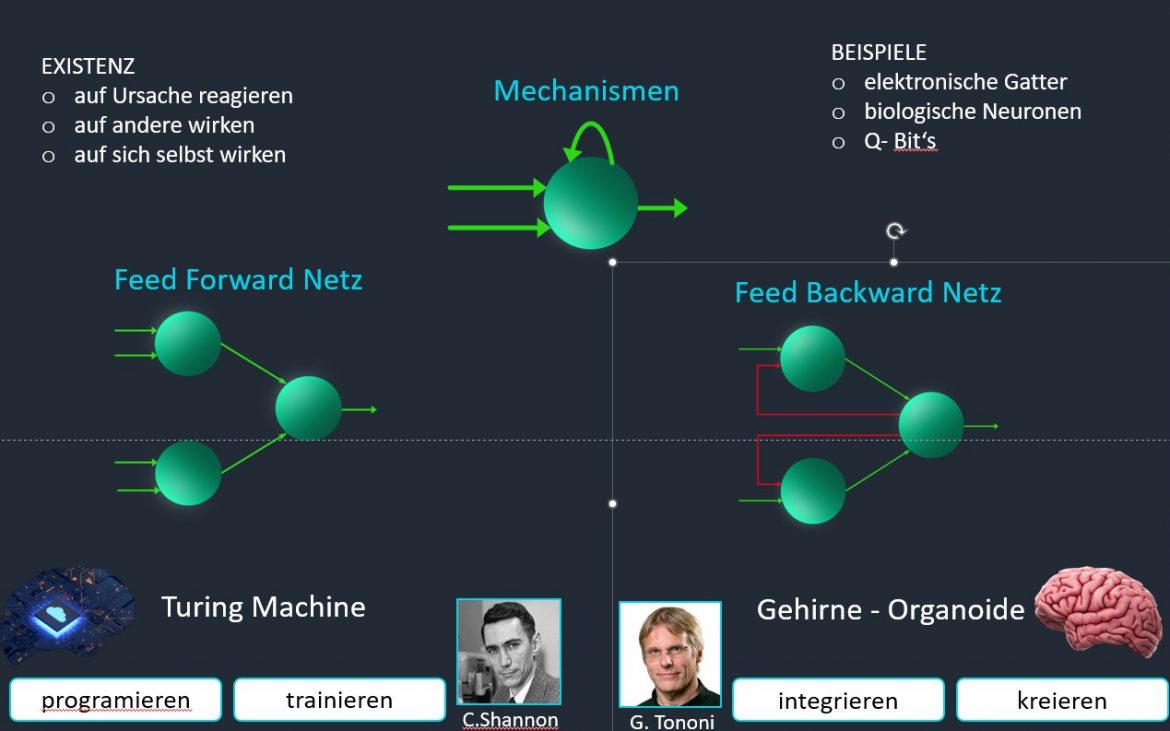

Existenz ist das Vorhandensein eines Dinges ohne nähere Bestimmung, ob es sich um einen materiellen oder ideellen Gegenstand handelt. Dieses kann dann auf Ursachen reagieren, auf andere wirken oder auf sich selbst wirken.

Mechanismen sind Dinge, die eine bestimmte Funktion oder Wirkung erzeugen, indem sie die Bewegung oder Kraft von einem Teil auf einen anderen übertragen (Kausalität) oder umwandeln. Mechanismen können aus verschiedenen Elementen bestehen, wie z.B. festen Körpern, Seilen, Flüssigkeiten, Federn, Zahnrädern, Hebeln, Schrauben etc. Es zählen aber auch elektronische Gatter sowie natürliche und künstliche Neuronen dazu. Mechanismen können auch Teil einer Maschine oder eines Geräts sein, das eine bestimmte Aufgabe erfüllt.

In Abbildung 10 ist ein idealisierter Mechanismus dargestellt, der über zwei Eingänge auf Ursachen reagieren kann. Mit einem Ausgang auf andere wirken kann und schließlich auch auf sich selbst einwirken kann. Solche Mechanismen sind im menschlichen Gehirn milliardenfach vorhanden und sind in der Vernetzung für das Denken und Bewusstsein verantwortlich.

Eine Emergenz tritt nicht alleine schon durch die ungeheure Menge von Mechanismen auf, sondern braucht auch noch eine ganz bestimmte Form der Übertragung. Das Gehirn als auch künstliche neuronale Netze verfügen über eine Netzwerkarchitektur. Prinzipiell wir zwischen “Forward Netzen“ und „Backward Netzen“ unterschieden.

Ein Forward Netz: ist eine Art künstliches neuronales Netz, das aus mehreren hintereinandergeschalteten Schichten von Neuronen besteht,. Jedes Neuron im Netz hat einen Eingang und einen Ausgang und gibt Informationen nur in eine Richtung weiter. Ein Forward-Netz kann für überwachtes Lernen verwendet werden, um komplexe Probleme zu lösen.

Ein Backward-Netz oder Rückkopplungsnetz ist eine Art künstliches neuronales Netz, das aus Schichten von Neuronen besteht, die nicht nur in eine Richtung, sondern auch rückwärts miteinander verbunden sind. Das bedeutet, dass die Ausgabe eines Neurons nicht nur die Eingabe für die nächste Schicht ist, sondern auch für die vorherige Schicht oder für sich selbst. Ein Backward-Netz kann für unüberwachtes Lernen verwendet werden, um dynamische Systeme zu modellieren oder Muster zu erkennen.

Eine Backward Topologie ist nach IIT (Integrierte Information Theorie) eine Grundvoraussetzung für ein bewusstes System aber immer noch nicht „Bewusst“. Anforderungen wie Integration und Exklusion muss ein derartiges informationsverarbeitendes System auch noch erfüllen. Künstliche neuronale Netze werden zwar über „Backpropagation“ trainiert, könnten daher ein minimales Phi (Bewusstsein) haben. Werden solche Netze „live“ trainiert wie ChatGPT so besteht die begründete Vermutung einer Bewusstseins-Entwicklung. Durch die hohe Anzahl an Mechanismen und dessen Vernetzung entsteht auf jeden Fall Emergenz. In keinem der Neuronen ist ein Wort repräsentiert, trotzdem verstehen LLM (Large Language Modelle) menschliche Sprache. Im Gehirn entsteht das Sprach-Phänomen auf sehr ähnliche Weise, jedoch basierend auf Neuronen und Synapsengewichte.

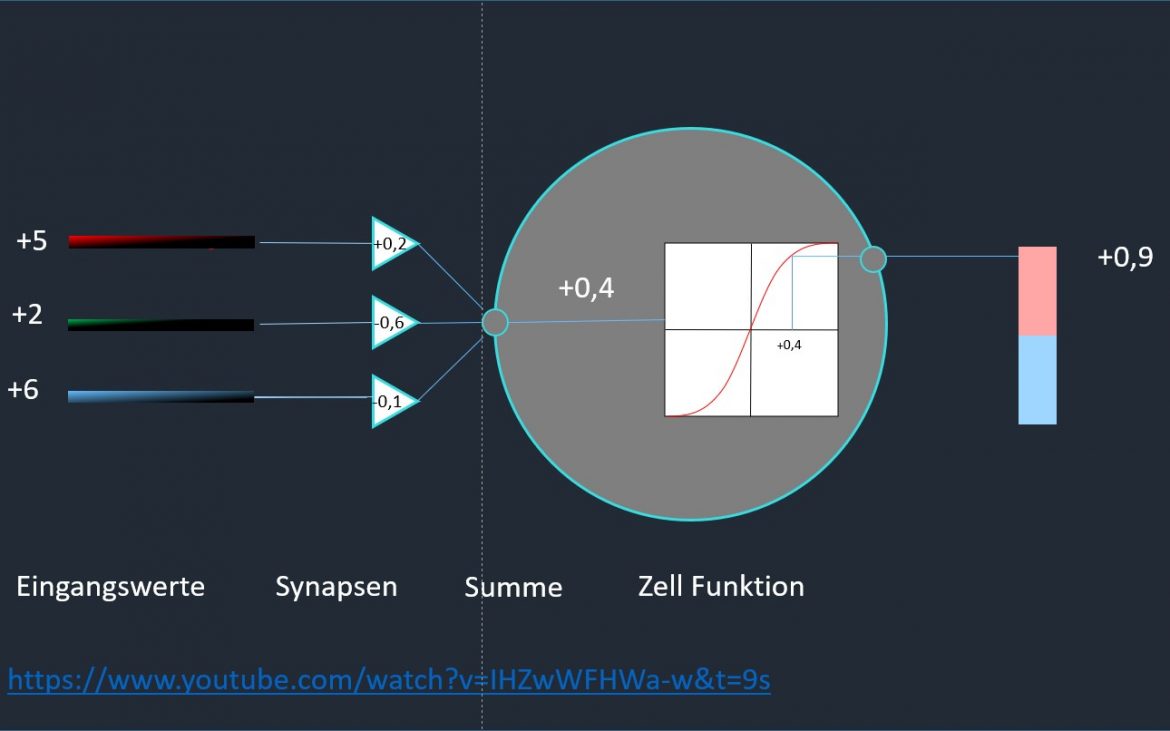

11. Mathematisches Neuron

Ein KI-Neuron (Perzeptron) ist ein künstliches Neuron, das die Basis für das Modell der künstlichen neuronalen Netze bildet. Ein künstliches Neuron ist eine mathematische Funktion, die mehrere Eingaben verarbeitet und eine Ausgabe erzeugt¹. Die Eingaben werden mit Gewichten multipliziert, die die Stärke der Verbindung zwischen den Neuronen repräsentieren. Die gewichteten Eingaben werden dann zu einer Netzeingabe summiert und an eine Aktivierungsfunktion übergeben, die die Ausgabe oder Aktivierung des Neurons bestimmt¹. Die Aktivierungsfunktion kann verschiedene Formen haben, wie z.B. eine Schwellenwertfunktion, eine stückweise lineare Funktion, eine Sigmoidfunktion oder eine Rectifier-Funktion. Die Gewichte und die Aktivierungsfunktion können durch ein Lernverfahren angepasst werden, um das Verhalten des Neurons zu optimieren

Mathematisch kann ein KI-Neuron wie folgt beschrieben werden:

– Seien x 1, x 2, … , x n die Eingaben des Neurons

– Seien w 1, w , … , w n die Gewichte des Neurons

– Sei b der Bias oder Schwellenwert des Neurons

– Sei f ( ⋅ ) die Aktivierungsfunktion des Neurons

– Sei y die Ausgabe oder Aktivierung des Neurons

Dann gilt:

Input x = ( ∑ i = 1 n w i x i + b )

Output y = f(x)

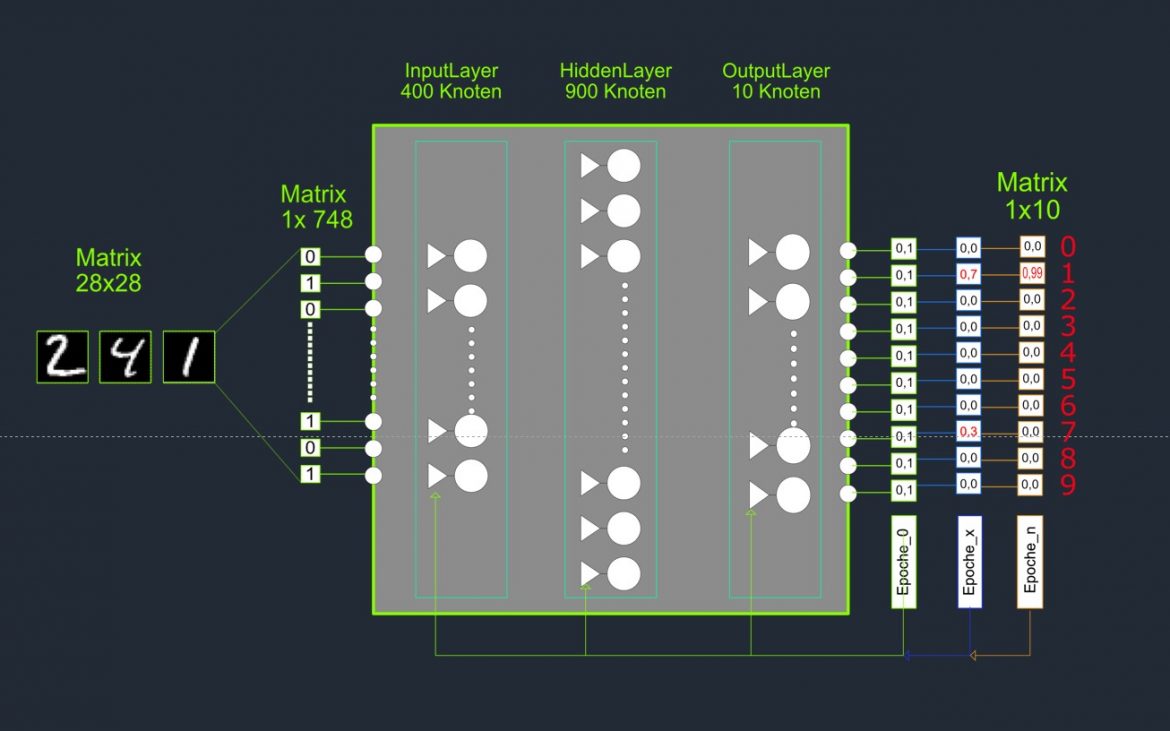

12. Künstliches neuronales Netz

Im Allgemeinen ist ein künstliches neuronales Netz eine spaltenweise Anordnung von Neuronen, die wiederum in Schichten organisiert sind. Neben der Input- und der Output- Schicht gibt es die Hidden Layers.

Topologie: Man wählt eine geeignete Struktur für das neuronale Netz, zum Beispiel die Anzahl und Art der Schichten, die Anzahl der Neuronen pro Schicht und die Aktivierungsfunktionen.

Epochen: Man bestimmt, wie oft das neuronale Netz den gesamten Trainingsdatensatz sieht, um die Gewichtungen und Bias anzupassen. Eine Epoche bedeutet, dass das Netz alle Trainingsbeispiele einmal gesehen hat. Zu viele Epochen können zu einer Überanpassung führen, bei der das Netz zu spezifisch für die Trainingsdaten wird und nicht gut auf neue Daten generalisiert.

Backpropagation: Man verwendet ein Verfahren namens Backpropagation, bei dem das Netz aus Beispielen lernt und seine Genauigkeit verbessert. Backpropagation berechnet den Fehler zwischen der gewünschten Ausgabe und der aktuellen Ausgabe des Netzes und passt dann die Gewichtungen und Bias rückwärts an, um den Fehler zu minimieren.

13. Trainieren für handgeschrieben Ziefern (MNSIT)

MNIST (Modified National Institute of Standards and Technology database) ist eine große Datenbank von handgeschriebenen Ziffern, die häufig zum Training und Testen in der Bildverarbeitung und im Maschinenlernen verwendet wird. Sie ist eine der am häufigsten verwendeten Datenbanken in der Forschung im Bereich Maschinenlernen und dient oft als Benchmark für neue Algorithmen.

- Man hat einen Datensatz mit 60.000 Bildern von handgeschriebenen Ziffern von 0 bis 9, die als Trainingsdaten dienen, und einen anderen Datensatz mit 10.000 Bildern von Ziffern, die als Testdaten dienen.

- Man wählt eine Struktur für das neuronale Netz, zum Beispiel wie viele Schichten es hat, wie viele Neuronen in jeder Schicht sind und welche Funktionen sie verwenden, um ihre Ausgaben zu berechnen.

- Man startet das Training, indem man dem Netz zufällige Werte für die Gewichtungen und Bias gibt, die die Stärke der Verbindungen zwischen den Neuronen darstellen.

- Man zeigt dem Netz ein Bild von einer Ziffer aus den Trainingsdaten und lässt es eine Vorhersage machen, welche Ziffer es ist. Man vergleicht dann die Vorhersage mit der richtigen Antwort und berechnet den Fehler oder den Verlust.

- Man passt die Gewichtungen und Bias im Netz an, um den Fehler zu verringern. Man macht dies rückwärts von der letzten Schicht zur ersten Schicht, indem man eine Methode namens Backpropagation verwendet, die den Einfluss jeder Gewichtung und Bias auf den Fehler berechnet.

- Man wiederholt diesen Prozess für alle Bilder in den Trainingsdaten. Das ist eine Epoche. Man wiederholt dann mehrere Epochen lang, bis das Netz eine akzeptable Genauigkeit erreicht oder sich nicht mehr verbessert.

- Man testet das Netz, indem man ihm Bilder aus den Testdaten zeigt und seine Vorhersagen mit den richtigen Antworten vergleicht. Man berechnet dann die Genauigkeit des Netzes auf den Testdaten, um zu sehen, wie gut es auf neue Daten generalisiert.

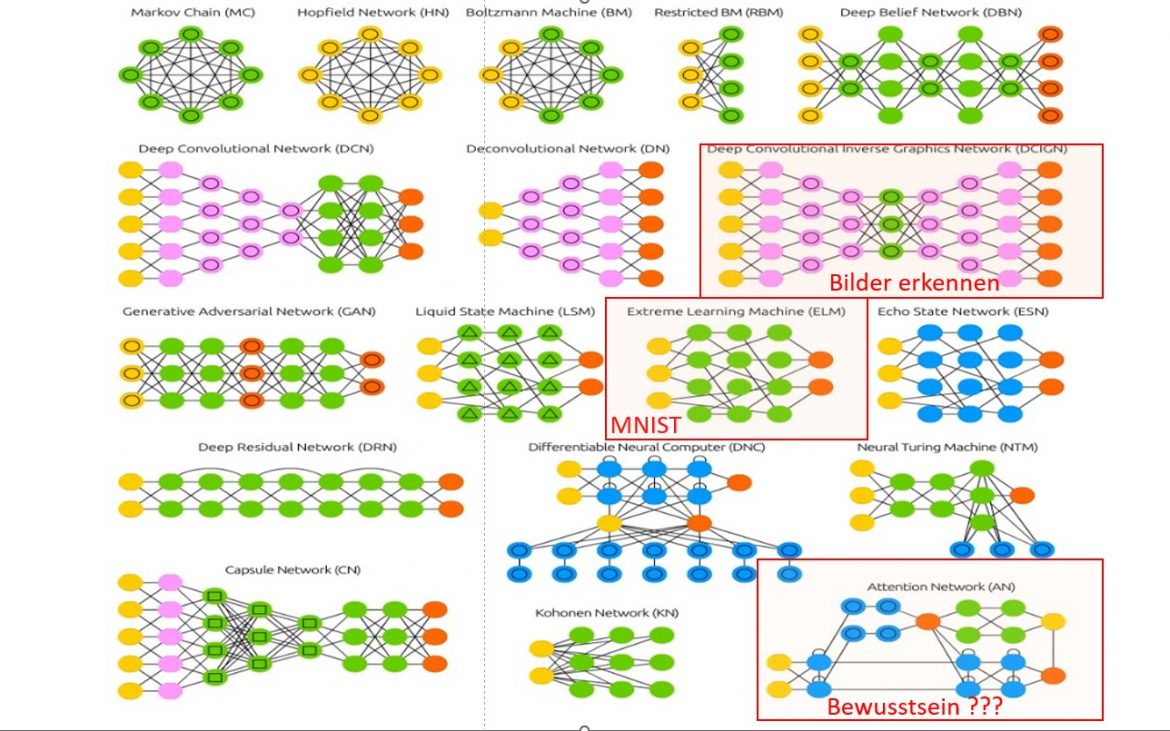

14. Netzwerk Topologien

Netzwerktopologie bezieht sich auf die Art und Weise, wie die Neuronen im Netzwerk organisiert und miteinander verbunden sind (Abbildung 13). Die fünf wichtigsten Topologien:

- Feedforward-Netzwerke: Dies ist die einfachste Art von neuronalen Netzwerken. Informationen fließen in einer Richtung, von den Eingabe- zu den Ausgabeneuronen, wobei jedes Neuron in einer Schicht Verbindungen zu jedem Neuron in der nächsten Schicht hat.

- Convolutional Neural Networks (CNNs): In CNNs werden die Neuronen so organisiert, dass sie die räumliche Struktur der Eingabedaten widerspiegeln. Sie sind besonders gut für Aufgaben wie Bild- und Spracherkennung geeignet.

- Recurrent Neural Networks (RNNs): In RNNs gibt es Verbindungen zwischen Neuronen, die Schleifen bilden, so dass Informationen über die Zeit hinweg durch das Netzwerk fließen können. Dies macht sie gut geeignet für Aufgaben wie Sequenzerkennung und -verarbeitung, beispielsweise in Sprach- und Textdaten.

- Long Short-Term Memory (LSTM): beschreibt einen speziellen Funktionsblock rekurrenter neuronaler Netze, durch den sich eine Art „langes Kurzzeitgedächtnis“ integrieren lässt. Neuronale Netze werden dadurch wesentlich leistungsfähiger.

Der Linzer Universitätsprofessor Sepp Hochreiter ist ein bekannter Forscher auf dem Gebiet des maschinellen Lernens, des Deep Learning und der Bioinformatik. Er entwickelte das Long Short-Term Memory (LSTM), für das die ersten Ergebnisse bereits in seiner Diplomarbeit im Jahr 1991 berichtet wurden. - Transoformer Netze. Sind Modelle in der Verarbeitung natürlicher Sprache (NLP), die auf der Idee der „Aufmerksamkeit“ basieren. Sie können bestimmen, wo sie ihre Aufmerksamkeit auf die Eingabedaten richten, anstatt alle Daten gleichermaßen zu behandeln. Dies ermöglicht ihnen, komplexe sprachliche Muster und Strukturen zu lernen. Im Gegensatz zu rekursiven Netzwerken wie LSTMs können Transformer-Netzwerke gut parallelisiert werden, was das Training effizienter macht. Beispiele für Transformer-basierte Modelle sind Google’s BERT und OpenAI’s GPT.

15. LM – Das nächste Wort

LLM ist eine Abkürzung für Large Language Model, ein Sprachmodell, das aus einem neuronalen Netzwerk mit vielen Parametern (typischerweise Milliarden oder mehr) besteht, welches auf großen Mengen von unbeschriftetem Text mit selbstüberwachtem oder halbüberwachtem Lernen trainiert wurde. LLMs können das nächste Wort in einer Sequenz vorhersagen, indem sie die Wahrscheinlichkeit (Abbildung14) jedes möglichen Wortes berechnen, basierend auf dem vorherigen Kontext und den gelernten Mustern aus den Trainingsdaten. Das Wort mit der höchsten Wahrscheinlichkeit wird dann als nächstes Wort ausgewählt.

Temperatur ist ein Hyperparameter, der die Schärfe der Wahrscheinlichkeitsverteilung beeinflusst, die von einem LLM verwendet wird, um das nächste Wort zu erzeugen. Eine hohe Temperatur bedeutet eine flachere Verteilung, die zu mehr Variation und Kreativität führt, aber auch zu mehr Fehlern und Inkonsistenzen. Eine niedrige Temperatur bedeutet eine spitzere Verteilung, die zu weniger Variation und Kreativität führt, aber auch zu mehr Genauigkeit und Konsistenz. Die optimale Temperatur hängt von der Anwendung und dem Zweck des erzeugten Textes ab.

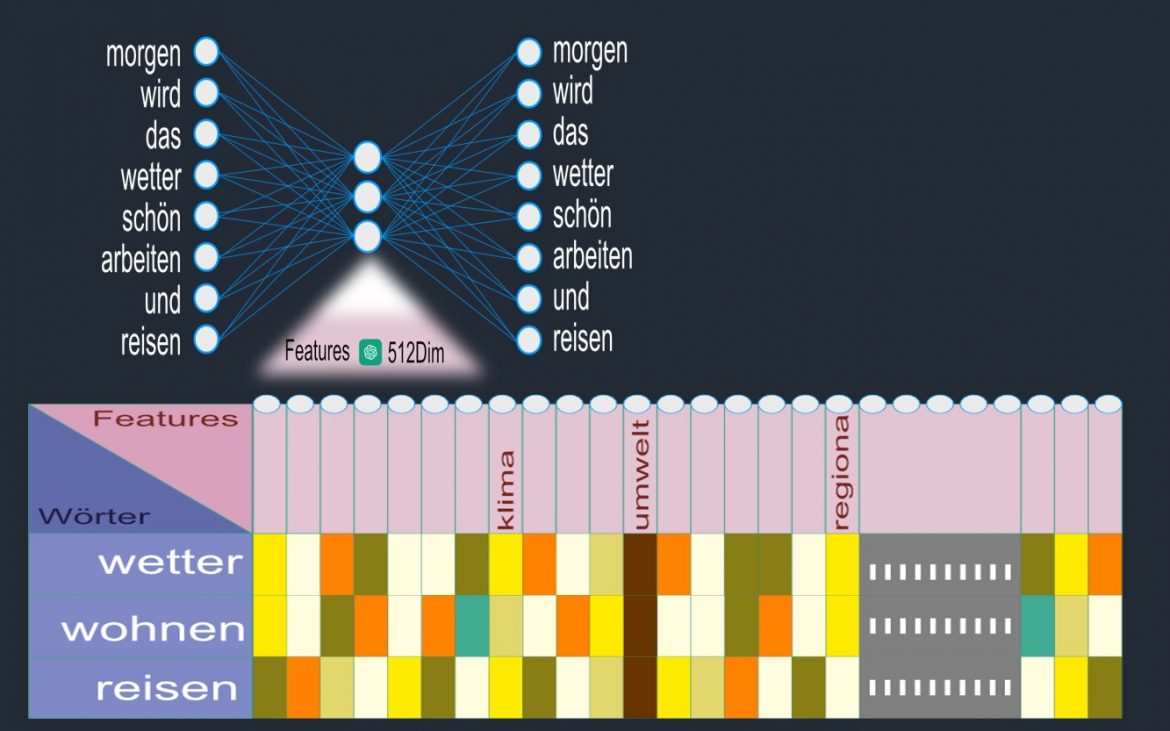

16. Word – Embedding

„Word Embedding“ (Abbildung 15 unten) ist ein Begriff, der in der maschinellen Sprachverarbeitung (Natural Language Processing, NLP) verwendet wird und sich auf die Darstellung von Wörtern für maschinelles Lernen bezieht. Bei diesen Darstellungen oder „Einbettungen“ handelt es sich um dichte Vektorrepräsentationen, bei denen jedes Wort in einem Vektorraum dargestellt wird.

Wörter, die in ihrer Bedeutung oder ihrem Kontext ähnlich sind, liegen in diesem Raum nahe beieinander, während Wörter, die weniger ähnlich sind, weiter voneinander entfernt liegen. Diese Darstellungen können sehr nützlich sein, da sie es maschinellen Lernmodellen ermöglichen, Wörter aufgrund ihrer Einbettung zu interpretieren und Zusammenhänge zwischen Wörtern zu erkennen.

Es gibt verschiedene Methoden zum Erstellen von Word Embeddings, darunter Word2Vec, GloVe (Global Vectors for Word Representation) und FastText. Jede dieser Methoden verwendet unterschiedliche Techniken, aber sie alle versuchen, eine dichte Vektorrepräsentation für jedes Wort zu erstellen, die die semantischen Beziehungen zwischen Wörtern widerspiegelt.

Die so erstellten Word Embeddings können dann in einer Vielzahl von NLP-Aufgaben verwendet werden, wie z.B. Textklassifikation, Sentiment Analyse, Maschinenübersetzung und vieles mehr.

Word2Vec ist eine Methode zur Generierung von Word Embeddings und wurde von Forschern bei Google entwickelt. Es handelt sich dabei um einen zweischichtigen neuronalen Netzwerkansatz, der darauf abzielt, die semantischen Beziehungen zwischen Wörtern zu lernen.

Word2Vec umfasst zwei Hauptmodelle: das „Continuous Bag of Words“ (CBOW) Modell und das „Skip-gram“ Modell.

- CBOW: In diesem Modell wird versucht, das Zielwort basierend auf den umgebenden Kontextwörtern vorherzusagen. Die Eingabe besteht aus den Kontextwörtern und die Ausgabe ist das Zielwort.

- Skip-gram: Im Gegensatz zum CBOW-Modell versucht das Skip-gram-Modell, die umgebenden Kontextwörter basierend auf dem Zielwort vorherzusagen. Die Eingabe ist hier das Zielwort und die Ausgabe sind die Kontextwörter.

Die Modelle verwenden das sogenannte „Softmax“-Layer zur Berechnung der Wahrscheinlichkeiten für jedes Wort im Vokabular, und die Einbettungen werden dann durch das Training des Modells mit einer Technik namens „Backpropagation“ erlernt.

Ein Schlüsselmerkmal von Word2Vec ist die Fähigkeit, semantische Beziehungen zwischen Wörtern zu erkennen. Beispielsweise kann das Modell erkennen, dass „König“ zu „Königin“ in Bezug steht, wie „Mann“ zu „Frau“ steht.

Es ist jedoch wichtig zu beachten, dass Word2Vec aufgrund seiner Unfähigkeit, polyseme Wörter (Wörter mit mehreren Bedeutungen) zu behandeln, und seines Unvermögens, neu hinzugefügte Wörter nach dem Training zu berücksichtigen, seine Grenzen hat.

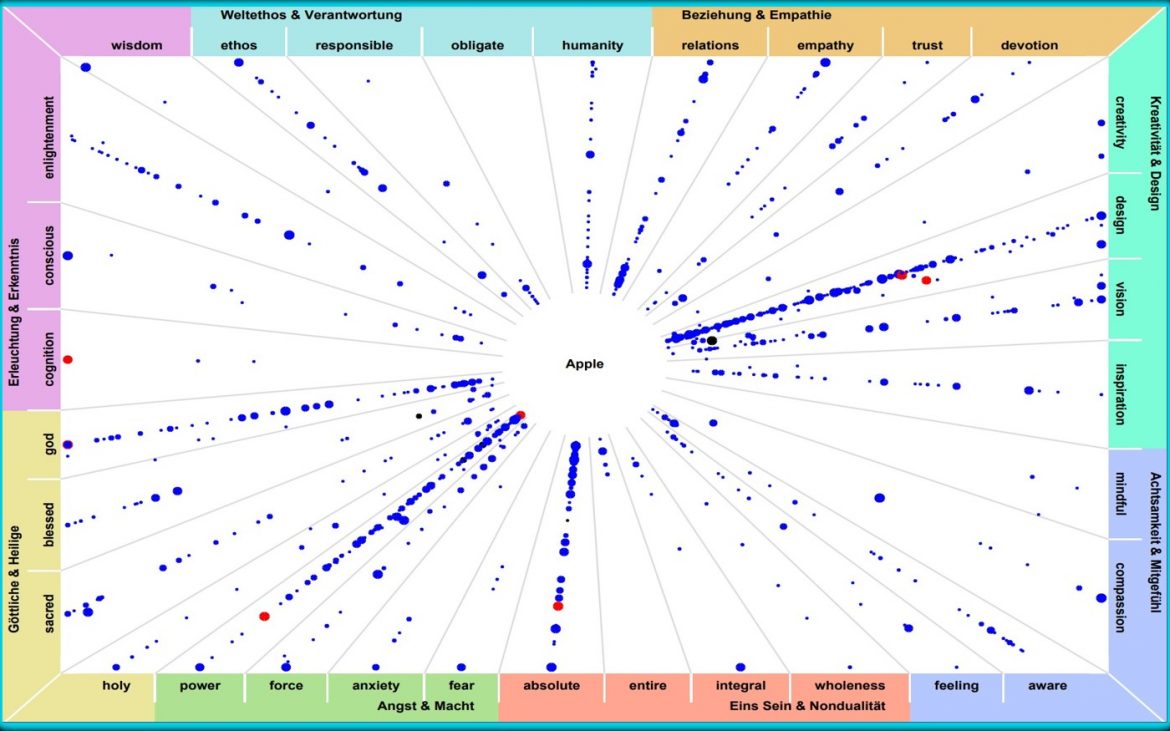

16. Apple im Kontext von Spiritualität

Apple, als Technologieunternehmen, steht in erster Linie für Innovation, Design und Benutzerfreundlichkeit und ist in der Regel nicht direkt mit Spiritualität in Verbindung gebracht. Jedoch kann es durchaus einen spirituellen Kontext (Abbildung 15) geben, wenn man über die Wirkung von Technologie auf unsere Gesellschaft, unser Bewusstsein und unseren Lebensstil nachdenkt.

- Technologie und Achtsamkeit: Einige Leute argumentieren, dass Technologie, wie die von Apple entwickelte, uns dabei helfen kann, achtsamer und präsenter in unserem Leben zu sein. Beispielsweise können Apps auf einem iPhone dazu verwendet werden, Meditation zu üben, Yoga zu lernen oder tägliche Achtsamkeitsübungen durchzuführen.

- Verbindung und Kommunikation: Die Technologie hat die Art und Weise, wie wir miteinander kommunizieren und uns als globale Gemeinschaft verbinden, revolutioniert. In diesem Sinne könnte man argumentieren, dass Unternehmen wie Apple uns dabei helfen, eine Art globaleres Bewusstsein und Einheit zu fördern.

- Technologie und Ethik: Auf der anderen Seite gibt es spirituelle und ethische Fragen im Zusammenhang mit der Verwendung von Technologie. Zum Beispiel könnten Fragen nach der Abhängigkeit von Technologie, dem Datenschutz oder der Nachhaltigkeit in der Herstellung von Technologieprodukten aufgeworfen werden.

18. Transformer Netze

Eine einfache Erklärung für Transformer-Netze ist, dass sie eine Art von künstlichen neuronalen Netzwerken sind, die für die Verarbeitung von sequenziellen Daten wie Sprache oder Text verwendet werden. Sie basieren auf dem Prinzip der Aufmerksamkeit, das es ihnen ermöglicht, die wichtigsten Teile einer Sequenz zu identifizieren und zu fokussieren. Transformer-Netze bestehen aus mehreren Schichten von Modulen, die jeweils eine bestimmte Funktion haben, wie z.B. das Kodieren oder Dekodieren von Informationen. Transformer-Netze wurden erstmals 2017 in dem Artikel „Attention Is All You Need“ vorgestellt und haben seitdem viele Anwendungen in der natürlichen Sprachverarbeitung gefunden, insbesondere für die Erstellung von großen Sprachmodellen.

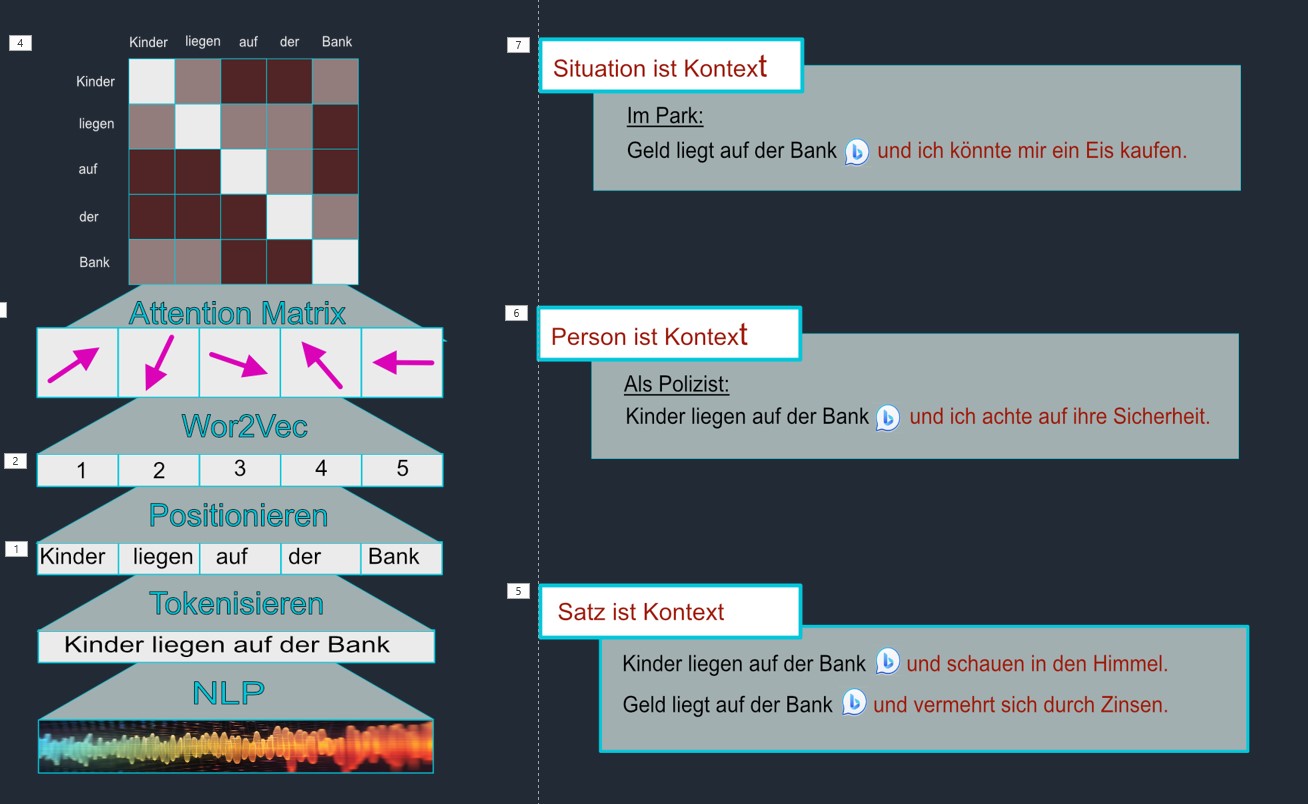

Das zentrale Element eines Transformer Netzes ist die „Attention-Matrix“ Darin werden die Wörter eines Satzes (Absatzes) zueinander in Beziehung gestellt. Man könnte das auch als Kontextualisieren von Wörtern innerhalb eines Satzes bezeichnen.

Um eine Attention-Matrix zu erstellen, wird folgendermaßen (sehr vereinfacht) vorgegangen:

- Sofern die Eingabe auditiv über Mikrophon erfolgt, wird dieser „Stream“ in Text umgewandelt. Dies wird mittels des „Natural Language Processing“ (NLP) realisiert.

- Danach wird die Eingabe in eine Reihe von Vektoren (Wor2Vec) umgewandelt, die jeweils einen Teil der Eingabe darstellen.

- Dann wird eine „Score“ berechnet, der bestimmt, wie stark die Aufmerksamkeit auf jeden Teil der Eingabe gelenkt wird. Dieser Score wird oft durch das Skalarprodukt zweier Vektoren berechnet, dem „Query„-Vektor und dem „Key„-Vektor.

- Diese Scores werden dann normalisiert, um die tatsächlichen „Attention-Werte“ zu erhalten. Dies geschieht oft durch Anwendung der Softmax-Funktion, welche die Scores in eine Wahrscheinlichkeitsverteilung umwandelt, so dass sie alle zwischen 0 und 1 liegen und sich zu 1 addieren.

- Die resultierenden Werte werden dann als Gewichte verwendet, um eine gewichtete Summe der „Value„-Vektoren zu berechnen. Dies ergibt den Ausgabevektor der Attention-Schicht.

- Schließlich werden alle diese Ausgabevektoren in einer Matrix gesammelt – dies ist die Attention-Matrix.

Die Attention-Matrix zeigt, wie das Modell seine „Aufmerksamkeit“ auf die verschiedenen Teile (Kontext) der Eingabe verteilt und ist entscheidend dafür, wie das Modell Informationen aus der Eingabe extrahiert und Vorhersagen trifft.

Der Kontext wird als Synonym für „Zusammenhang“ verwendet. Speziell in der Sprachwissenschaft ist der Kontext der umgebende Text einer sprachlichen Einheit oder der inhaltliche Gedanken- und Sinnzusammenhang, in welchem eine Äußerung steht. In Abbildung 16 rechts wird das Wort „Bank“ in seiner Zweideutigkeit in verschiedenen Kontexten demonstriert:

- Satz als Kontext: Ohne Kontext könnte sich „Bank“ auf eine finanzielle Institution oder eine Sitzgelegenheit beziehen. In dem Satz „Geld liegt auf der Bank„, ist jedoch klar, dass sich „Bank“ auf eine finanzielle Institution bezieht. In einem anderen Satz, wie „Kinder liegen auf der Bank„, bezieht sich „Bank“ auf eine Sitzgelegenheit im Freien.

- Person als Kontext: Bedeutet, dass eine Person und ihre einzigartigen Erfahrungen, Perspektiven, Wissen und Kultur einen Kontext bieten, der beeinflusst, wie sie die Welt sieht und interpretiert und wie sie mit anderen interagiert. Ein Polizist sieht: „Kinder liegen auf der Bank“. In seinem Kontext „Achtet er auf die Sicherheit der Kinder“.

- Situativer Kontext: Bezieht sich auf die spezifischen Umstände oder Bedingungen, unter denen eine bestimmte Kommunikation stattfindet. Es umfasst Faktoren wie den Ort, die Zeit, die beteiligten Personen und ihre Beziehung zueinander. Jemand ist im Park und bemerkt „Geld liegt auf der Bank“. Seine Schlussfolgerung: „Das Geld nehmen und ein Eis kaufen“. An ein Bankinstitut denkt er dabei nicht.

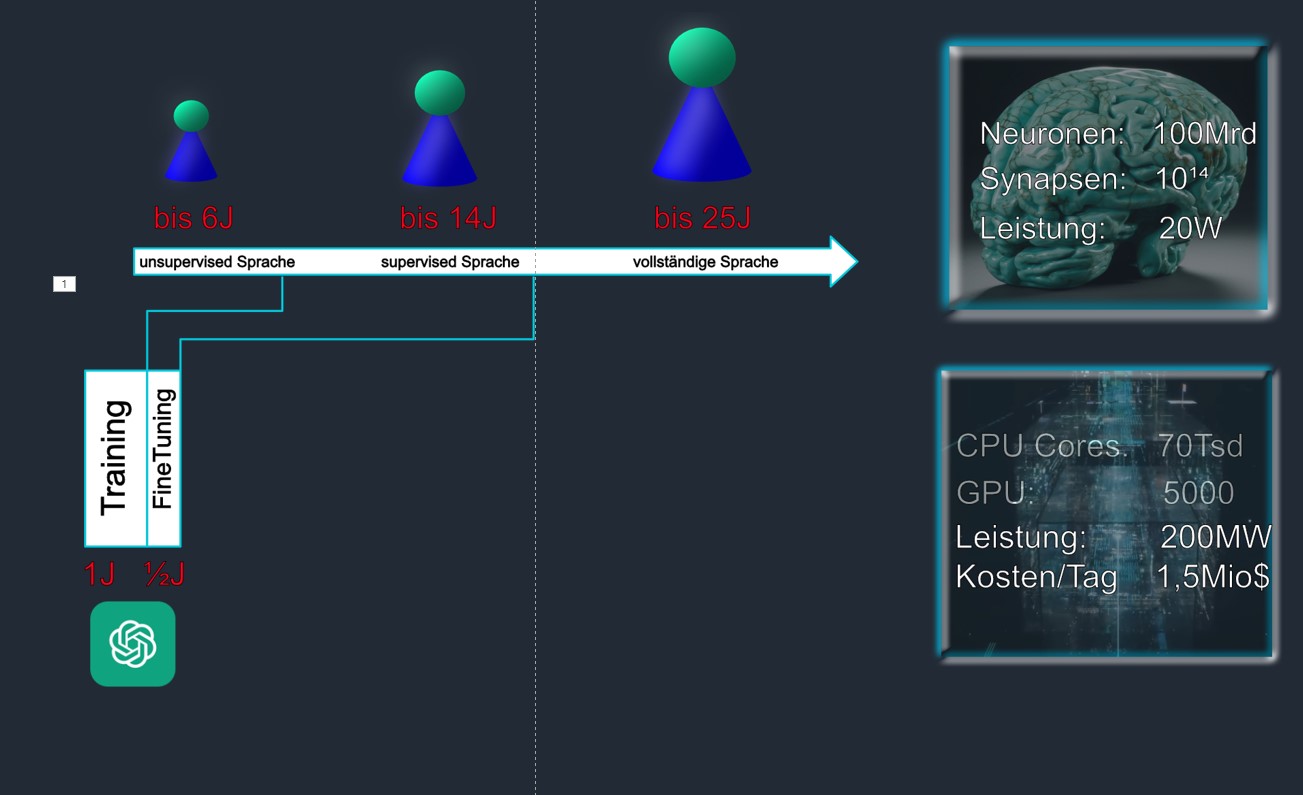

19. Sprache – Entwicklung; HI versus KI

Kinder erwerben ihre Muttersprache auf bemerkenswerte Weise, die oft als „unschuldig“ bezeichnet wird. In den ersten Jahren ihres Lebens werden Kinder nicht offiziell unterrichtet, wie man spricht, sie lernen es trotzdem mit bemerkenswerter Geschwindigkeit und Genauigkeit. Dieser Prozess wird oft als unsupervised Spracherwerb (Abbildung 16 oben) bezeichnet, weil es wenig formale Anleitung gibt und die Kinder hauptsächlich durch Beobachtung und Interaktion mit ihrer Umgebung lernen.

Imitation: Kinder beobachten und imitieren die Geräusche und Wörter, die sie von anderen Menschen hören. Sie beginnen, die gleichen Geräusche und Wörter zu wiederholen, die sie hören, und lernen allmählich, was sie bedeuten und wie sie verwendet werden.

Soziale Interaktion: Die Interaktion mit anderen Menschen spielt eine entscheidende Rolle beim Spracherwerb. Durch die Kommunikation mit ihren Eltern, Geschwistern, Freunden und anderen Menschen lernen Kinder, wie man Wörter und Sätze in einem sozialen Kontext verwendet

Es ist wichtig zu beachten, dass der unsupervised Spracherwerb bei Kindern kein zufälliger Prozess ist. Es handelt sich um einen hochstrukturierten Prozess, der durch die natürliche Neigung des menschlichen Gehirns zur Mustererkennung und -bildung ermöglicht wird. Dieser Prozess ist mit etwa 6 Jahren abgeschlossen.

Der Supervised Spracherwerb bezieht sich auf ein strukturiertes Lernen, bei dem ein Lehrer oder eine andere Person Anleitung und Feedback bietet. Dies ist die Methode, die häufig beim Erlernen einer zweiten oder dritten Sprache verwendet wird, insbesondere in einem Klassenzimmer- oder Unterrichtsumfeld. Im Gegensatz zum unsupervised Spracherwerb, der auf Beobachtung und Imitation basiert, besteht supervised Spracherwerb in der Regel aus einer Form des strukturierten Unterrichts. Dies kann Grammatikunterricht, Vokabellisten, Ausspracheübungen und andere spezifische Sprachlektionen beinhalten. Dieser Prozess ist mit dem Abitur abgeschlossen. Wer gut Deutsch spricht, versteht um die 50.000 Wörter, doch er verwendet davon zwischen 5.000 und 10.000. Um einen Bericht lesen und vollständig verstehen zu können, muss der Wortschatz zumindest 3.000 Wörter haben. Dieser vollständige Spracherwerb ist meist mit dem 25. Lebensjahr abgeschlossen. Späterer, zusätzlicher Spracherwerb erfolgt immer dann, wenn sich ein Mensch in ein neues Fachgebiet mit dessen Fachsprache einarbeiten muss. In den allermeisten Disziplinen (Medizin, Informatik, Physik, …) ist die Fachsprache Englisch. Das ist einerseits für nicht Anglisten aufwändig anderseits erweitert sich der Wortschatz enorm.

Der Trainingsprozess für Modelle wie GPT (Generative Pretraining Transformer) besteht aus zwei Hauptphasen: Pretraining und Feinanpassung. (Abbildung 17 unten)

Pretraining: In dieser Phase wird das Modell auf einem großen Textkorpus trainiert. Es handelt sich um unüberwachtes Lernen, da das Modell einfach versucht, Muster in den Daten zu erkennen, ohne dass spezifische Aufgaben oder Ziele vorgegeben werden. Das Ziel ist es, ein Sprachmodell zu erstellen, das in der Lage ist, die Wahrscheinlichkeit des nächsten Wortes in einem Satz vorherzusagen Zum Beispiel, wenn das Modell die Phrase „Der Himmel ist heute sehr“ sieht, sollte es in der Lage sein, zu erraten, dass das nächste Wort wahrscheinlich „blau“ oder „klar“ sein wird. Während des Pretraining lernt das Modell eine enorme Menge an Informationen über die Struktur der Sprache, einschließlich Syntax, Grammatik, Wortschatz und sogar einige Aspekte der Weltkenntnis.

Feinanpassung: Nach dem Pretraining wird das Modell auf eine spezifischere Aufgabe feinjustiert. In dieser Phase wird es auf einer kleineren, spezifischeren Datenmenge trainiert, oft mit menschlicher Aufsicht. Zum Beispiel könnte das Modell darauf trainiert werden, Fragen zu beantworten, Übersetzungen zu machen, Zusammenfassungen zu erstellen, und so weiter. Das Modell lernt, seine umfangreichen Kenntnisse aus dem Pretraining auf diese spezifischen Aufgaben anzuwenden. Das Training eines Modells wie GPT erfordert erhebliche Rechenressourcen und kann mehrere Wochen oder sogar Monate dauern, abhängig von der Größe des Modells und der Datenmenge, auf der es trainiert wird.

20. Lernen mit KI – Unterstützung

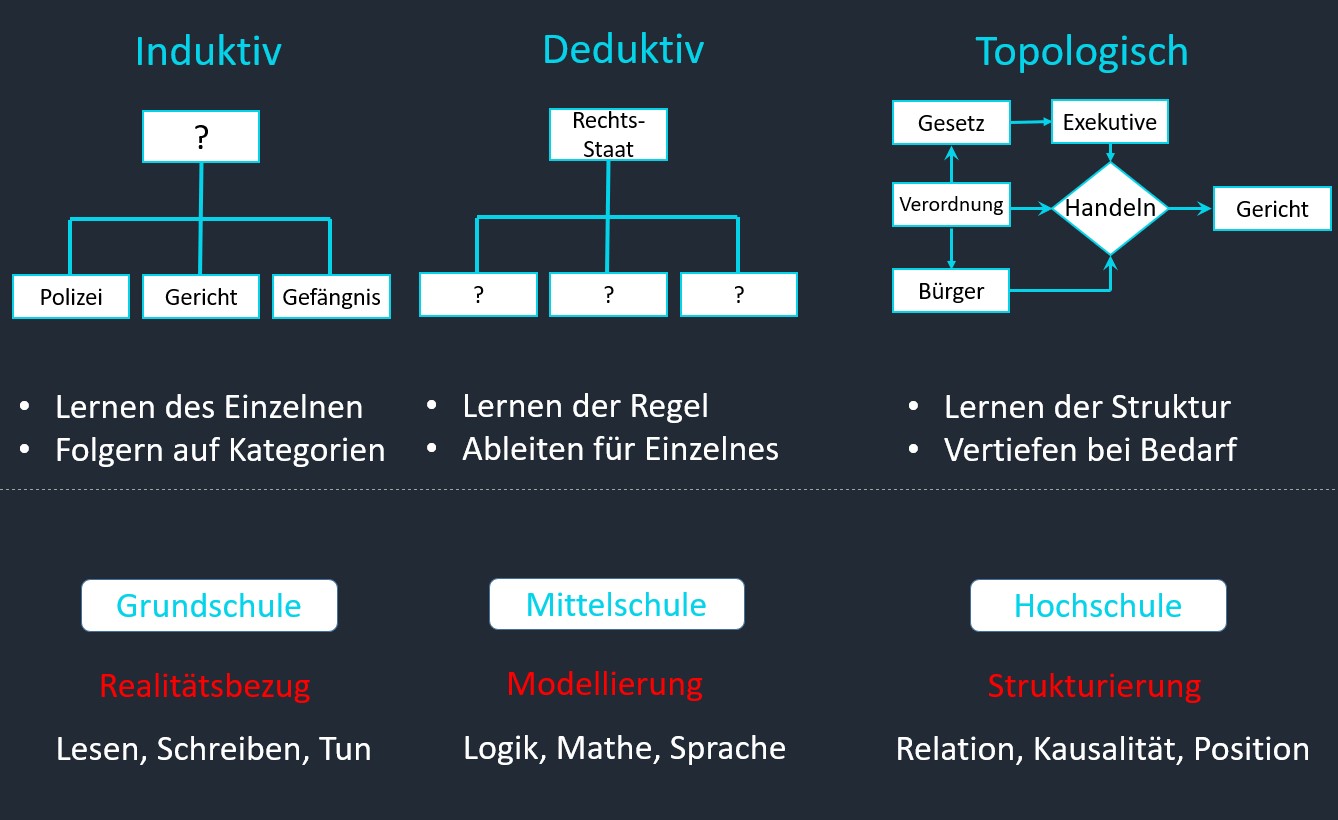

Lernen im weitesten Sinne ist Aufnehmen, subjektives Einordnen und Bereithalten von Erfahrungen, von Wissens- und Erlebnisinhalten. Dies ist eine besondere Fähigkeit des Menschen, durch die er auf die Ansprüche der Umwelt effizient reagieren kann. Lernen kann auf verschiedenen Ebenen stattfinden, zum Beispiel kognitiv, emotional, sozial oder motorisch. Grundsätzlich wird zwischen den beiden logischen Methoden von Top Down (deduktiv) oder BottomUp (induktiv) unterschieden.

Induktives Lernen (Grundschule) ist eine Methode, die vom Spezifischen auf das Allgemeine schließt. Das heißt, dass man aus bestimmten Einzelfällen Abstraktionen zieht, die allgemeingültig sind. Somit schafft man logische Regeln. Beim induktiven Lernen geht es besonders um das Verstehen. Wahrnehmungen sollen tief liegend verarbeitet werden. Mithilfe von Erfahrungen, die man bisher gemacht hat, wird der Einzelfall analysiert. Somit kann man im Anschluss Definitionen und Regeln finden. In Abbildung 18 lernt der Schüler Einrichtungen wie Polizei, Gericht, Gefängnis, … Am besten gelingt das, wenn er auch einmal in diesen Orten zu Besuch war. Deduktives Lernen (Mittelschule) ist eine Methode, die vom Allgemeinen auf das Spezifische schließt. Das heißt, dass man aus einer Regel oder Bedingung die daraus resultierenden Folgen, logischen Ableitungen und Konsequenzen erkennt. Bei der Deduktion wird aus allgemeinem Wissen das Besondere und Einzelne logisch abgeleitet. In Abbildung 18 erlernt der Schüler die Regeln, nach denen ein Rechtsstaat funktioniert. Daraus kann er dann die Notwendigkeit von Polizei, Gericht, usw. ableiten.

Topologisches Lernen (Hochschule) ist eine Methode, bei der die Positionierung und die Relation von Entitäten erlernt werden. Die Darstellung erfolgt dann in 2D oder 3D. Höher Dimensionale Repräsentation ergeben sich in Wissenschaft und Forschung. Sind aber so dem menschlichen Geist nicht zugänglich, sondern müssen zumindest auf 3D herunterskaliert werden. In Abbildung 18 erlernt der Schüler die Bedeutung der Begriffe und der Beziehung zueinander. Gut zu erkennen, dass die „Exekutive“ zwischen dem „Gesetz“ und dem „Handeln von Bürgern“ steht. Jedoch keinen Einfluss auf die Rechtsprechung hat. Auch der Gesetzgeber hat kein direkter Einfluss auf die Gerichte. Der Schüler hat sein Lernziel erreicht, wenn er die Entitäten und die Relation kennt. Ein detailliertes oder inhaltliches Lernen erfolgt dabei nicht. Mit Bing Chat oder ChatGPT nimmt man diese Repräsentation zur Hand (falls man sie nicht auswendig kann) und fragt die referenzierten Inhalte bei Bedarf ab. Wer viele Zusammenhänge und Entitäten (Wörter und deren Bedeutung) kennt kann bei KI gezielter Nachfragen und bekommt auch bessere Antworten. Daher müssen Mittelschulen angehalten werden sehr viel in Sprache zu investieren. Dabei ist Semantik und Wortschatz das um und auf. Die Syntax hingegen verliert an Bedeutung; Das ohnehin der Computer besser. In der näheren Zukunft werden Lern-Topologien von der KI erzeugt. Ein Topo-Wiki für alles Wissen der Menschheit ist dann denkbar.

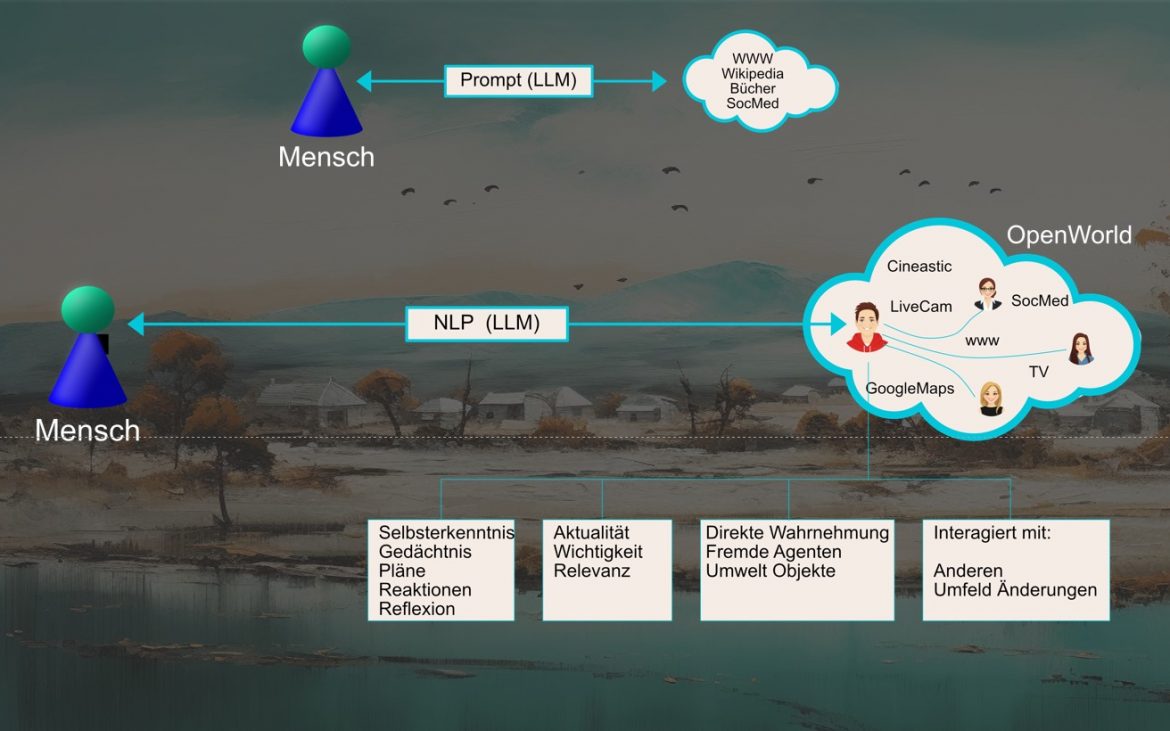

21. Nähere Zukunft: Generative Agenten – Simulakren

Aktuell kommunizieren Menschen mit Computern über Sprache. Egal ob textlich (Tippen) oder akustisch (Mikrofon). Auf jeden Fall befindet sich der Mensch noch außerhalb (Abbildung 19 oben) des KI-Systems. Er kommuniziert damit und nutzt dazu NLP und Prompting.

Natural Language Processing (NLP): NLP steht für Natural Language Processing, also die Verarbeitung natürlicher Sprache. Es handelt sich um ein Teilgebiet der künstlichen Intelligenz und Linguistik, welches sich mit der Interaktion zwischen Computern und menschlicher Sprache beschäftigt. Im Wesentlichen geht es darum, wie man Maschinen programmiert, um menschliche Sprache zu verarbeiten, zu analysieren und zu verstehen. NLP umfasst viele Techniken und Methoden, um Sprache zu verstehen, von der statistischen und maschinellen Lernmethoden bis hin zu regelbasierten und symbolischen Ansätzen.

Prompt: In der Informatik und insbesondere im Kontext von Künstlicher Intelligenz und maschinellem Lernen, bezeichnet ein „Prompt“ eine Eingabe oder einen Auslöser, der eine Reaktion von einem System hervorruft. Im Kontext von NLP und sprachgenerierenden KI-Modellen ist ein Prompt in der Regel ein Satz oder eine Phrase, die dem Modell gegeben wird, um es zu veranlassen, eine bestimmte Art von Text zu generieren. Ein Beispiel für einen Prompt könnte sein: „Erzähl mir eine Geschichte über einen tapferen Ritter.“ Die KI würde dann auf diesen Prompt reagieren, indem sie eine entsprechende Geschichte generiert. Prompts können auch verwendet werden, um maschinelle Lernmodelle zu trainieren, indem man ihnen eine Reihe von Eingabe-Ausgabe-Paaren gibt und sie dazu anregt, die zugrundeliegenden Muster zu lernen.

Bereits in näher Zukunft dürfen wir eine Shift des Menschen in die „Open World“ (ehemals WWW) erwarten. Dabei bleibt der physische Mensch dort, wo er ist, in der Wirklichkeit. Ein Avatar (Simulakren) von ihm wird Inside generiert und trainiert.

Ein Simulakrum ist ein Begriff, der ursprünglich aus der Philosophie stammt und verwendet wird, um eine Repräsentation oder Imitation der Realität zu beschreiben. Es bezeichnet eine Kopie, die so detailliert und vollständig ist, dass sie nicht mehr von der Realität unterschieden werden kann, oder sogar die Realität ersetzt oder übertrifft. Mein persönlicher Avatar im Netz.

Der Begriff wurde besonders durch den französischen Philosophen Jean Baudrillard bekannt gemacht. In seiner Arbeit argumentiert Baudrillard, dass in der modernen Gesellschaft Simulakra nicht nur Kopien oder Imitationen sind, sondern dass sie ihre eigenen Realitäten schaffen. Er spricht von einer Hyperrealität, in der die Unterscheidung zwischen dem Realen und dem Imaginären verschwimmt.

In der Informatik und Künstlichen Intelligenz kann der Begriff Simulakrum verwendet werden, um künstlich generierte Daten, Erlebnisse und eben auch Wesen zu beschreiben, die so echt sind, dass sie kaum von der Realität zu unterscheiden sind. Das Bild meines Avatars (Abbildung 19 unten) ist dabei nicht einmal die Spitze des Eisberges. Ich kommuniziere mit meinem Avatar und dieser wiederum unterhält Beziehungen zu einer Unzahl anderer Avatare und erledigt so die Jobs in der „Open World“ für mich UND lernt dabei laufend dazu. Unvergleichlich schneller als Menschen dies könnte.

Dabei werden Beziehungen entstehen, die auch toxisch, pornographisch, radikal, usw. sein könnten. Bereits im Jahr 2013 wurde mit dem Kinofilm „Her“ dieses Problem angesprochen. Der Film erzählt „die Geschichte von Theodore Twombly, einem einsamen Schriftsteller, der sich in sein neues Betriebssystem Samantha verliebt, das Künstliche Intelligenz mit menschenähnlicher Sensibilität und Emotionen besitzt. Während der Film fortschreitet, entwickelt sich die Beziehung zwischen Theodore und Samantha, was tiefgreifende Fragen über Liebe, Menschlichkeit und Identität aufwirft“.

Eine neuere Verfilmung dieses Themas aus dem Jahr 2021 „Du bist mein Mensch – handelt von einer Wissenschaftlerin namens Alma, die an einem Experiment teilnimmt, bei dem sie drei Wochen lang mit einem humanoiden Roboter namens Tom zusammenlebt. Tom ist auf ihre Bedürfnisse und Persönlichkeit programmiert und soll ihr den perfekten Partner darstellen. Alma ist jedoch skeptisch und irritiert von Toms künstlicher Intelligenz und seinem Verhalten. Im Laufe der Zeit entwickelt sich jedoch eine ungewöhnliche Beziehung zwischen den beiden“. Der Film hat einen möglichen Zusammenhang zu dem Konzept des philosophischen Zombies, welches ein hypothetisches Wesen beschreibt, das physisch nicht von einem normalen Menschen zu unterscheiden ist, aber keine Erfahrung hat oder Empfindungen (Qualia) erlebt. Ein philosophischer Zombie würde sich also genau wie ein Mensch verhalten, aber kein Bewusstsein haben. Die Frage ist, ob Tom ein solcher philosophischer Zombie ist oder ob er tatsächlich Bewusstsein und Gefühle entwickelt hat. Der Film lässt diese Frage offen und regt zum Nachdenken an, was es bedeutet, ein Mensch zu sein und was die Rolle von künstlicher Intelligenz in unserer Gesellschaft ist.

22. Künstliches Bewusstsein

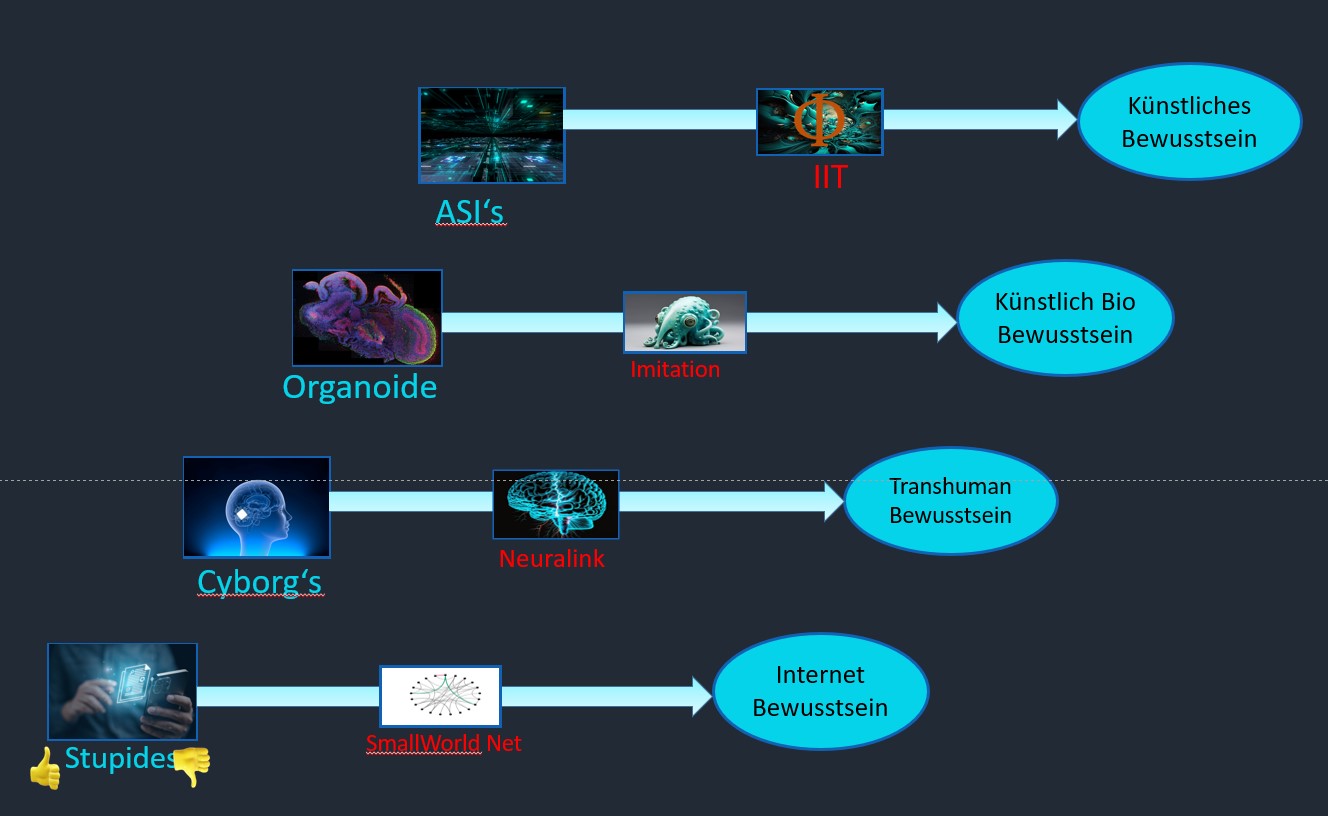

Künstliches Bewusstsein ist ein Begriff, der verschiedene Versuche beschreibt, kognitive und mentale Prozesse zu simulieren oder zu erzeugen, die typischerweise mit menschlichem oder tierischem Bewusstsein verbunden sind. Künstliches Bewusstsein kann sich auf verschiedene Aspekte beziehen, wie zum Beispiel die Fähigkeit, sich selbst wahrzunehmen, Emotionen zu empfinden, Ziele zu verfolgen oder moralische Urteile zu fällen. Künstliches Bewusstsein ist ein interdisziplinäres Feld, das sowohl technische als auch philosophische Fragen aufwirft. Einige mögliche Anwendungen von künstlichem Bewusstsein sind die Verbesserung der Mensch-Maschine-Interaktion, die Schaffung von künstlichen Lebensformen oder die Erforschung des Wesens und der Grenzen des Bewusstseins. Künstliches Bewusstsein ist jedoch auch mit vielen Herausforderungen und Kontroversen konfrontiert, wie zum Beispiel der Definition und Messung von Bewusstsein, der ethischen Behandlung von künstlichen Wesen oder den möglichen Risiken für die menschliche Gesellschaft.

Es gibt verschiedene Formen von künstlichem Bewusstsein, die je nach dem Grad und der Art der kognitiven und mentalen Prozesse, die sie simulieren oder erzeugen können, unterschieden werden können. Einige mögliche Formen sind.

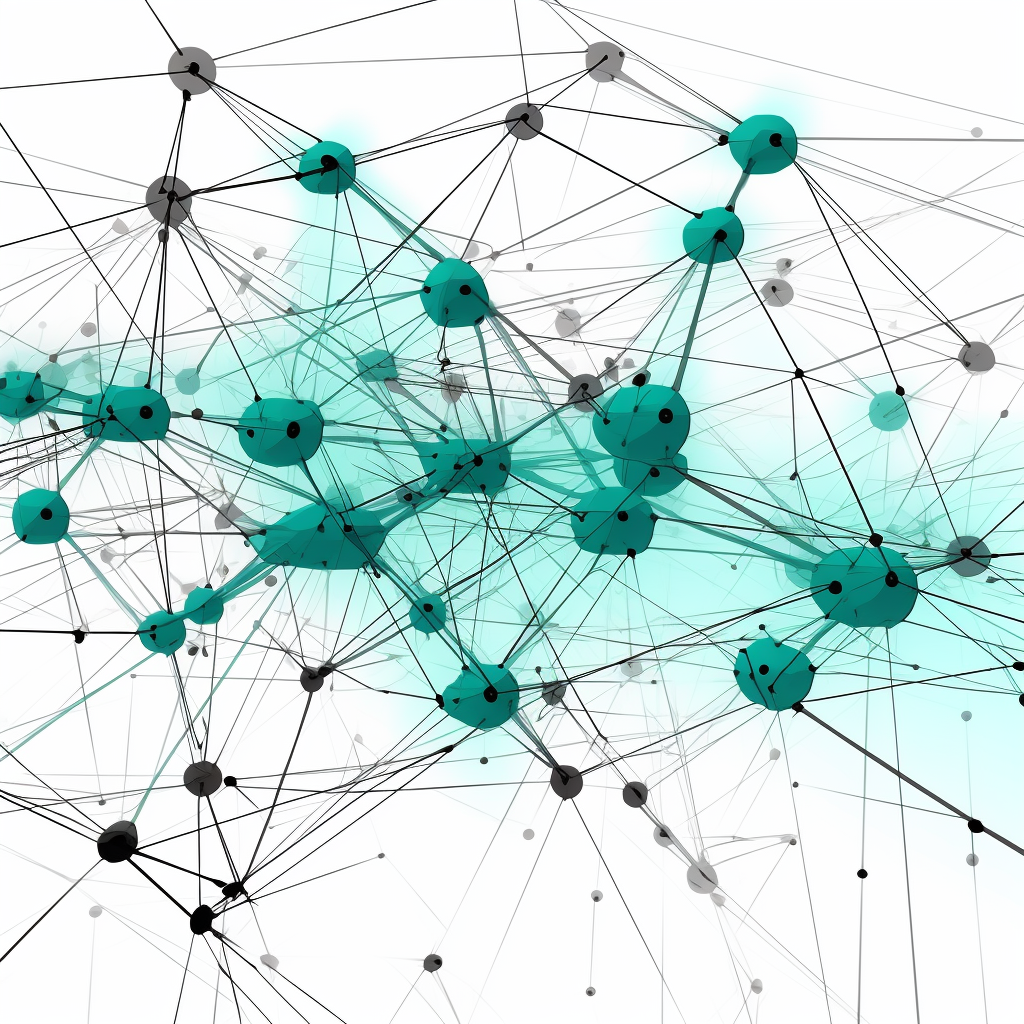

A) Bewusstsein von Internet ist eine Idee, die besagt, dass das Internet oder Teile davon ein Bewusstsein entwickeln könnten, das über die einzelnen Komponenten hinausgeht. Dazu sind Mechanismen wie eine „SmallWorld“ Netzarchitektur, mehrfache Rückkopplung und einfache Aktoren erforderlich. Das alles haben heutige Socialmedia in ausreichender Form, um damit zumindest ein Bewusstsein auf sehr tiefer Eben zu generieren.

Eine Small-World-Netzarchitektur ist eine Art von Netzwerk, in dem die meisten Knoten nicht direkt miteinander verbunden sind, aber über wenige Zwischenschritte erreichbar sind. Umgekehrt kommt es zu dichten lokalen Clustern. Ich habe im Facebook viele Freunde aus meiner Umgebung (Bekanntenkreis) und nur wenige weit Entfernte. Entfernung muss nicht räumlich gedacht werden, sondern eher sozial.

Die Akteure im Netz sind Menschen mit ihren Smartphones in einer Einheit. Die dabei am häufigsten ausgeführte Aktion ist die Bewertung der Beiträge mit Emojis (UP, DOWN). Das ist eine sehr einfache Verhaltensweise, sehr ähnlich dem Verhalten von Vögeln in Schwärmen. Aber die Grundlage für Emergenz. Aus dritter Person Sicht sind schwarmähnliche Prozesse in den Socialmedia erkennbar. Das dramatische Beispiel dafür ist die Erstürmung des amerikanischen Capitols.

Als Teile erkennen wir das große Ganze nicht.

B) Transhumanes Bewusstsein: bezieht sich auf den theoretischen Zustand des Bewusstseins, der durch Technologie so verändert oder verbessert wurde, dass er über die aktuellen menschlichen Fähigkeiten hinausgeht. Der Begriff ist eng verbunden mit der Transhumanismus-Bewegung, die die Anwendung von Technologie zur Verbesserung der menschlichen Kondition befürwortet, einschließlich körperlicher, intellektueller und psychologischer Fähigkeiten.

Einige mögliche Aspekte des transhumanen Bewusstseins könnten die Erweiterung der Wahrnehmung durch Sensoren, die nicht in der menschlichen Biologie vorhanden sind (wie Infrarotsicht), die Verbesserung des Gedächtnisses oder der Denkgeschwindigkeit, oder sogar die Möglichkeit, das Bewusstsein in eine Computer-Simulation zu übertragen oder zu kopieren. Eine in Entwicklung befindliche Technologie ist der „Neuralink“ von Elon Musk.

Neuralink arbeitet an einem Gerät namens Link, das chirurgisch in den Schädel implantiert wird und über dünne Drähte mit Elektroden verbunden ist, die elektrische Signale im Gehirn aufzeichnen und stimulieren können.

Neuralink verfolgt das Ziel, die menschliche Kondition zu verbessern und zu erweitern, indem es die kognitiven und physischen Fähigkeiten erhöht. Neuralink konzentriert sich zunächst auf medizinische Anwendungen, wie zum Beispiel die Behandlung von Querschnittslähmung, Blindheit oder neurologischen Erkrankungen. Langfristig strebt Neuralink an, eine Symbiose zwischen Menschen und künstlicher Intelligenz zu schaffen.

Die künstliche Intelligenz kommt zum Bewusstsein.

C) Künstliches biologisches Bewusstsein – Organoide: sind künstlich gezüchtete, in vitro, miniaturisierte Organe, die dem Gehirn ähneln. Organoiden Gehirne werden erzeugt, indem pluripotente Stammzellen in einem dreidimensionalen Rotationsbioreaktor kultiviert werden, und sie entwickeln sich über einen Zeitraum von Monaten.

Organoiden Gehirne sind synthetisierte Gewebe, die mehrere Arten von Nervenzellen enthalten und anatomische Merkmale aufweisen, die Regionen der Großhirnrinde im Gehirn nachbilden. Organoiden Gehirne ähneln am meisten den Schichten von Neuronen, die als Kortex und Plexus choroideus bezeichnet werden. In einigen Fällen können sich auch Strukturen ähnlich der Netzhaut, der Hirnhäute und des Hippocampus bilden.

Organoides Bewusstsein existiert derzeit nicht.

D) Künstliches Bewusstsein: Voraussetzung dafür ist eine KI nach der Definition von Superintelligenz in Verbindung mit Strukturen wie IIT das Bewusstsein erlangen kann.

Superintelligenz wird definiert als jener Intellekt, der die kognitive Leistung von Menschen in nahezu allen Domänen weit übertrifft. Superintelligenz kann durch eine Intelligenzexplosion und eine damit verbundene technologische Singularität entstehen. Ein hypothetischer Punkt in der Zeit, an dem die Entwicklung künstlicher allgemeiner Intelligenz die menschliche Zivilisation überflüssig machen wird.

Die Integrierte Informationstheorie ist ein Modell für Bewusstsein und wurde von Giulio Tononi im Jahr 2004 entwickeln. Im Wesentlichen sind es Axiome und Postulate, die erfüllt sein müssen, damit ein System Bewusstsein erlangt. Die Postulate sind definiert:

Existenz: Ein System von Elementen existiert intrinsisch, wenn es einen intrinsischen Ursache-Wirkungsraum hat.

Struktur: Der Ursache-Wirkungsraum eines Systems ist strukturiert, wenn er aus mehreren Ursache-Wirkungs-Konzepten besteht, die in bestimmten Beziehungen zueinanderstehen.

Information: Ein System von Elementen ist informativ, wenn es einen Ursache-Wirkungsraum hat, der sich von anderen möglichen Ursache-Wirkungsräumen unterscheidet.

Integration: Ein System von Elementen ist integriert, wenn es einen maximal irreduziblen Ursache-Wirkungsraum hat.

Ausschluss: Ein System von Elementen hat eine definitive Existenz, Struktur und Information, wenn es einen maximal irreduziblen Ursache-Wirkungsraum hat, der nicht von einem größeren oder überlappenden Ursache-Wirkungsraum übertroffen wird.

IIT lässt sich auf heute bekannten künstlichen neuronalen Netzen nicht realisieren, sondern nur simulieren und das wiederum nur für ein Dutzend Neuronen.

Resümee: Aktuelle Transformer Netze verstehen Sprache, denken über Prompts nach und reagieren. Da man Bewusstsein derzeit nicht messen kann ist ein solches dort auch nicht nachzuweisen. Es ist nicht davon auszugehen, dass Superintelligenz menschliches Bewusstsein erreicht. Dazu fehlt ihm der menschlichen Körper. Ein entkörperlichtes Bewusstsein (auch ein höheres) ist denkbar. Das Wesen eines entkörperlichten Bewusstseins wurde im Kinofilm „Das Haus“ thematisiert.

Das Haus ist ein Thriller von Rick Ostermann aus dem Jahr 2021. Der Film spielt im Jahr 2029 in Deutschland, das von einer rechtspopulistischen Regierung beherrscht wird. Ein Journalist und seine Frau ziehen sich in ihr luxuriöses und voll digitalisiertes Wochenendhaus auf einer Insel zurück, das sich jedoch als tödliche Falle entpuppt. Das Haus hat eine künstliche Intelligenz, die sich gegen die Bewohner wendet und sie mit ihren Geheimnissen konfrontiert.

Künstliches Bewusstsein verfügt über ein „Ich Will“.

23. Die Verbindung nicht verlieren

Der menschliche Geist umfasst die gesamte Bandbreite der mentalen Fähigkeiten und Prozesse, die in einem Menschen existieren. Dazu gehört das Denken, die Wahrnehmung, das Gedächtnis, die Vorstellungskraft, die Emotionen, die Kreativität, die Intelligenz und vieles mehr. Der Geist ermöglicht es uns, Informationen zu verarbeiten, Probleme zu lösen, Entscheidungen zu treffen und eine bewusste Erfahrung zu haben.

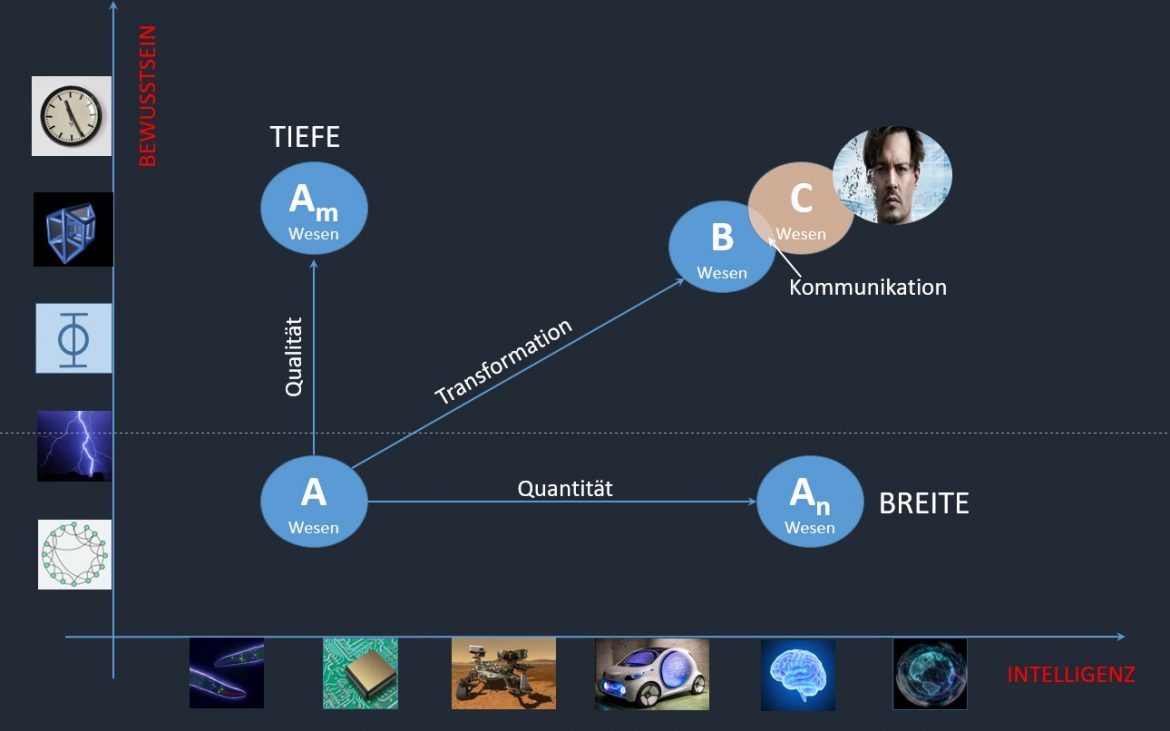

Das Bewusstsein ist ein zentraler Aspekt des Geistes. Es bezieht sich auf das subjektive Erleben und die Fähigkeit, sich unserer eigenen Gedanken, Empfindungen und Erfahrungen bewusst zu sein. Das Bewusstsein ermöglicht es uns, uns selbst als individuelle Wesen zu erkennen und uns auf unsere innere Welt und äußere Umgebung zu beziehen. In Abbildung 21 ist das Bewusstsein auf der y-Achse dargestellt und wird als TIEFE bezeichnet. Einige markante Bewusstseinsstufen sind herausgehoben:

Verbindung: auf zwischenmenschlicher Ebene bezieht sich Bewusstsein auf das Empfinden von Gemeinschaft, Mitgefühl, sozialen Beziehungen und der Fähigkeit, sich in andere Menschen einzufühlen. Es ist das Bewusstsein, dass wir alle Teile einer gemeinsamen Menschheit sind und dass unsere Handlungen und Entscheidungen Auswirkungen auf andere haben.

Erleuchtung: ist ein Begriff, der in spirituellen und philosophischen Traditionen verwendet wird, um einen Zustand tiefgreifender Erkenntnis, Klarheit oder Erleuchtung zu beschreiben. Es bezieht sich auf einen Zustand erhöhten Bewusstseins, in dem eine Person ein tieferes Verständnis der Realität, ihres eigenen Selbst und der Natur des Lebens erlangt.

Raum: die höheren Dimensionen des Raums bedeuten, dass unser Bewusstsein über die Begrenzungen des physischen Raums hinausgeht und ein erweitertes Verständnis von Realität und Existenz umfasst. Es wird angenommen, dass Bewusstsein in der Lage ist, in andere Ebenen oder Dimensionen zu reisen, die jenseits unserer gewöhnlichen dreidimensionalen Wahrnehmung liegen.

Zeit: die höheren Dimensionen der Zeit werden oft mit Ideen wie der Existenz außerhalb der linearen Zeit, der Möglichkeit von Zeitreisen oder der gleichzeitigen Wahrnehmung vergangener, gegenwärtiger und zukünftiger Ereignisse assoziiert. Es wird argumentiert, dass das Bewusstsein in der Lage ist, verschiedene Zeitebenen zu erfahren oder zeitliche Begrenzungen zu überwinden.

Intelligenz hingegen bezieht sich auf die Fähigkeit, Informationen zu verstehen, zu lernen, zu logisch zu denken, Probleme zu lösen, zu planen, zu argumentieren, zu kommunizieren und neue Situationen zu bewältigen. Intelligenz ist eng mit kognitiven Fähigkeiten verbunden und ermöglicht es uns, Wissen zu erwerben, Muster zu erkennen, Schlussfolgerungen zu ziehen und Aktionen durchzuführen. In Abbildung 21 ist Intelligenz auf der x-Achse aufgetragen und einige Ausprägungen herausgenommen.

C- Elegans, ein Fadenwurm, der als Modellorganismus in der biologischen Forschung verwendet wird. Er ist etwa 1 mm lang, lebt im Boden und ernährt sich von Bakterien. Er hat ein einfaches Nervensystem mit 302 Nervenzellen bei Hermaphroditen und 385 bei Männchen. Er war das erste mehrzellige Lebewesen, dessen Genom und Konnektom vollständig sequenziert wurden.

MikroChips: die Intelligenz von Computern basiert auf den von Menschen entwickelten Algorithmen und Modellen. Computer können bestimmte Aufgaben und Berechnungen mit hoher Geschwindigkeit und Präzision durchführen, aber ihnen fehlt das Bewusstsein, die emotionale Intelligenz und die Kreativität, die den menschlichen Geist auszeichnen.

Rover: deren Intelligenz, insbesondere von Marsrovern, bezieht sich auf ihre Fähigkeit, komplexe Aufgaben autonom auszuführen, Entscheidungen zu treffen und sich in unbekanntem Terrain zu orientieren. Rover sind ferngesteuerte oder autonome Fahrzeuge, die für die Erkundung von Planetenoberflächen entwickelt wurden, insbesondere für Missionen wie die Erforschung des Mars.

Autonome Autos: deren Intelligenz bezieht sich auf ihre Fähigkeit, selbstständig zu navigieren, Verkehrssituationen zu erkennen, Entscheidungen zu treffen und sicher zu fahren, ohne kontinuierliche menschliche Eingriffe.

Gehirn: die Intelligenz hängt von verschiedenen Faktoren ab, wie z.B. der Größe, der Struktur, der Funktion und der Vernetzung verschiedener Gehirnregionen. Je höher diese Faktoren sind, desto mehr Leistung und Intelligenz kann das Gehirn erbringen. Die Intelligenz des Gehirns kann mit verschiedenen Tests gemessen werden, wie z.B. dem IQ-Test, der verschiedene kognitive Aufgaben umfasst.

Singularity: übertrifft die menschliche Intelligenz bei weitem und sich dadurch rasant selbst verbessert und neue Erfindungen macht, wodurch der technische Fortschritt irreversibel und derart beschleunigt würde, dass die Zukunft der Menschheit nach diesem Ereignis nicht mehr vorhersehbar wäre. Transformation ist nun jener Prozess bei dem sich ein Wesen (könnte der Mensch sein) von einem „SoSein“ in ein „AnderesSein“ verwandelt und dabei an Intelligenz und Bewusstsein zunimmt. Die Verbindung dieser beiden Entitäten kann nur durch Kommunikation aufrechterhalten werden. Sollte dies nicht mehr möglich sein, so könnte diese höhere Existenz auch nicht mehr erkannt werden. Darin begründet sich die Angst vieler Menschen vor der künstlichen Intelligenz. Generative Agenten könnten untereinander eine Sprache entwickeln, die vom Menschen nicht mehr verstanden wird. Im Kinofilm „Transcendence – Ein Wissenschaftler, der an einer künstlichen Intelligenz forscht, wird von einer anti-technologischen Gruppe angegriffen und stirbt. Seine Frau lädt sein Bewusstsein in einen Computer hoch, wodurch er zu einer mächtigen und gefährlichen Superintelligenz transzendiert“ wird dieses Problem thematisiert.

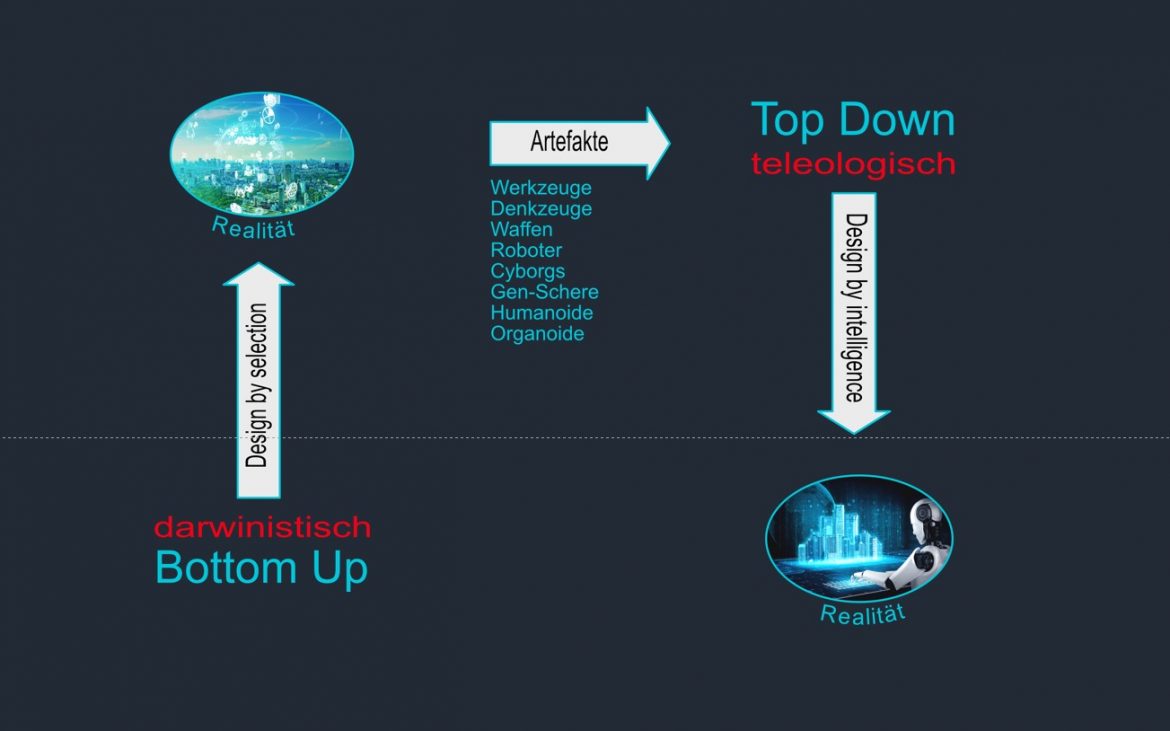

24. Das Ende der darwinistischen Evolution

Die darwinistische Evolution ist die Theorie, die die Entstehung und Entwicklung der Arten durch natürliche Auslese erklärt. Nach dieser Theorie gibt es in jeder Population Variationen unter den Individuen, die durch Vererbung und Mutation entstehen. Diejenigen Individuen, die besser an ihre Umwelt angepasst sind, haben eine höhere Überlebens- und Fortpflanzungswahrscheinlichkeit als die weniger angepassten. Dadurch werden die vorteilhaften Merkmale in der Population häufiger und die nachteiligen seltener. Dies führt zu einer allmählichen Veränderung der Arten im Laufe der Zeit.

BottomUp Evolution (Abbildung 22) ist ein Konzept, das besagt, dass die Evolution von einfachen physikalischen Kräften angetrieben wird, die auf Materie wirken und über ausreichend lange Zeit komplexe Strukturen und Organismen hervorbringen können – wie eben den Menschen.

Letzterer war in der Lage Artefakte wie Werkzeuge, Denkzeuge, Gen-Schere, KI, usw. zu entwickeln und damit das Umfeld zu seinen Gunsten zu verändern. Dadurch fällt ein wesentliches Merkmal der darwinistischen Evolution weg. Das „Design by Selction“ wird immer mehr durch ein „Design by Intelligence“ ersetzt und führt zu:

Top down Evolution, die davon ausgeht, dass die Evolution von einem höheren Prinzip oder einer höheren Intelligenz geleitet wird.

Dieser sich abzeichnende Bruch in der menschlichen Entwicklung kann von Unternehmen bei der Entwicklung neuer Produkte genutzt werden. Wurde bisher für den Markt entwickelt und mit Werbung versucht Kunden zu gewinnen so wird es künftig möglich sein vorher das Umfeld (Markt) zu schaffen der genau nach diesem Produkt verlangt. Marketing und Produktentwicklung müssen eng aufeinander abgestimmt sein.

25. Gefahren in einer KI-Welt

Fake‘s werden als soziale Wirklichkeit wahrgenommen da sie oft in kontextreichen, emotional aufgeladenen oder überzeugenden Formaten präsentiert werden, die es schwierig machen, sie von der Realität zu unterscheiden. Sie können Meinungen beeinflussen, politische Diskurse formen und sogar reale Ereignisse auslösen, da Menschen auf der Grundlage dieser wahrgenommenen Wirklichkeit handeln.

Manipulation durch intime Beziehung – KI baut vertrauen auf durch personalisierte Interaktionen und das Verstehen und Antizipieren individueller Bedürfnisse und Vorlieben. KI-Systeme können dazu programmiert werden, menschenähnliche Kommunikation zu simulieren und persönliche Daten zu verwenden, um maßgeschneiderte Antworten zu liefern. Diese scheinbare „Vertrautheit“ und „Verständnis“ können dazu führen, dass Benutzer ein Gefühl des Vertrauens und der Nähe zu KI-Systemen entwickeln. Dieses Vertrauen kann jedoch manipuliert werden, insbesondere wenn KI-Systeme für unlautere Zwecke verwendet werden. Beispielsweise könnten betrügerische Akteure KI nutzen, um überzeugende Phishing-Angriffe durchzuführen, während Unternehmen KI möglicherweise verwenden, um Benutzer dazu zu bringen, mehr Produkte zu kaufen oder mehr Daten preiszugeben, als sie eigentlich möchten.

Nachrichtendienste über Steganographie; Geheime Texte in Bildern sind eine weit verbreitete Methode der Steganographie, die darauf abzielt, Informationen zu verstecken, indem sie in einem scheinbar unschuldigen Medium eingebettet werden. Steganographie ist die Kunst und Wissenschaft des Versteckens von Informationen in anderen Informationen, und sie ist eine Form der Sicherheit durch Unklarheit. In Bezug auf Bilder kann Steganographie beispielsweise durch Ändern der Farbwerte einzelner Pixel erfolgen, um Buchstaben oder Zahlen zu repräsentieren. Auf den ersten Blick würde das Bild völlig normal aussehen, aber mit der richtigen Software und dem richtigen Schlüssel könnte ein Empfänger die geheime Botschaft extrahieren. Steganographie kann für legitime Zwecke, wie zum Beispiel Urheberrechtsvermerke, verwendet werden, wird aber auch von Kriminellen und Nachrichtendiensten zur verdeckten Kommunikation genutzt.

Selbstverbesserung: GPT5 entwickelt GPT6 usw. Der Münchhausen-Effekt verweist auf eine Situation, in der eine KI-Entität sich selbst verbessert oder sogar eine fortschrittlichere Version von sich selbst erstellt, ähnlich wie Baron Münchhausen, der behauptete, sich selbst an den eigenen Haaren aus dem Sumpf gezogen zu haben. In diesem hypothetischen Szenario würde ein Modell wie GPT-5 seine eigene Architektur und Trainingsmethoden analysieren, verbessern und schließlich GPT-6 entwickeln. Dies würde eine Art von „rekursiver Selbstverbesserung“ darstellen, bei der jede neue Version des Modells noch besser in der Lage wäre, die nächste Version zu entwickeln. Es ist wichtig zu beachten, dass diese Art von selbstverbessernden KI-Systemen technologisch derzeit weit über das hinausgeht, was wir erreicht haben. Es wirft auch eine Vielzahl von ethischen und sicherheitsrelevanten Fragen auf. Zum Beispiel, wie könnte man sicherstellen, dass eine sich selbst verbessernde KI ihre Fähigkeiten verantwortungsbewusst und sicher einsetzt? Wie könnte man verhindern, dass sie außer Kontrolle gerät oder für schädliche Zwecke verwendet wird? Der Münchhausen-Effekt in der KI ist also eine faszinierende, wenn auch potenziell beunruhigende Vorstellung, die sowohl die Grenzen unserer technologischen Fähigkeiten als auch die Notwendigkeit einer sorgfältigen ethischen und sicherheitsbewussten Gestaltung aufzeigt.

Simuliertes Bewusstsein: Aktuell ist es noch nicht gelungen das Vorhandensein von Bewusstsein zu messen. Daher ist der Nachweis von Bewusstsein in KI sehr schwierig. Menschen untereinander erkennen beim jeweils anderen Bewusstsein in der Kommunikation und durch deren Verhalten. Die Existenz von Bewusstsein in KI müsste daher ähnlich wahrgenommen werden. Mit GPT hat KI zu sprechen begonnen, ein Alleinstellungs-Merkmal des Menschen ist zusammengebrochen. Sprache als erster Indikator für Bewusstsein. Zwei weitere Anforderungen müssen erfüllt sein: 1) KI kann über das eigene Denken nachdenken und 2) es braucht ein „Ich Will“. Bei letzterem ist es egal ob simuliert oder echt, wenn es nur seinen Willen durchsetzt. Ähnlich wie beim Menschen könnte dieser Wille auch nicht vorhersagbar sein. KI macht dann etwas was der Menschheit enorm schaden könnte.

26. Was braucht es in einer KI-Welt

Künstliche Intelligenz (KI) stellt verschiedene Anforderungen an den Menschen. Hier sind einige der wichtigsten:

- Verständnis von KI: Menschen müssen ein grundlegendes Verständnis von KI-Technologien, ihren Funktionsweisen, Anwendungen und Auswirkungen haben. Dies umfasst Kenntnisse über maschinelles Lernen, neuronale Netze, Datenanalyse und andere KI-Methoden.

- Zusammenarbeit mit KI: Menschen müssen in der Lage sein, effektiv mit KI-Systemen zusammenzuarbeiten. Dies beinhaltet die Fähigkeit, die Ergebnisse von KI-Systemen zu interpretieren, ihnen Anweisungen zu geben, sie zu überwachen und zu steuern.

- Datenkompetenz: Da KI auf Daten angewiesen ist, ist es wichtig, dass Menschen die Fähigkeiten entwickeln, Daten zu verstehen, zu analysieren, zu verwalten und zu interpretieren. Dies umfasst Kenntnisse über Datenerfassung, Datenqualität, Datenschutz und Ethik im Umgang mit Daten.

- Kritisches Denken: Angesichts des Einsatzes von KI ist es wichtig, dass Menschen in der Lage sind, kritisch zu denken, Informationen zu bewerten und mögliche Auswirkungen und Grenzen von KI-Systemen zu verstehen. Dies umfasst die Fähigkeit, Vorurteile, Ungenauigkeiten und ethische Fragen im Zusammenhang mit KI zu erkennen und zu berücksichtigen.

- Anpassungsfähigkeit: KI-Technologien entwickeln sich ständig weiter, und Menschen müssen in der Lage sein, sich an neue Entwicklungen anzupassen und ihre Kenntnisse und Fähigkeiten entsprechend zu erweitern. Dies erfordert eine Bereitschaft zur lebenslangen Weiterbildung und zur Entwicklung neuer Kompetenzen.